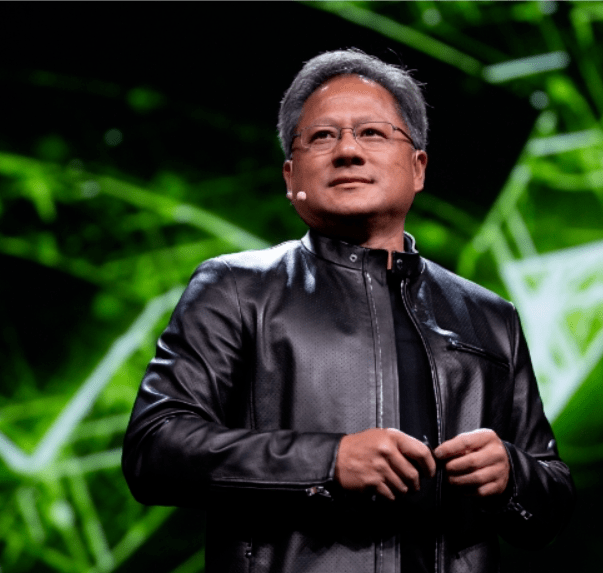

英伟达CEO黄仁勋 图片来源:https://www.nvidia.com/en-us/

5月30日,芯片制造企业英伟达的市值突破1万亿美元,成为全球第7家市值达到万亿美元的公司。

现在,还留在万亿美元俱乐部的成员包括苹果、亚马逊、谷歌、微软、英伟达,其他的公司则是过客。

英伟达市值一万亿美元,折合人民币大概71万亿元。与其他四家有非常广泛的业务线不同,英伟达专注于芯片制造,因此英伟达也成为第一家市值达到万亿美元的芯片制造商,也是AI芯片全球最大的赢家。

那么,英伟达为什么会成为万亿市值公司的一员?未来,是常住还是一个过客呢?

01

没有“纯粹的”人工智能股,GPU让英伟达成为AI代名词

目前全球还没有“纯粹的”人工智能股,大量参与人工智能的上市公司大多数都有基础业务产品,人工智能只是其辅助工具。而专注于人工智能硬件包括加速芯片几十年的英伟达,在大模型流行时代,就被认为是AI领域的主导者。

世上芯片千千万,为何只有英伟达的芯片成为人工智能领域独一无二的玩家?而英伟达这一向来在显卡称霸的公司,又为何能在深度学习和人工智能领域打下这么大的一片江山呢?

1999年,初露头角的英伟达首次推出了图形处理器GPU这一加速计算的概念。在此之前,包括英特尔在内的CPU厂商都坚信图形处理是CPU的活,CPU干的事情越多越好,将图形工作独立到另一个附属处理器上的想法就是“食之无味,弃之可惜”的“鸡肋”。

微软在GPU发展上有两次技术创新:一是开发出了Direct X这一标准化的API图形接口, 此后大量的图形功能从CPU中被转移到GPU上;二是引入统一渲染技术,即让GPU将图形绘制的顶点计算和之后的渲染两个步骤合并。微软和显卡领域另一知名公司ATI合作了GPU Xenos,成功应用了这一技术。

英伟达的在GPU上的贡献包括:

一是推出了革命性CUDA架构,GPU流处理器进行了细致的分组,变成一个个小型流处理器且能单独运行,极易控制和调度,让编程难度大大降低;

二是引入了Tensor Core计算单元概念,专门为深度学习而设计,支持更低精度的运算从而大幅节省了模型算力。

三是英伟达在试错过程中建立起了完整的生态。

英伟达率先推出加速计算,着力解决AI应用中普通计算机无法解决的问题。AI加速计算并非易事,它需要从芯片、系统、网络、加速库到重构应用的全栈发明。从图形、成像、粒子或流体动力学、量子物理学到数据处理和机器学习,每个经过优化的堆栈都会加速对应应用领域。

加速后,应用可以获得令人难以置信的速度,还可以扩展到许多台计算机。在过去十年中,

加速和纵向扩展的结合,为许多应用实现百万倍的性能提升,进而有助于解决以前无法解决的问题。

因此,GPU的通用性更佳,比专用芯片更适应变化。同样英伟达拥有完整生态,让GPU成为当下最合适的选择。这就是英伟达GPU打败其他芯片,成功吃下AI红利的主要原因。

如果在十年前,在芯片制造商中,英特尔、AMD、高通等气贯长虹,不可一世。时事轮流转,现在到了人工智能时代!新一轮的科技革命的核心是AI,企业也从数字化转型迅速发展到智能化转型。

而最近三天,北、上、深三市相继表态支持人工智能发展。北京提出推动国产人工智能芯片实现突破,深圳聚焦智能算力芯片研发,上海支持民营企业广泛参与数据、算力等人工智能基础设施建设。

而美国政府要求英伟达最强大的“武器”GPU H100对中国禁售。看来,发展AI芯片成为AI产业发展一个基础。

02

大模型让GPU从游戏横跨到AI

2022年秋天,英伟达CEO黄仁勋(Jensen Huang)表示,公司制造了太多的游戏GPU,被迫以更低的价格出售。

该公司历来是所谓的独立显卡或独立GPU领域的领导者,但直到现在,许多消费者还认为GPU主要用于密集游戏。

但是大模型引导的AI 应用热潮,让英伟达GPU从显卡横跨到了AI。现在,不管是A100芯片及更高一代的H100芯片,英伟达的这些高端芯片已是一卡难求。

算力是数据中心处理数据并输出的能力,数据、算力及模型历来是人工智能发展的三要素。AI大模型的算力需求主要来自于预训练、日常运营和模型微调。大模型的涌现开启了算力“军备赛”。

算力是训练大模型的底层动力源泉,一个优秀的算力底座在大模型(AI算法)的训练和推理具备效率优势。现在,GPU成为AI最主要的算力资源。英伟达的GPU对于OpenAI的ChatGPT和Google Bard等生成AI平台至关重要。

训练出一个类ChatGPT大模型的算力,需要成千上万个GPU。据报道,OpenAI训练ChatGPT就用了10000个英伟达的GPU。

GPU芯片对于大语言模型训练和生成式AI发展至关重要。因此,GPU已经上了美国对中国禁用的黑名单,对NVIDIA A100、H100两款GPU实施禁令,不得销售给中国企业。

03

英伟达,AI背后“最大军火商”

生成式人工智能推动了对英伟达GPU产品需求的增长。几家公有云服务商,包括Google Cloud、Oracle Cloud和Microsoft Azure 等感受到“生成AI”的“强劲需求”,并部署了大量英伟达的GPU硬件。

大大小小的科技公司竞相为其产品添加生成人工智能工具。人工智能工具构成了最近Google I / O和Microsoft Build演示的绝大部分,而英伟达的芯片使其成为试图用AI构建东西的公司的关键供应商。

企业对人工智能和加速计算的需求同样强劲。英伟达在汽车、金融服务和电信等垂直领域看到了发展势头,在这些领域,人工智能和加速计算正迅速成为客户创新路线图和竞争定位不可或缺的一部分。

因此,提供AI计算所需的GPU,则被戏称为AI大战的“军火商”。大模型很多,商业进程复杂,一路走来,肯定会有跌倒的,有铩羽而归的。但是,提供GPU计算能力的军火商,却铁定是最大的赢家!

目前, 英伟达已经稳稳地成为了AI大战的“最大军火商” 。

站在风口浪点的英伟达看得更远,有很多布局。英伟达上周又发布了适用于AI的超级芯片GH200Grace Hopper与超级计算机DGX GH200,无论是算力、带宽,还是能耗指标,提升惊人。

英伟达还推出了用于构建定制加速器服务器的NVIDIA MGX架构,使用这种模块化架构,制造商可以根据用户的要求构建100多种不同的配置。该架构支持所有英伟达产品以及x86和ARM处理器,满足AI和HPC要求。

同时,英伟达着手重建以太网结构,推出了Spectrum-X网络平台,将英伟达的 BlueField-3 数据处理单元与传统以太网交换机结合,让性能和功率效率提高了1.7倍。

即将访问中国的英伟达CEO黄仁勋判断,未来生成式人工智能将推动万亿美元的数据中心将从通用计算向加速计算转型。但这一庞大的市场几乎一半属于中国,一半属于美国。目前,中国发布了79个大模型,仅次于美国,两国相加,占了全球80%。

黄仁勋已经开始担心,“如果中国不能从美国购买GPU芯片,他们就会自己制造。”与美国同行纷纷自研芯片一样,中国科技巨头也在研发迭代自己的芯片!

参考资料:

·https://www.foxbusiness.com/markets/nvidia-market-cap-1-trillion

·https://www.cnbc.com/2023/05/30/nvidia-on-track-to-hit-1-trillion-market-cap-when-market-opens.html

春华秋实!

扫码关注

大数据应用

从现在开始

End