这篇文章的核心内容是介绍了一种名为 FastVLM 的新型视觉语言模型(VLM),它通过一种高效的视觉编码器 FastViTHD,在高分辨率图像输入下实现了显著的性能提升和延迟降低。以下是文章的主要研究内容总结:

1. 研究背景与动机

-

视觉语言模型(VLM):VLM 结合了视觉输入和文本输入,用于理解和生成与图像相关的内容。常见的 VLM 架构包括一个视觉编码器、一个投影层和一个大型语言模型(LLM)。

-

挑战:高分辨率图像虽然能提升性能,但会导致视觉编码器生成过多标记,增加编码延迟和 LLM 的填充时间,从而降低整体效率。

-

目标:设计一种高效的视觉编码器,能够在高分辨率下减少标记数量和编码延迟,同时保持或提升性能。

2. FastVLM 的核心贡献

-

FastViTHD:一种新型的混合卷积-Transformer 架构,专门针对高分辨率图像设计。它通过减少输出的视觉标记数量和降低编码延迟,显著提高了 VLM 的效率。

-

性能提升:在 LLaVA-1.5 设置下,FastVLM 在时间至首标记(TTFT)上比现有方法快 3.2 倍,同时在多个 VLM 基准测试中保持了相似的性能。

-

与现有方法的比较:

-

比 LLaVA-OneVision 在最高分辨率(1152×1152)下快 85 倍,视觉编码器小 3.4 倍。

-

比 SigLIP-SO400M 快 3.2 倍,小 3.6 倍;比 ConvNeXT 快 2.3 倍,小 1.7 倍。

-

3. FastViTHD 的架构设计

-

混合架构:结合了卷积层和 Transformer 层,利用卷积层的高效下采样能力和 Transformer 层的强大特征提取能力。

-

多尺度特征:通过聚合不同阶段的特征,进一步提升性能。

-

优化策略:通过增加额外的下采样层,减少自注意力操作的输入尺寸,从而降低延迟并减少标记数量。

4. 实验与评估

-

训练设置:使用 LLaVA-1.5 的两阶段训练方法,第一阶段训练投影层,第二阶段微调整个模型。

-

基准测试:在多个主流 VLM 基准测试(如 GQA、TextVQA、DocVQA 等)上评估性能。

-

关键结果:

-

FastVLM 在高分辨率下表现出色,尤其是在文本丰富的任务中。

-

与 ConvLLaVA 相比,FastVLM 在相同分辨率下更快且性能更好。

-

在扩展预训练和指令微调数据集后,FastVLM 的性能进一步提升。

-

5. 结论

-

FastVLM 通过高效的视觉编码器 FastViTHD,在高分辨率图像输入下实现了显著的性能提升和延迟降低。

-

实验结果 表明,FastVLM 在多种 VLM 基准测试中达到了最新的技术水平,同时在实际硬件上展示了优异的效率。

6. 未来工作

-

进一步扩展数据集:通过更大的预训练和微调数据集,进一步提升模型性能。

-

探索更多架构优化:研究其他可能的架构改进,以进一步减少延迟和标记数量。

-

多模态任务扩展:将 FastVLM 应用于更多类型的多模态任务,验证其在不同场景下的适用性。

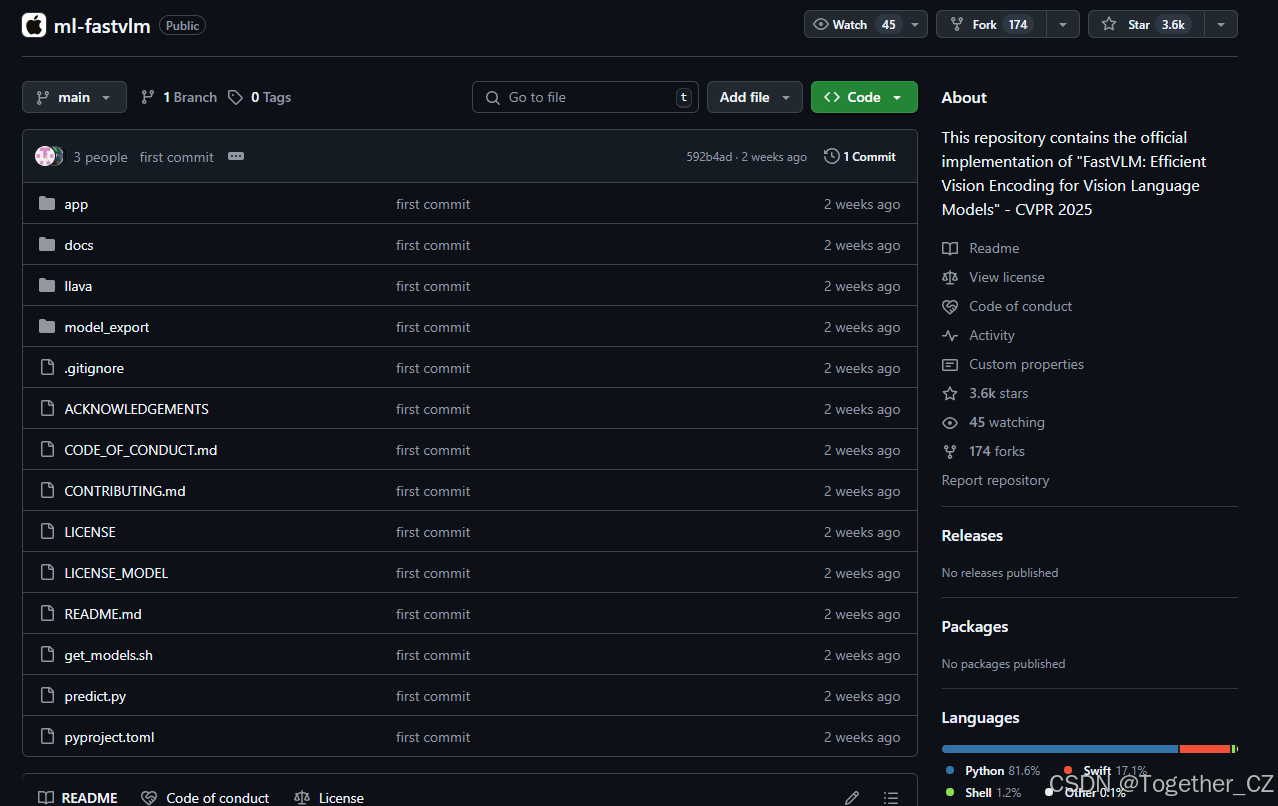

这篇文章的核心在于通过高效的视觉编码器设计,解决了高分辨率图像输入带来的性能瓶颈,为视觉语言模型的发展提供了新的方向。这里是自己的论文阅读记录,感兴趣的话可以参考一下,如果需要阅读原文的话可以看这里,如下所示:

官方项目地址在这里,如下所示:

摘要

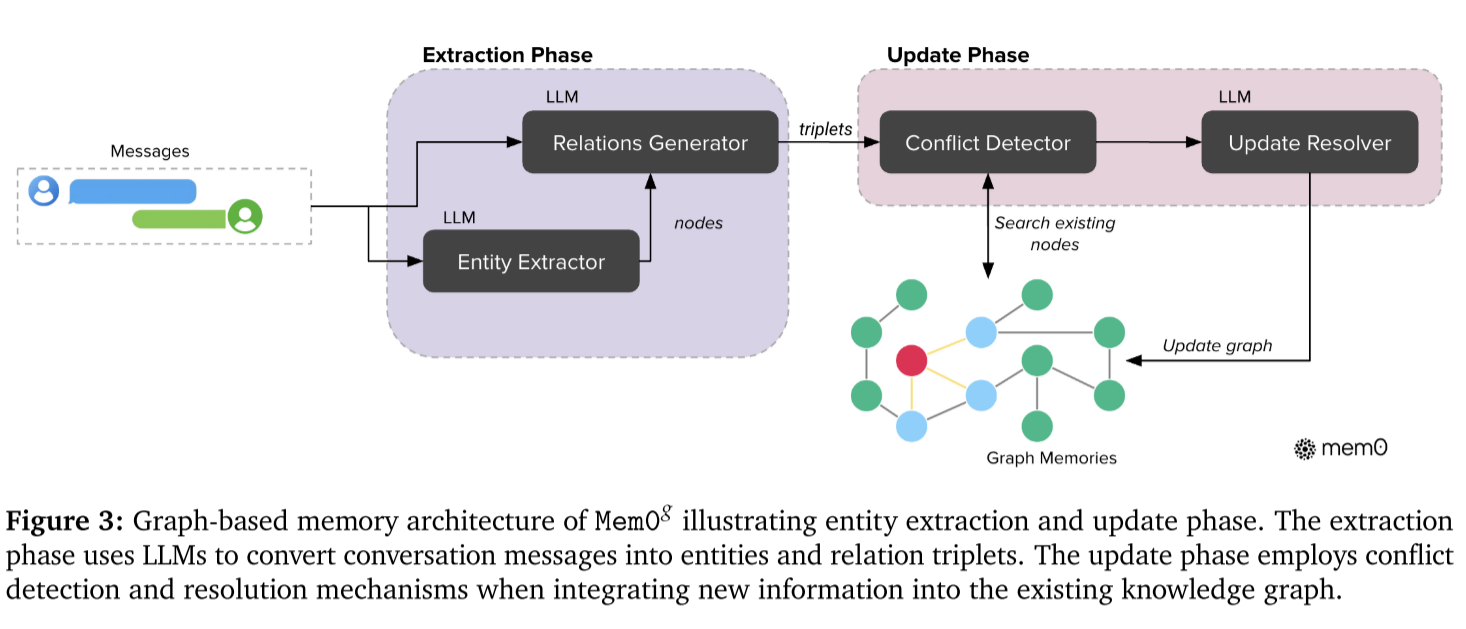

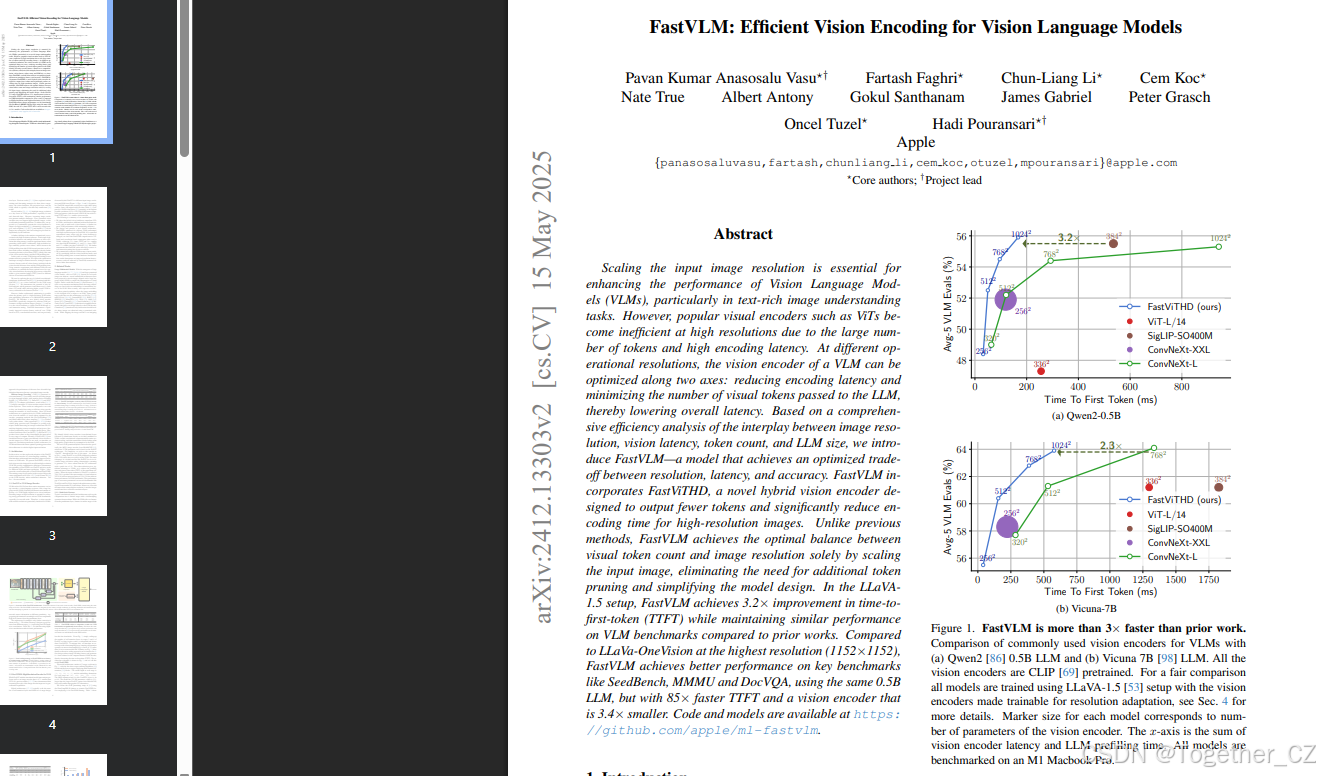

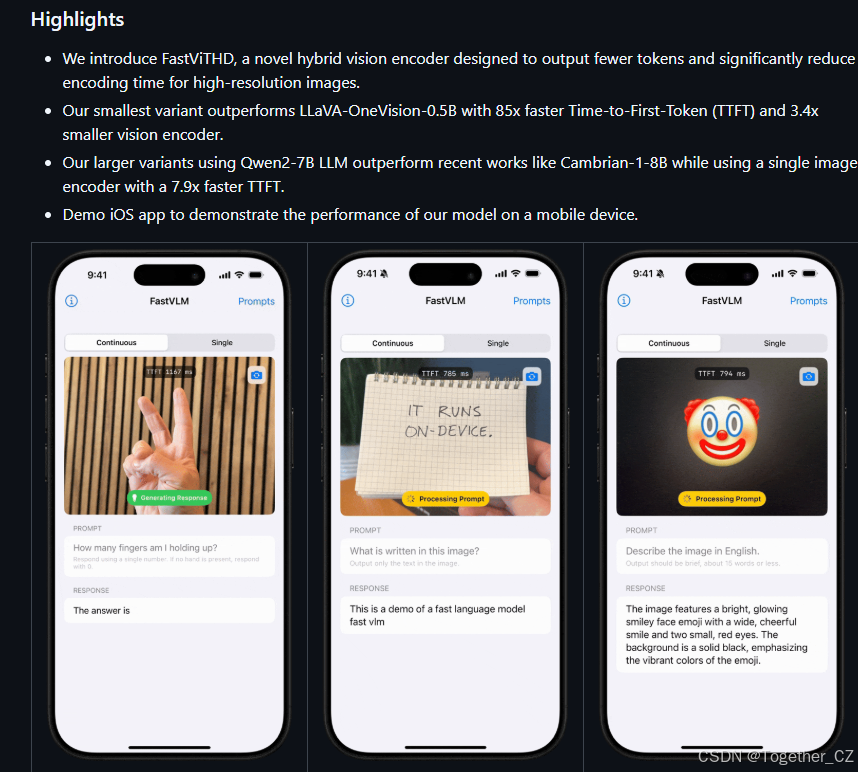

提升输入图像分辨率对于增强视觉语言模型(VLMs)的性能至关重要,尤其是在文本丰富的图像理解任务中。然而,流行的视觉编码器(如ViTs)在高分辨率下变得低效,因为它们会产生大量的标记和高编码延迟。在不同的操作分辨率下,VLM的视觉编码器可以通过两个轴进行优化:减少编码延迟和最小化传递给LLM的视觉标记数量,从而降低整体延迟。基于对图像分辨率、视觉延迟、标记数量和LLM大小之间相互作用的全面效率分析,我们引入了FastVLM——一个在分辨率、延迟和准确性之间实现优化权衡的模型。FastVLM引入了FastViTHD,这是一种新颖的混合视觉编码器,旨在为高分辨率图像输出更少的标记并显著减少编码时间。与以往方法不同,FastVLM仅通过缩放输入图像就能实现视觉标记数量和图像分辨率之间的最佳平衡,无需额外的标记修剪,简化了模型设计。在LLaVA1.5设置中,FastVLM在时间至首标记(TTFT)上实现了3.2倍的改进,同时在VLM基准测试中与先前工作保持相似的性能。与在最高分辨率(1152×1152)下运行的LLaVa-OneVision相比,FastVLM使用相同的0.5B LLM,在关键基准测试(如SeedBench、MMMU和DocVQA)上取得了更好的性能,但TTFT快85倍,视觉编码器小3.4倍。

1. 引言

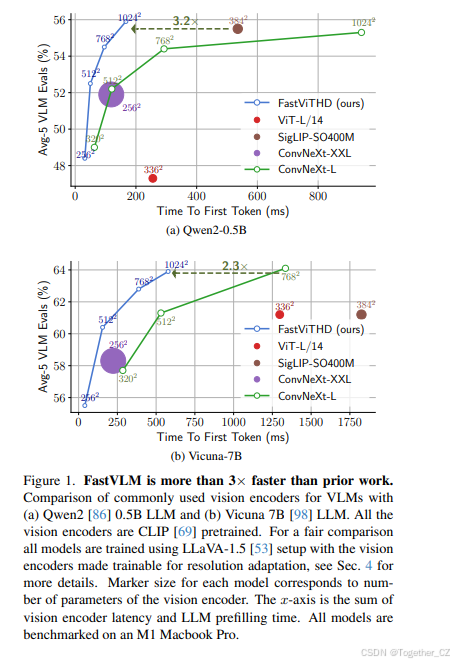

视觉语言模型(VLMs)能够结合视觉理解与文本输入。VLMs通常是通过将视觉标记从预训练的视觉骨干网络传递到预训练的大型语言模型(LLM)来构建的,LLM通常是一个仅解码器的Transformer模型。先前的研究已经探索了这三部分(视觉骨干网络、投影层和LLM)的各种训练和微调策略。几项研究强调图像分辨率是VLM性能的关键因素,尤其是在文本和图表丰富的数据中。然而,提高图像分辨率带来了多个挑战。首先,预训练的视觉编码器可能不支持高分辨率图像,因为这会使预训练变得低效。为了解决这一问题,一种方法是持续预训练视觉骨干网络以适应高分辨率图像。另一种挑战是高分辨率推理时的运行时计算成本。无论是单次高分辨率推理还是多次低分辨率推理(如平铺策略),都会在生成视觉标记时导致显著的延迟。此外,高分辨率图像自然会产生更多的标记,这会增加LLM的填充时间(LLM在上下文中所有标记上的前向传递时间,包括视觉标记),从而进一步增加时间至首标记(TTFT),即视觉编码器延迟和LLM填充时间的总和。在这项工作中,我们从运行时效率的角度研究VLM的设计和训练。我们探索了随着图像分辨率增加的优化景观,旨在改善准确性和延迟之间的权衡,其中延迟包括视觉编码器推理时间和LLM填充时间。通过使用不同大小的LLM和分辨率进行广泛的实验,我们为特定的视觉骨干网络建立了帕累托最优曲线,展示了在给定运行时预算(TTFT)内,基于不同分辨率和LLM大小选择可实现的最佳准确性。我们首先探索了使用混合卷积-Transformer架构FastViT作为VLM设置的视觉骨干网络(第3.1节)。我们展示了这种混合骨干网络的潜力,它生成视觉标记的速度比ViT模型快4倍以上,同时在多尺度特征的情况下实现了更高的整体VLM准确性(第3.1.1节)。然而,当主要目标是高分辨率VLM(而不是像MobileCLIP预训练的FastViT那样用于嵌入生成)时,视觉骨干网络还有进一步的架构优化空间。我们引入了一种新的混合视觉编码器FastViTHD,专门设计用于在高分辨率图像上实现高效的VLM性能(第3.2节),并将其用作视觉骨干网络,通过视觉指令微调获得FastVLM。FastVLM在不同输入图像分辨率和LLM大小的情况下,与基于ViTs、卷积编码器以及我们之前讨论的混合FastViT的VLMs相比,显著改善了准确性和延迟之间的权衡(图1a、图1b和图4)。特别是,FastVLM在更小、更快且训练数据更少的情况下,优于几项先前的工作(表6)。与在最高可能分辨率(1152×1152)下运行的LLaVA-OneVision相比,FastVLM使用相同的0.5B LLM,但TTFT快85倍,视觉编码器小3.4倍。以下是我们的贡献总结:

-

我们展示了混合视觉骨干网络在VLMs中优于ViTs,并引入了额外的架构干预措施,如多尺度视觉特征,以进一步提高VLM性能,同时保持效率。

-

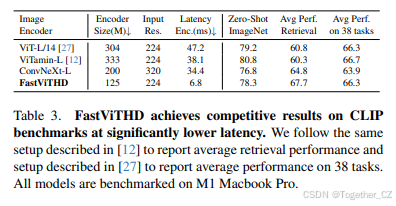

我们设计并预训练了一种新的混合架构FastViTHD,针对高分辨率输入的高效VLM性能进行了优化。在一个受控的实验设置中,仅改变视觉骨干网络,我们展示了FastViTHD在VLMs中优于其基于ViT和卷积的对应物:与SigLIP-SO400M相比,TTFT快3.2倍,尺寸小3.6倍;与ConvNeXT相比,TTFT快2.3倍,尺寸小1.7倍。我们进一步证明了FastVLM随着更多视觉指令微调数据的可用性而有效扩展。

-

我们系统地研究了VLM的准确性-延迟权衡,同时考虑了实际硬件基准测试中的视觉骨干网络延迟和LLM填充时间。我们的结果证明了FastVLM在设备上测量的分辨率-延迟-准确性权衡的改进,而不是估计值。

2. 相关工作

大型多模态模型。随着大型语言模型和大型预训练视觉模型(如CLIP)的出现,这些模型在网页规模的图像-文本数据集上进行训练,已经提出了几种多模态架构,用于将图像与大型语言模型(LLM)对齐,以实现视觉信号的解释。早期的作品如Frozen和Florence使用交叉注意力机制,其中图像嵌入在LLM的中间层与文本嵌入融合。最近,自回归架构越来越受欢迎,其中图像嵌入与文本一起作为输入传递给LLM。一些突出的作品包括LLaVA、mPLUG-Owl、InstructBLIP、BLIP-3、MiniGPT-4、VILA、MM1、Qwen-VL、InternVL、Cambrian-1和Fuyu。最近,Fuyu和EVE引入了一种简化的架构,直接将原始图像传递给LLM解码器。Chameleon引入了早期融合混合模态模型,其中图像使用预训练的码本进行标记化。尽管跳过图像编码器是一个有趣的方法,但这种新型模型的性能落后于使用预训练图像编码器的架构。高效图像编码。CLIP预训练的视觉Transformer广泛用于视觉语言模型中的图像编码,流行的选择包括SigLIP、EVA-CLIP、InternViT和DFNCLIP。为了提高性能,最近的作品使用不同目标训练的视觉编码器集合。这些作品与我们的工作是正交的,因为它们可以从视觉编码器集合中受益于一个高效的视觉编码器。由于基于ViT的架构是VLMs的流行选择,因此由于编码器输出的视觉标记数量,出现了效率问题,促使方法如LLaVA-PruMerge和Matryoshka-based token sampling动态修剪标记。其他方法使用感知器风格的重采样器或池化技术减少标记。而不是使用像ViT这样的等轴架构,然后设计自定义的重采样器和投影器,层次化架构可以是一个更简单的设计选择。层次化骨干网络如ConvNeXT和FastViT在每个计算阶段对输入张量进行下采样,从而产生更少的标记。最近,ConvLLaVA被引入,它使用纯卷积视觉编码器为VLM编码图像。在我们的工作中,我们引入了一种改进的卷积-Transformer混合架构,用于VLMs,并讨论了当这种架构扩展到更高输入分辨率时的帕累托最优操作点。

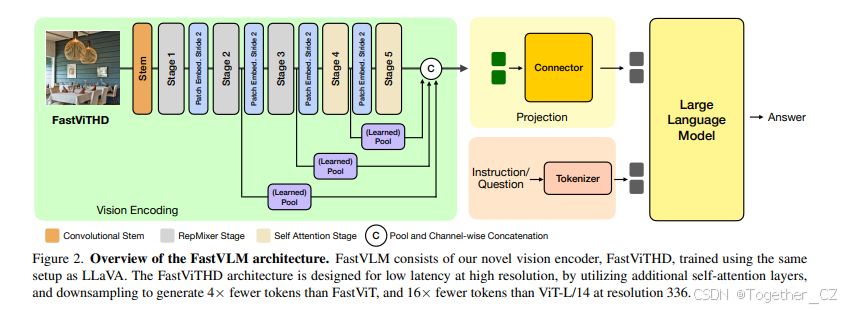

3. 架构

在本节中,我们首先探索FastViT混合视觉编码器在视觉语言建模中的应用。然后,我们引入架构干预措施以提高VLM任务的性能。我们提出了FastViTHD,这是一种针对高效高分辨率VLM设计的新混合视觉编码器。我们在不同的LLMs和输入分辨率下,通过广泛的消融实验来证明FastViTHD优于FastViT和先前工作。图2展示了FastVLM和FastViTHD的整体架构。本节的所有结果均遵循LLaVA-1.5的训练设置,使用Vicuna-7B作为LLM解码器,除非另有说明。详见第4节。

3.1. FastViT作为VLM图像编码器

VLMs(如LLaVA)有三个主要组成部分:图像编码器、视觉-语言投影器和大型语言模型(LLM)。VLM的性能和运行时效率高度依赖于其视觉骨干网络。在各种VLM基准测试中实现强大性能的关键是高分辨率编码图像,尤其是在文本丰富的任务中。因此,具有可扩展分辨率的视觉编码器对VLMs特别有益。

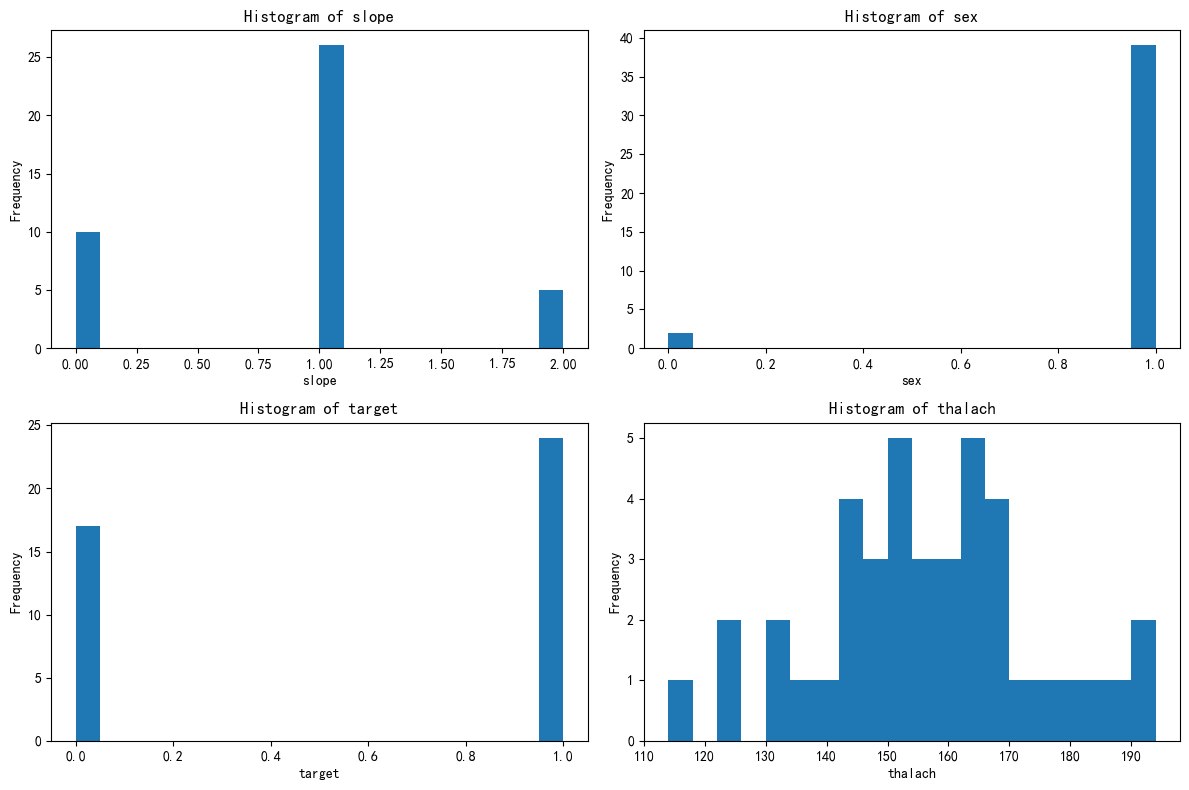

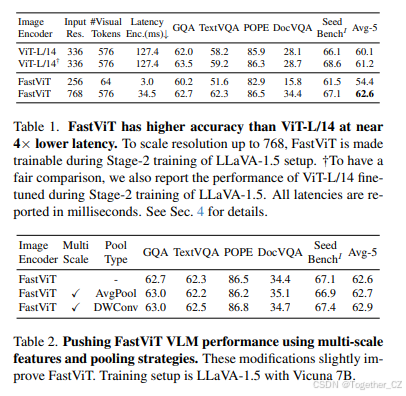

图像输入 #视觉标记 延迟 GQA TextVQA POPE DocVQA Seed 平均5个基准 ViT-L/14 336 576 127.4 62.0 58.2 85.9 28.1 66.1 ViT-L/14† 336 576 127.4 63.5 59.2 86.3 28.7 68.6 FastViT 256 64 3.0 60.2 51.6 82.9 15.8 61.5 54.4 FastViT 768 576 34.5 62.7 62.3 86.5 34.4 67.1 62.6 表1. FastViT在接近4倍更低延迟的情况下比ViT-L/14具有更高的准确性。为了将分辨率扩展到768,FastViT在LLaVA-1.5设置的第二阶段训练中被设置为可训练。†为了公平比较,我们还报告了在LLaVA-1.5第二阶段训练中微调的ViT-L/14的性能。所有延迟均以毫秒为单位报告。详见第4节。

我们确定混合视觉编码器(卷积层后跟Transformer块)是VLMs的理想选择,因为它们的卷积部分能够实现原生分辨率缩放,而Transformer块进一步提炼高质量的视觉标记以供LLM使用。我们使用一个CLIP预训练的混合视觉编码器,具体是MobileCLIP中的MCi2图像编码器,它有35.7M参数,基于FastViT架构。为简便起见,我们在本文其余部分将此编码器称为“FastViT”。如表1所示,使用FastViT在其CLIP预训练分辨率(256×256)时,单独使用并不能产生强大的VLM。混合编码器(如FastViT)的主要优势在于其有利的图像分辨率缩放特性,这意味着它比具有14个补丁大小的ViT架构少生成5.2倍的标记。标记的减少为VLMs带来了显著优势,因为它减少了Transformer解码器的填充时间和时间至首标记(TTFT)。当FastViT的输入分辨率被扩展到768×768时,它产生的视觉标记数量与输入分辨率为336×336的ViT-L/14相同,但在VLM基准测试中表现更好。这种性能差距在文本丰富的基准测试(如TextVQA和DocVQA)上更为明显,尽管这两种架构产生的视觉标记数量相同。此外,即使在更高分辨率下标记数量相同,由于高效的卷积层,它也能更快地编码图像。

3.1.1. 多尺度特征

典型的卷积和混合架构将计算分成4个不同的阶段,每个阶段之间有下采样操作。虽然VLM依赖于倒数第二层的特征,但网络中早期阶段提取的信息具有不同粒度。聚合来自多个尺度的信息可以补充来自倒数第二层的高级特征。多尺度特征提取的架构如图2所示。我们对从不同阶段聚合特征的两种设计进行了消融实验,即平均池化和2D深度卷积。从表2可以看出,使用深度卷积可以获得更好的性能。

3.2. FastViTHD:用于VLM的高分辨率编码器

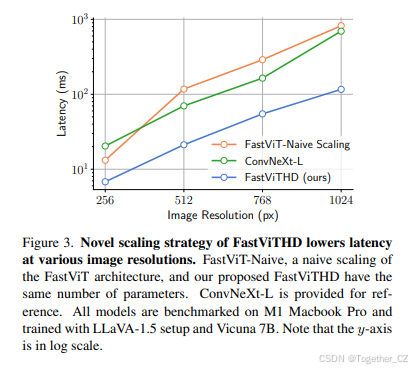

尽管FastViT在作为图像编码器时表现出色,其大小比ViT-L/14小8.7倍,但先前的研究已经证明,增加图像编码器的规模可以提高其泛化能力。混合架构通常在4阶段设计中按比例增加自注意力层的数量和宽度,但这种做法存在缺点。从图3可以看出,简单地在FastViT的第3和第4阶段增加自注意力层的数量(如先前工作所做)比ConvNeXT-L更慢。为了解决这一问题,我们引入了一个额外的阶段,其中包含一个下采样层,确保自注意力在被下采样32倍的张量上运行,而不是像ViTamin这样的最近模型那样下采样16倍(见图2)。更多关于简单缩放方法的细节可以在附录B中找到。我们的设计减少了图像编码延迟,并为计算密集型LLM解码器生成了4倍更少的标记,从而减少了时间至首标记(TTFT)。架构示意图如图2所示,我们称此模型为FastViTHD。该模型架构包含5个阶段,如图2所示,前三个阶段使用RepMixer块,最后两个阶段使用多头自注意力块。每个阶段的模型深度为[2, 12, 24, 4, 2],每个阶段的嵌入维度为[96, 192, 384, 768, 1536]。ConvFFN层的MLP扩展比率为4.0。该模型有125.1M参数,比MobileCLIP中最大的FastViT变体大3.5倍,但仍小于流行的ViT替代品。我们遵循CLIP预训练设置[83],使用DataCompDR-1B数据集预训练FastViTHD,然后用于FastVLM训练。

3.2.1. 视觉编码器 - 语言解码器的相互作用

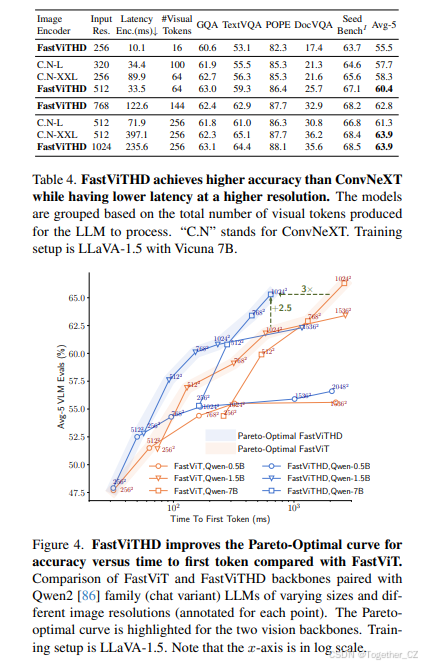

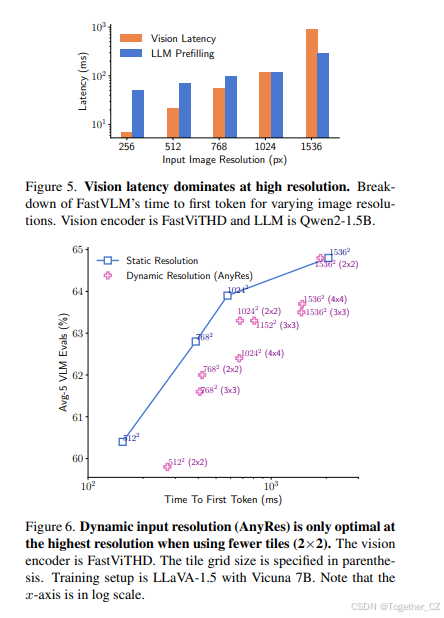

VLM中的准确性-延迟权衡受到多种因素的影响。一方面,VLM的整体性能取决于(1)输入图像分辨率,(2)视觉标记的数量和质量,以及(3)LLM的能力。另一方面,VLM的总延迟(时间至首标记生成)由(1)视觉编码器的延迟和(2)LLM的填充时间决定。后者受到视觉编码器产生的标记数量和LLM大小的影响。由于VLM的优化景观复杂,关于视觉编码器的最优性声明必须在各种(分辨率,LLM)对之间进行验证。在这里,我们通过实验验证了FastViTHD优于FastViT。对于每个视觉编码器,我们考虑了三种LLMs,Qwen2 [86]-0.5B/1.5B/7B,以及一系列输入图像分辨率。对于每个(分辨率,LLM)对,我们进行了LLaVA-1.5 [53]预训练和视觉指令微调,并在一系列任务上评估了结果。结果如图4所示。首先,我们观察到对于一个视觉编码器,帕累托最优曲线(在图4中标记)代表了在给定运行时预算(TTFT)内可实现的最大性能,由不同大小的LLMs组成。具体来说,将高分辨率与小LLM配对是次优的,因为小LLM无法有效利用那么多标记,而TTFT将主要由视觉编码器的延迟主导(见图5)。其次,图4中的FastViTHD的帕累托最优曲线明显优于FastViT。对于给定的运行时预算,考虑所有可能的(分辨率,LLM)对,我们使用FastViTHD实现了显著更好的性能(在平均5个基准指标上提高了超过2.5个百分点),而FastViTHD可以比FastViT更快地达到目标VLM性能,速度提高了3倍。重要的是要注意,在前面的部分中,我们已经证明了基于FastViT的VLM已经比基于ViT的VLM有了显著的改进,而FastViTHD在FastViT的基础上又取得了显著的收益。

3.2.2. 静态与动态输入分辨率

有两种方法可以扩展输入分辨率:直接调整模型的输入分辨率或对图像进行平铺,并将编码器的分辨率设置为平铺大小。平铺推理(AnyRes)在先前的作品中被引入,以使ViT模型能够处理高分辨率图像。由于FastViTHD被设计为能够高效地在高输入分辨率下进行推理,我们分析了使用这两种策略的各种分辨率的最佳操作点。从图6可以看出,直接将模型的输入分辨率设置为所需分辨率提供了最佳的准确性-延迟权衡,只有在极端分辨率(如1536×1536)下,由于内存带宽限制,动态分辨率才有益。如果需要动态分辨率,使用较少平铺的设置表现出更好的准确性-延迟权衡。关于此设置的进一步讨论在附录C.1中。

3.2.3. 与标记修剪和下采样的比较

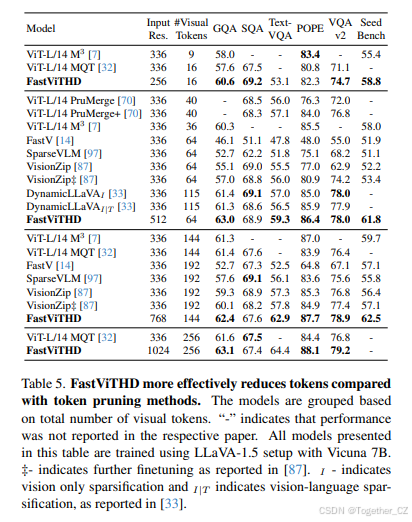

我们进一步将FastViTHD在不同分辨率下的性能与文献中流行的标记修剪方法进行了比较。从表5可以看出,与使用标记修剪方法的各向同性架构(如ViT)相比,使用层次化骨干网络的VLMs在准确性-延迟权衡方面表现更好。通过简单地在较低输入分辨率下训练VLMs,FastViTHD可以实现与视觉标记数量一样低的16,同时优于最近的标记修剪方法。有趣的是,即使是最有效的标记修剪方法,如[7, 32, 33, 87]中提出的那些方法,也比在256×256输入分辨率下训练的FastViTHD表现更差。

4. 实验

训练设置。对于第3节中呈现的所有消融实验,我们遵循LLaVA-1.5 [53]中描述的两阶段设置,使用Vicuna-7B [98]作为LLM解码器,除非另有说明。在第一阶段,仅使用LLaVA-558K对齐数据集对投影层进行训练,训练一个周期,批量大小为256,学习率为10^-3。在这个阶段,输入图像分辨率与骨干网络预训练分辨率相匹配(例如,FastViT为256,FastViTHD为224)。在第二阶段,我们使用LLaVA-665K监督微调数据集,训练模型一个周期,并微调所有模块,即视觉编码器、投影层和LLM。在这个阶段,输入图像分辨率被设置为目标分辨率。在第4节中,我们介绍了不同LLM解码器的结果,主要是Qwen2-0.5B/1.5B/7B模型系列 [86](聊天变体)和Vicuna-7B模型 [98]。我们在两个训练设置中报告结果,第一个是LLaVA-1.5引入的两阶段设置。对于第二个训练设置,我们遵循当前文献 [43, 66] 中的趋势,即在三个阶段中训练VLMs,即第1阶段用于训练连接器,第1.5阶段用于分辨率缩放,第2阶段用于视觉指令微调。这些阶段使用的数据集信息可以在附录D中找到。在这个设置中,输入图像分辨率在第1阶段设置为骨干网络预训练分辨率,并在接下来的两个阶段中调整为目标分辨率。在这两个设置中,视觉编码器和LLM仅在第1阶段被冻结,而所有模块在剩余阶段中被微调。对于最佳设置,我们进一步使用高质量指令微调数据集从 [30] 进行链式推理,并将其称为第3阶段。此设置的详细信息在附录A和附录D中进行了阐述。我们公开发布了第2阶段训练的R4、R12和R41检查点,以及第3阶段训练的R5、R13和R42检查点,作为我们开源代码库的一部分。所有FastVLM模型在本文中均在单个节点上使用8×NVIDIA H100-80GB GPU进行训练。LLVM的第一阶段训练非常快,使用Qwen2-7B解码器大约需要30分钟。第1.5阶段和第2阶段的训练时间取决于输入分辨率。对于1024×1024的输入分辨率,第1.5阶段需要77小时,第2阶段需要8小时。报告的墙钟时间对应于这些阶段使用的以下数据集:第1.5阶段使用1500万样本,第2阶段使用110万样本。评估。我们在主流基准测试GQA [34]、ScienceQA [59]、TextVQA [74]、POPE [48]、LLaVA-in-the-wild [54]、VQAv2 [29]、MMVet [91]、MMMU [93]、DocVQA [65]和SeedBench [42]上评估模型。对于GQA、ScienceQA、TextVQA、POPE和LLaVA-in-the-wild基准测试,我们使用LLaVA [54]的官方评估。对于其余评估,我们使用lmms-eval [96]库v0.2.2。我们使用所有评估的默认设置,lmms-eval默认使用0613版本的GPT进行依赖GPT的评估。对于第3节中呈现的消融实验,我们报告GQA、TextVQA、POPE、DocVQA和SeedBench。GQA和SeedBench是通用知识基准测试,DocVQA和TextVQA代表文本丰富的评估,而POPE是幻觉基准测试。这些基准测试共同提供了多样性,并且在消融实验中快速评估。最重要的是,它们在不同初始化和概率解码设置下表现出较低的方差。我们在附录D.3中报告了不同初始化的方差。这5个选定指标的标准差小于0.5。我们称这5个基准测试的平均值为平均5个基准,并将其作为我们分析的可靠信号。对于平均5个基准的实证标准差估计为0.1。基准测试。我们在配备M1 Max芯片和32GB RAM的MacBook Pro上对所有模型进行了基准测试。图像编码器使用coremltools v7.2转换为Core ML包文件,并在神经引擎上使用XCode 15.4 (15F31d)进行基准测试。LLM在MacBook Pro GPU上使用MLX [31]进行基准测试。模型首先使用mlx lm.convert工具进行转换,该工具将Hugging Face上的模型转换为MLX格式,并将张量转换为FP16。使用mlx lm.cache prompt工具 [31]估计填充延迟。时间至首标记(TTFT)通过将特定分辨率下的图像编码延迟与相关视觉标记的LLM填充延迟相加来估算。

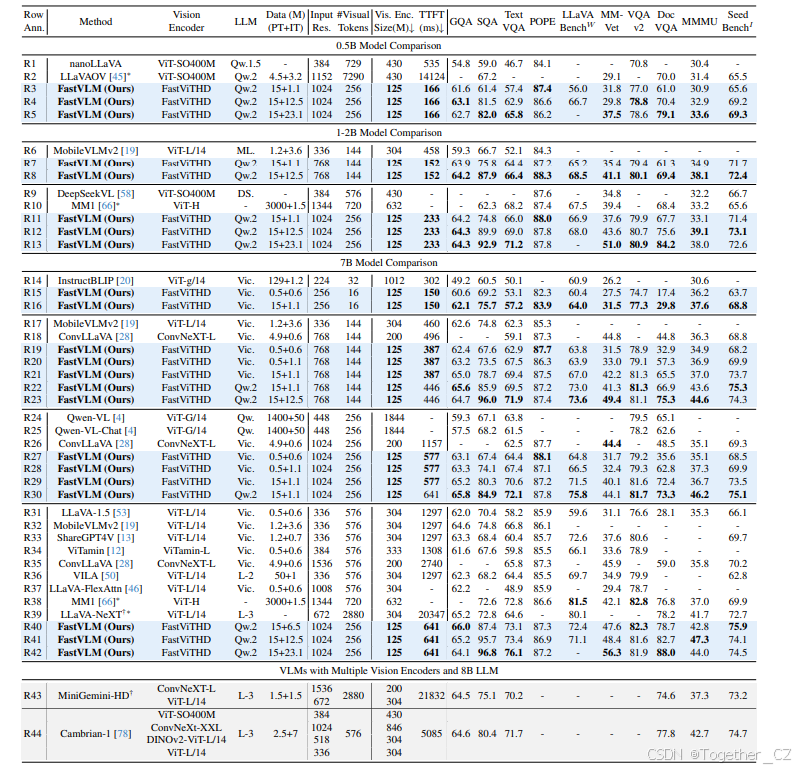

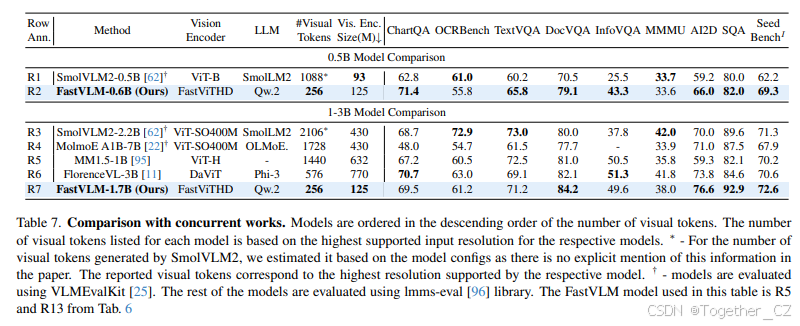

4.1. 与最新技术的比较

在表6中,我们将FastVLM与最近发表的方法进行了比较。不同作品之间的训练设置差异很大。对于每种方法,我们报告了用于训练各自VLMs的LLM解码器以及预训练和指令微调数据集的大小,以便进行公平比较。层次化骨干网络。当我们将FastVLM (R20)与ConvLLaVA [28] (R18)进行比较时,使用相同的LLM和类似的训练数据大小,我们的模型在TextVQA上获得了+8.4%的更好性能,在DocVQA上获得了+12.5%的更好性能,同时速度快22%。在更高分辨率下,FastVLM (R28和R29)在各种基准测试中实现了优于ConvLLaVA (R26)的性能,同时使用相同的LLM解码器,速度快2倍。数据集扩展。当通过引入中间预训练阶段以扩展预训练数据集时,FastVLM (R21)在各种基准测试中与MM1 [66] (R38)相匹配或超越,同时生成的视觉标记数量减少了5倍。使用1024×1024的输入分辨率和12.5M的更大指令微调数据集时,FastVLM (R41)在各种基准测试中超越了MM1 (R38)和LLaVA-NeXT (R39),包括对输入分辨率和视觉标记数量敏感的文本丰富评估,如TextVQA和DocVQA。当使用AnyRes进一步扩展输入分辨率时,差距扩大,更多细节在附录C.1中。我们提供了数据集分割的详细信息在附录D中。多个视觉编码器。最近,MiniGemini [49]和Cambrian-1 [78]引入了依赖多个视觉编码器的模型。在表6中,我们将FastVLM (R40)与使用多个编码器的方法进行了比较,并在类似规模的视觉指令微调数据集上进行了训练。在Cambrian-1 [78] (R44)中,视觉编码贡献了大约5秒的总时间至首标记的3.2倍(详细分解在表10中提供)。FastVLM (R40)在类似视觉指令微调数据集上训练时,优于Cambrian-1 (R44),同时快7.9倍。通过将指令微调数据集扩展到12.5M,FastVLM (R41)在各种基准测试中实现了优于Cambrian-1 (R44)的性能,同时使用2.3倍更少的视觉标记,即使在对视觉标记数量敏感的文本丰富评估(见表11)上也是如此。解码器的影响。VLM性能还取决于LLM的质量,如先前的研究 [44]所示。通过从Vicuna-7B (R21, R29)切换到Qwen2 [77, 86]模型,我们在所有基准测试中看到了性能的提升。这些改进在MMVet、LLaVA-in-the-wild和MMMU基准测试中尤为显著。使用Qwen2-0.5B作为LLM解码器时,FastVLM (R4)在性能上优于LLaVA-OneVision [45],同时快85倍。这一结果突显了我们视觉编码器的质量,因为两种模型使用了相同的LLM解码器,而FastViTHD比SigLIP-SO400M [94]小3.4倍。

5. 结论

在这项工作中,我们引入了FastVLM,它利用FastViTHD视觉骨干网络,用于高效编码高分辨率输入。FastViTHD具有混合架构,经过强化的图像-文本数据预训练,并输出大量减少的视觉标记,几乎没有准确性损失。FastVLM在各种VLM基准测试中表现出色,同时在时间至首标记和视觉骨干网络的参数数量方面提高了效率。在M1 MacBook Pro上的严格基准测试表明,FastVLM在分辨率-延迟-准确性权衡方面达到了最新水平,与现有作品相比。