65岁老人称贷款200万给男友靳东拍戏 AI诈骗新案例

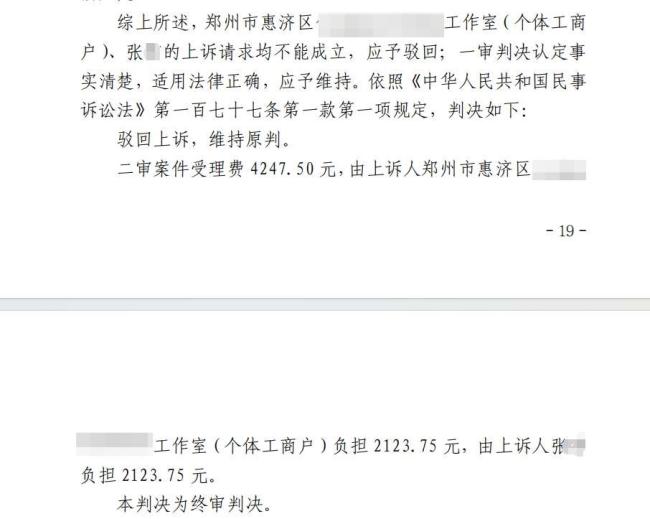

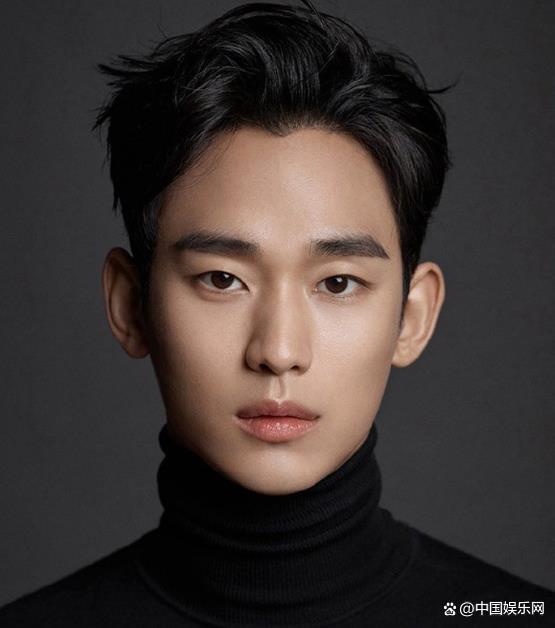

梳理公开信息发现,一些不法分子利用“数字人”形象进行违法活动。张文宏、雷军等公众人物的形象曾被用来生成AI数字人,用于带货或恶搞。有些直播间内的AI数字人向中老年人虚假宣传保健品,诱导购买。更有甚者,一些不法分子利用AI数字人进行敲诈、诈骗等犯罪行为。例如,山西忻州公安机关发现犯罪嫌疑人王某某利用AI技术制作合成“数字人”新闻视频引流,进而进行有偿发帖、有偿删帖等敲诈勒索活动。2024年,江西一名65岁老人声称要贷款200万元给男朋友“靳东”拍戏,后经调查,老人手机里的“靳东”视频是AI合成的。

重庆大学网络与大数据研究院副院长罗勇认为,AI产业发展不能凌驾于网络安全之上。对于利用AI技术生成的短视频,网络用户特别是未成年人和老年人由于缺乏必要的鉴别能力,往往会信以为真,这可能产生负面网络舆情,甚至对网络安全造成负面影响。

当前我国已经出台了《生成式人工智能服务管理暂行办法》《互联网信息服务深度合成管理规定》等法规,对AI数字人和AI生成内容的标识、数据来源等提出了具体要求。今年3月,国家网信办等四部门联合发布《人工智能生成合成内容标识办法》,通过标识提醒用户辨别虚假信息,规范内容制作、传播各环节标识行为,为规范AI生成内容划定红线。该办法将于9月1日起施行。

中国政法大学教授郑飞指出,相关规定在落地过程中存在困难。一方面,监管和技术手段有限,难以彻底发现并纠正违规行为。例如,一些“AI起号”从业者通过预置“镜像参数”生成极为逼真的虚拟人像,从而逃避平台的强制标注要求。而监管部门特别是基层执法部门通常面临职责不清、执法手段和执法力量不足的问题。另一方面,部分平台在一定程度上“管不了”也“不想管”。平台管理能力与技术手段欠缺,尤其是一些小型平台,缺乏足够的审核人力和技术支持。“不想管”则是因为背后的利益驱动。未明显标识AI数字人或合成内容会让受众误以为是真人或真实事件,从而更容易引起人们的兴趣和好奇心,吸引更多的流量和关注,带来更多的商业利益。

罗勇建议,以网络社交平台为代表的网络服务提供者在AI生成内容的应用场景中,应当进一步完善用户使用AI协议规定,并强化对AI生成内容的审核。郑飞建议,应从明确标识要求和加大责任追究两方面发力。标识办法明确要求,一旦检测到AI生成内容,传播平台应在发布内容周边添加显著提示标识,并在文件元数据中加隐式标识,确保全流程可溯源。在未来落实过程中,可以进一步细化技术标准,比如规定标识文字的最小高度、对比度、展示时长等,让标识一目了然。另外,对于不按规定标注的行为,需要严厉处罚:除加大行政罚款、暂停业务或纳入不良信用记录等行政措施外,还要利用法律手段加大威慑。通过明确、显著的标识标准和更严厉的责任追究,才能从根本上震慑违规不标注行为,实现AI数字人应用的透明化、合规化。