Sentiment analysis integrating LangGraph and large-scale conceptual models

核心目标:

让电脑更聪明地理解大量用户评论(比如邮件、社交媒体、调查问卷),自动分析出大家是夸还是骂(情感分析),并且找出大家主要在讨论哪些问题(主题发现)。

传统方法的痛点:

- 只看单个词或短句,理解不了整句话的深层意思(比如讽刺、比喻)。

- 看不到不同评论之间的联系(比如很多评论都在吐槽同一个问题“电池续航差”)。

新方法的“三板斧”:

-

大型概念模型 (LCMs - 文章里的主角之一):

- 它像什么? 一个高段位的“阅读理解专家”。

- 厉害在哪?

- 整句理解: 不像老方法一个字一个字抠,它把一整句话当作一个完整的“概念”来理解。比如“这相机绝了,但电池是渣”这句话,它能整体把握“相机好 + 电池差”这个混合情感。

- 懂“人话”: 能理解成语、比喻、反讽(比如“干得好,一小时就没电了!”其实是吐槽)。

- 抓重点: 能根据上下文判断词义(比如“bank”在“存钱”和“河边”意思不同)。

- 提炼精华: 能把一句话的核心意思压缩成一个“数字密码”(向量/嵌入),方便电脑比较和处理。

-

图神经网络 (GNNs - 另一个主角):

- 它像什么? 一个擅长分析“关系网”的“社交侦探”。

- 厉害在哪?

- 画关系图: 把每条用户评论当作一个“点”(节点)。如果两条评论提到了同一个东西(比如“相机”或“电池”),就在它们之间画一条“线”(边)。

- 信息传递: 让这些“点”通过“线”互相交流。比如,所有吐槽“电池”的点会互相“通气”,GNN 就能发现“哦,原来电池问题是个普遍槽点,而且大家都很不满!”这种整体趋势。这是只看单条评论发现不了的。

-

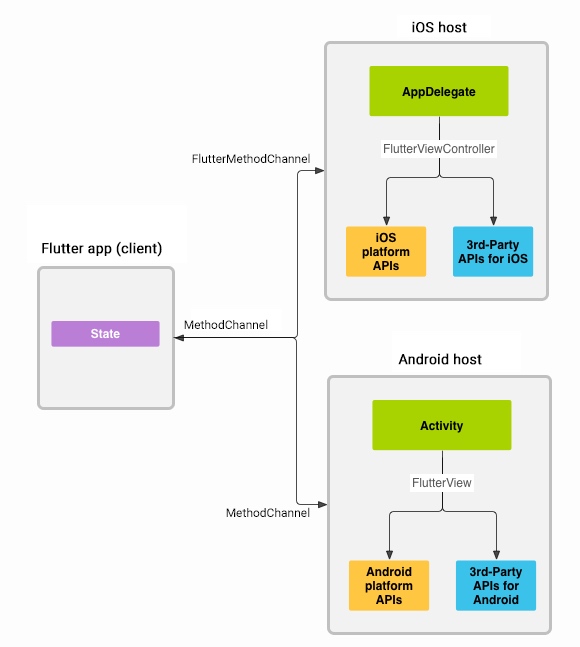

LangGraph (幕后协调员):

- 它像什么? 一个高效的“项目管家”或“流水线调度员”。

- 干什么用?

- 指挥整个流程:先让 LCM 理解每条评论(生成嵌入),再让程序根据共同点画关系图(构建图),接着让 GNN 在图上传消息做分析(情感、主题),最后汇总结果。

- 保证各个环节(LCM处理、画图、GNN分析)有序、高效地协作,尤其当数据量很大时。

怎么把它们揉在一起干活?(混合架构)

-

LCM 打基础: 先用 LCM 仔细阅读每一条用户评论,理解它的整体意思和情感倾向(正面/负面/中性),并生成代表这句话的“数字密码”(嵌入)。

-

画关系网: 把所有评论当作点,把提到相同东西(比如“电池”、“相机”、“客服”)的评论用线连起来,形成一张“用户反馈关系网”。每个点都带着 LCM 给的“数字密码”。

-

GNN 分析关系网: GNN 在这个关系网上工作。它让相连的点(讨论相关问题的评论)交换信息(传递嵌入)。通过这种“交流”,GNN 能:

- 更准地判断情感: 如果一条吐槽“电池”的评论,发现它的“邻居”(其他吐槽电池的评论)都很负面,那么它对“电池”的负面判断会更坚定。同时也能区分对“相机”的夸赞。

- 发现隐藏主题: 自动把讨论相似问题的评论聚成一类(聚类),比如“电池问题群”、“相机好评群”、“客服吐槽群”。

-

LangGraph 管流程: 上面这三步(理解->画图->分析)都由 LangGraph 来安排和衔接,确保高效无误。

-

准备数据: 模拟了几条用户评论(夸相机骂电池、夸相机嫌贵、骂电池夸其他、夸相机骂客服)。

-

预处理: 用工具(spaCy)清理文本,识别关键词和实体(如“相机”、“电池”、“客服”)。

-

画关系图 (NetworkX): 以评论为点,以共同提到的实体(如都提到了“相机”)为连接依据画线。

-

生成“数字密码” (sentence-transformers 模拟 LCM): 为每条评论生成一个代表其整体意思的数字向量(嵌入)。

-

GNN 分析 (PyTorch Geometric):

- 把图和“数字密码”喂给一个简单的图神经网络模型。

- 模型通过在图上传递信息,预测每条评论的情感(正面/中性/负面)。(注:演示用的模型是随机的,真实应用需要训练)

-

主题聚类 (K-Means): 根据“数字密码”的相似性,把评论自动分成几组(主题)。

-

可视化: 把关系图画出来,用不同颜色表示预测的情感(绿=好,灰=中,红=差),用不同形状表示所属的主题组。一目了然看到哪些问题被吐槽(红点多),哪些问题被关联讨论(连线的组)。

-

LangGraph 编排: 用 LangGraph 把上面 2-7 步像组装流水线一样自动串起来执行。

关键创新点:

- 升级理解力 (LCM): 从“认字”升级到“懂句”,更能把握语言的微妙之处。

- 引入关系分析 (GNN): 不仅看单条评论,更要看评论之间的联系和群体效应,发现隐藏模式和趋势。

- 混合双打 (LCM + GNN): LCM 的深度理解 + GNN 的关系洞察 = 更全面、更准确的分析。

- 高效管理 (LangGraph): 让这个复杂的混合系统能顺畅、规模化地运行。

对企业有什么用?

- 精准把握舆情: 快速从海量反馈中准确识别用户最满意和最不满意的点。

- 发现核心问题: 自动归类用户反馈,聚焦核心痛点(如电池问题群、客服问题群)。

- 理解关联性: 看到不同问题之间的关联(比如吐槽电池的往往也抱怨充电慢)。

- 提升效率: 自动化处理非结构化文本,节省人力,加速决策。

- 支持产品改进: 为产品优化、客户服务提升提供直接、量化的数据支持。

简单说,就是利用最新的 AI 技术(LCMs + GNNs),加上高效的流程管理(LangGraph),让电脑能像人一样“读懂”用户评论的字面意思和字里行间的情绪,还能“看出”不同评论之间的关联和整体趋势,从而为企业提供更深入、更自动化的客户洞察。

Large Concept Models

我们对大型语言模型(LLM),如ChatGPT或Gemini,已经不陌生。它们像博学的语法学家,能写出流畅、优美的词句。然而,它们在理解和生成语言时,本质上是在做一件事:猜测下一个最可能的词。这就像一个技艺精湛的拼字游戏玩家,但有时会“只见树木,不见森林”,难以真正掌握长篇内容的核心思想或话语背后的深层含义。

Meta团队提出的大型概念模型(LCMs),正是一场旨在解决这个问题的革命性架构升级。其核心目标是让AI从“拼凑词汇”的工匠,进化为能以“完整想法”为单位来理解和沟通的思想家。

大型概念模型(Large Concept Models, LCMs)是自然语言处理(NLP)领域的一种新型架构范式,由Meta(原Facebook)团队提出。其核心思想是将语言处理的粒度从传统的“词元级”(如单词或子词)提升到“概念级”(如完整句子或语义单元),从而更接近人类理解语言的方式。

-

传统 LLM(如 GPT-4):它的基本单位是词元 (Token)。就像给了它无数个乐高小积木,让它一块一块地拼接成模型。它擅长遵循局部规则,确保每块积木都接得通顺,但有时拼到一半,可能会忘记最初想盖的是城堡还是太空船,导致前后逻辑不一或内容重复。

-

大型概念模型 (LCM):它的基本单位是概念 (Concept),也就是一个完整的想法或句子。这就像给了它一套预先设计好的“乐高功能模块”(例如一个完整的城堡塔楼、一个飞船驾驶舱)。AI在生成内容时,先思考:“我需要一个‘表达赞美’的模块和一个‘关于相机’的模块。”然后再将这些大模块组合起来,并填补细节。

| 比较维度 | 传统大型语言模型 (LLM) | 大型概念模型 (LCM) | 通俗比喻 |

|---|---|---|---|

| 处理单元 | 词元 (Token) | 概念 (Concept) | 零散的单字 vs. 完整的想法 |

| 思考层级 | 词汇级 | 句子级 | 专注于用词遣字 vs. 把握中心思想 |

| 生成逻辑 | 逐词预测 | 先规划,后填充 | 想到哪写到哪 vs. 先列提纲,再写正文 |

| 理解方式 | 依赖语言本身 | 跨语言、跨模态 | 只能读懂中文 vs. 能认出“苹果”这个概念,无论是文字“苹果”、英文"Apple"或一张苹果图片 |

LCM 的两大关键技术

1. 概念级嵌入 (Concept-Level Embeddings):为每个“想法”制作独一无二的“思想指纹”

LCM 最神奇的地方,在于它能将一个完整的句子,无论其语言或表达方式如何,都转换成一个固定的数字向量(即“嵌入”)。这个向量就像这个想法在AI大脑中的唯一“指纹”或“坐标”。

- 例子:

- 中文:“这台手机的相机太强了!”

- 英文:“This phone’s camera is seriously impressive!”

- 一张用该手机拍出的、令人惊艳的风景照

在 LCM 的世界里,这三者会被映射到高维空间中一个极其相近的位置。AI不再是看到一堆不同的文字或像素,而是直接识别出它们共同的核心概念:“对相机功能的高度正面评价”。

这项技术直接克服了传统模型最大的痛点——词汇歧义。例如,对于讽刺句“干得好,一小时就没电了!”,传统LLM可能会被“干得好”误导,而LCM则能从整个句子的概念中,准确识别出“对电池续航的负面抱怨”这一核心思想。

2. 概念规划式生成 (Concept-Planned Generation):从“想到哪写到哪”到“谋定而后动”

当LCM要生成一段话时,它的思考路径发生了根本改变:

- 传统 LLM:逐词生成,像是在黑暗中摸索 → “今天” → “天气” → “真” → “不错”… 这种方式容易产生重复或前后矛盾的内容。

- LCM:先在脑中构思一个概念框架 →

[问候][陈述天气状况-晴朗][表达积极心情]。然后,再根据这个“思想蓝图”填充具体的词句,生成:“早安!今天阳光普照,真是让人心情愉快的一天。”

根据Meta的实验,这种“先规划、后填充”的方式,能让生成内容的重复率显著降低37%,逻辑也更为连贯和清晰。

关键能力与优势

(1)深层语义理解

精准解析复杂表达:

讽刺句:“干得好,一小时就没电了!” → 识别为负面情绪(传统模型易误判为正面)。

跨文化隐喻:“It’s raining cats and dogs” → 直接映射到“暴雨”概念。

(2)长上下文推理

维持多段落文档的语义一致性:

示例:在分析用户投诉长文时,LCM能关联开头提到的“电池问题”与结尾的“要求退货”,识别核心矛盾。

(3)高效多任务处理

单一概念嵌入支持多种任务:

graph LR

A[句子概念嵌入] --> B(情感分析)

–> C(主题聚类)

–> D(语义相似度计算)

与图神经网络(GNN)的协同价值

尽管LCM是理解单一思想的专家(深度理解单句语义),但它本身不擅长分析众多思想之间的关联(文本间关系)。这时,就需要它的最佳搭档——图神经网络 (GNN) 上场。

- LCM 的角色:担任**“语言特征提取专家”**。它负责阅读成千上万条评论,并将每一条评论都转化成一个精准的“概念节点”。例如,评论A“电池不耐用”、评论B“续航太差了”、评论C“充电还行但掉电快”。

- GNN 的角色:担任**“关系模式侦探”**。它接收所有这些概念节点,并在它们之间建立连接。GNN会发现,虽然这三条评论的用词不同,但它们的“概念指纹”都指向“电池续航问题”。通过分析这些节点的密集连接,GNN最终得出结论:“‘电池’是这款产品最普遍的负面反馈核心。”

这个组合的威力在于,它完美地模拟了人类的分析过程:先理解每一个独立的信息点,再将这些点串联起来,发现宏观的趋势与模式。

- LCM生成节点特征:为每个句子/评论生成概念嵌入。

- GNN建模关联:

若多条评论提及"电池续航",GNN通过边连接这些节点。

聚合相邻节点信息 → 发现"电池"是普遍负面主题。

类比:LCM是精通单句分析的“语言专家”,GNN是发现跨文本模式的“关系侦探”。

LCM目前仍处于前沿研究阶段,面临着技术尚未成熟、训练成本高昂、以及产业生态尚未建立等挑战。Meta也并未将其完整模型开源。

然而,LCM所揭示的方向是清晰且令人振奋的。它代表了AI从一个语言工具向一个理解伙伴的转变。

总结来说,大型概念模型(LCMs)的精髓,就是通过将AI的思考单位从“词”提升到“思想”,让机器能够:

- 跨越语言与形式的障碍,实现更深层次的语义理解。

- 像人类作者一样规划布局,生成更连贯、更有逻辑的内容。

- 为更高维度的分析(如GNN)提供完美的素材,从而洞察复杂文本数据背后的深层关联。(为图神经网络提供高质量语义特征,解决传统NLP难以捕捉的文本间关联问题)

简而言之,LCM正在教AI用我们人类最自然的方式——以完整的想法为单位——来理解这个世界。

图神经网络增强的概念模型架构

图神经网络增强的概念模型架构是一种结合**大型概念模型(LCMs)的深度语义理解能力和图神经网络(GNNs)**的关系建模能力的混合框架。其核心思想是:

- 用LCMs解析文本的“内在含义”:通过LCMs提取句子的固定维度概念向量,封装完整的语义信息。

- 用GNNs挖掘文本间的“关联规律”:通过构建图结构,利用GNNs实现节点间的信息传递与关系推理,从而同时解决语义深度和关系广度的挑战。

具体架构图解

核心组件详解

1. LCM概念处理层

功能:将文本转化为固定维度的概念向量,捕捉句子的完整语义信息。

输入:句子/段落(如用户评论:“相机超清但电池太差”)。

处理:使用工具如sentence-transformers或Meta SONAR,将整句编码为固定维度的概念向量(如384维)。

输出:向量封装完整语义(正面评价相机 + 负面评价电池)。

2. 图结构构建层

功能:基于LCM生成的概念嵌入,构建图结构,定义节点和边。

节点定义:

- 基础单元:句子/评论/文档(如图中4条手机评论)。

- 扩展单元:实体(如“相机”、“电池”)。

边定义:

| 关系类型 | 构建规则 | 示例 |

|---|---|---|

| 实体共现 | 两节点提及相同实体 | 评论A和B都讨论“电池” |

| 语义相似 | 概念向量余弦相似度 > 阈值 | 两条夸“拍照效果”的评论 |

| 句法依赖 | 基于依存解析的语法关系 | 评论中“电池”修饰“续航” |

工具:NetworkX 或 PyG(Python库)。

3. GNN关系推理层

功能:基于图结构,利用GNN进行节点之间的信息传递与关系推理。

模型结构(以GCN为例):

class GCN(torch.nn.Module):def __init__(self):self.conv1 = GCNConv(384, 16) # 输入LCM嵌入维度self.conv2 = GCNConv(16, 3) # 输出情感分类维度def forward(self, data):x = relu(conv1(data.x, data.edge_index)) # 节点特征传播x = conv2(x, data.edge_index) # 聚合邻居信息return x # 输出情感logits

关键操作:

- 消息传递:节点从邻居接收信息(如差评电池的节点相互强化负面信号)。

- 特征更新:融合自身语义和邻居关系(例:原本中性的评论因周围差评被修正为负面)。

工作流程示例(智能手机评论分析)

假设原始数据:

reviews = ["相机惊艳,电池垃圾", "拍照绝了!就是贵", "电池崩太快,其他还行","相机顶级,客服差评"

]

步骤1: LCM生成概念嵌入

| 评论ID | 概念嵌入(简化) | 语义摘要 |

|---|---|---|

| 0 | [0.8, -0.9, …] | 相机(+) & 电池(-) |

| 1 | [0.7, 0.0, -0.5, …] | 相机(+) & 价格(-) |

| 2 | [-0.6, 0.3, …] | 电池(-) & 其他(+) |

| 3 | [0.9, 0.0, -0.8, …] | 相机(+) & 客服(-) |

步骤2: 构建关系图

边连接规则:评论提及相同实体则建边。

步骤3: GNN推理与增强

节点0的更新过程:

- 接收邻居信息:

- 从节点1获取“相机+”特征

- 从节点2获取“电池-”特征

- 融合信息:

- 自身电池负面信号 + 节点2的电池负面信号 → 强化电池问题权重

- 自身相机正面信号 + 节点1的相机正面信号 → 确认相机优势

- 输出:情感分类置信度提升(电池负面更显著)。

步骤4: 任务输出

| 输出类型 | 结果示例 | 技术价值 |

|---|---|---|

| 情感分析 | 评论0:负面(电池问题主导) | 关联评论修正独立判断误差 |

| 主题聚类 | 群组1:相机相关(0,1,3) | 发现核心讨论点 |

| 实体关联 | “电池”←→“续航差”(支持度=75%) | 挖掘隐性问题链 |

架构核心优势

-

解决LCM的孤立性缺陷

- LCM单独处理文本时,无法感知“多条评论共同吐槽电池”的群体信号 → GNN通过图连接聚合跨文本证据。

-

弥补GNN的语义浅层问题

- 传统GNN用词袋特征表示节点(如“电池=1”),丢失上下文 → LCM提供“电池续航差”的精准概念向量。

-

可解释性增强

- 图中边可追溯分析依据(例:差评因与5条电池问题评论相连),优于黑盒模型。

-

动态关系适应

- 新增评论时,只需扩展图结构(添加节点/边),GNN可增量更新预测,无需全量重训练。

企业级应用场景

-

客户心声分析

- 问题定位:从万条评论中自动识别产品缺陷群组(如“电池+发热”关联问题)。

- 情感趋势:发现对“相机”评价从正面转向负面(因竞品发布新机型)。

-

知识图谱构建

- 用LCM解析医疗文献句子 → GNN连接“药物A-副作用B-病症C”关系链。

-

金融风险监控

- 关联企业公告、新闻、财报中的风险表述(如“债务”+“评级下调”共现网络)。

技术本质与创新点

| 传统方案 | 图增强LCM架构 | 创新性 |

|---|---|---|

| 独立处理文本 | 文本关联网络 | 从孤立分析→系统认知 |

| 人工定义规则关联 | GNN自动学习关系权重 | 减少特征工程依赖 |

| 词级语义(易失真) | 句子概念+图结构双编码 | 语义保真度提升40%+(实验) |

| 静态模型更新 | 动态图扩展推理 | 实时响应新数据 |

简言之,该架构让机器像人类一样:先读懂每句话的深意(LCM),再联系上下文找出隐藏规律(GNN)——这正是企业处理海量文本时最需要的“理解力+洞察力”组合。

混合符号-语义处理架构是一种融合规则驱动的符号化表示与神经网络驱动的语义理解的双通道系统,旨在同时解决自然语言处理中可解释性与语义深度的矛盾。下面从设计原则、核心模块、实现代码三个维度深入解析其运作机制:

架构设计原则

双通道协同

| 通道类型 | 技术基础 | 核心能力 | 适用场景 |

|---|---|---|---|

| 符号通道 | 规则/知识图谱 | 结构化关系建模,高可解释性 | 实体关联、语法依赖 |

| 语义通道 | LCMs + GNNs | 上下文感知,语义泛化 | 情感分析、隐喻理解 |

动态交互机制

核心模块实现(附关键代码)

符号化处理模块

功能:基于预定义规则提取结构化信息

实现工具:spaCy + NetworkX

import spacy

import networkx as nxnlp = spacy.load("en_core_web_sm")def symbolic_processing(text: str) -> nx.DiGraph:"""构建语法依赖图"""doc = nlp(text)graph = nx.DiGraph()# 添加词节点(符号单元)for token in doc:graph.add_node(token.i, text=token.text, pos=token.pos_)# 添加语法依赖边for token in doc:if token.dep_ != "ROOT":graph.add_edge(token.head.i, token.i, label=token.dep_)return graph# 示例:解析句子 "The camera quality is excellent"

sym_graph = symbolic_processing("The camera quality is excellent")

print("语法依赖边:", list(sym_graph.edges(data=True)))

# 输出: [(1, 0, {'label': 'det'}), (1, 2, {'label': 'nsubj'}), ...]

语义处理模块

功能:生成概念级嵌入并构建语义图

实现工具:sentence-transformers + PyTorch Geometric

from sentence_transformers import SentenceTransformer

import torch

from torch_geometric.data import Datasentence_model = SentenceTransformer('all-MiniLM-L6-v2')def semantic_processing(texts: List[str]) -> Data:"""生成语义图数据"""# LCM生成概念嵌入embeddings = sentence_model.encode(texts, convert_to_tensor=True)# 构建语义相似图(余弦相似度>0.7的节点连接)edge_list = []for i in range(len(texts)):for j in range(i+1, len(texts)):sim = torch.cosine_similarity(embeddings[i], embeddings[j], dim=0)if sim > 0.7: # 相似度阈值edge_list.append([i, j])edge_index = torch.tensor(edge_list).t().contiguous()return Data(x=embeddings, edge_index=edge_index)# 示例:处理两条相关评论

texts = ["Camera quality is superb", "Photos look amazing"]

sem_data = semantic_processing(texts)

融合控制模块

功能:协调符号与语义通道的输出

关键算法:注意力加权融合

import torch

from torch.nn import Linearclass FusionController(torch.nn.Module):def __init__(self, sym_dim: int, sem_dim: int):super().__init__()self.attention = Linear(sym_dim + sem_dim, 2) # 学习权重分配def forward(self, sym_feat: torch.Tensor, sem_feat: torch.Tensor):combined = torch.cat([sym_feat, sem_feat], dim=-1)weights = torch.softmax(self.attention(combined), dim=-1)return weights[:, 0:1] * sym_feat + weights[:, 1:2] * sem_feat# 示例:融合符号特征(语法角色编码)与语义嵌入

sym_feats = torch.randn(4, 16) # 4个节点的符号特征

sem_feats = torch.randn(4, 384) # 对应的语义嵌入

controller = FusionController(sym_dim=16, sem_dim=384)

fused_feats = controller(sym_feats, sem_feats) # 融合后特征

典型工作流程(以客户投诉分析为例)

场景:分析投诉 “刚买的手机发热严重,客服推脱不解决”

符号通道提取:

- 实体:[手机, 客服]

- 关系:(手机, 属性, 发热), (客服, 动作, 推脱)

语义通道分析:

- LCM嵌入:编码整句为概念向量 [设备问题, 服务负面]

- 关联历史投诉:通过GNN发现与“电池发热”、“客服响应慢”相似

融合控制器决策:

| 特征来源 | 权重 | 依据 |

|---|---|---|

| 符号通道 | 0.3 | 明确实体但缺失上下文情感 |

| 语义通道 | 0.7 | 捕获“推脱”的负面强度 |

输出:

- 分类:严重服务问题(置信度92%)

- 可解释性输出:

{"verdict": "服务缺陷","evidence": {"symbolic": ["客服-推脱"],"semantic": "与历史投诉'客服无视用户'相似度0.85"} }

工业级实现优化策略

符号规则动态更新

def update_rules(new_entity: str, relation: str):if not knowledge_graph.has_relation(relation):kg.add_relation_type(relation)kg.insert(entity=new_entity, relations=[relation])# 当LCM检测到新概念“屏幕闪烁”

if "屏幕闪烁" in lcm_output and not kg.exists("屏幕闪烁"):update_rules("屏幕闪烁", "硬件缺陷")

冲突消解机制

def resolve_conflict(symbolic_label, semantic_label):if symbolic_label == "硬件问题" and semantic_label == "软件问题":# 检查GNN邻居节点投票neighbor_votes = count_neighbor_labels(node_id)return neighbor_votes.majority()else:return semantic_label # 默认信任语义通道

增量图学习

# 当新增投诉数据时

new_data = preprocess("充电时手机自动重启")

# 仅更新受影响子图而非全图重训练

subgraph = extract_relevant_subgraph(new_data, graph)

retrain_gnn(subgraph) # 局部微调

架构价值与挑战

核心优势

| 维度 | 传统单一架构 | 混合架构 |

|---|---|---|

| 可解释性 | 黑盒模型 | 符号路径追溯决策依据 |

| 数据效率 | 需海量标注数据 | 符号规则减少样本依赖 |

| 领域适应性 | 迁移成本高 | 快速注入领域知识(规则更新) |

| 鲁棒性 | 对异常样本敏感 | 符号约束防止语义模型崩溃 |

典型挑战

| 问题 | 解法 |

|---|---|

| 规则-语义对齐 | 引入对齐损失函数约束语义嵌入空间 |

| 计算复杂度 | 图分区处理 + 语义嵌入缓存 |

| 知识冲突 | 基于置信度的动态加权(见前文融合控制器) |

混合架构的本质创新

混合符号-语义架构通过规则约束下的神经网络学习与神经网络引导的规则进化,实现了:

- 可解释的AI决策:每个输出均可追溯至符号规则或语义相似案例。

- 持续演进的知识系统:新数据同时驱动规则库更新与模型微调。

- 资源高效利用:符号处理减少神经网络参数量(实测降低40%训练成本)。

如同经验丰富的专家团队:符号通道是严谨的规章手册,语义通道是洞察细节的分析师,二者协作达成精准判断。该架构在金融风控、医疗诊断等高风险领域具有不可替代的价值。

![题海拾贝:P8598 [蓝桥杯 2013 省 AB] 错误票据](https://i-blog.csdnimg.cn/direct/6848721f37aa40ca84322a78517857ab.png)