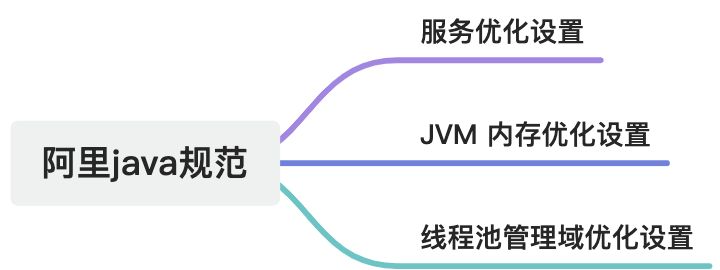

摘要

这篇文章主要介绍了阿里巴巴Java开发中关于远程调用超时设置、线程池隔离、服务器性能优化等编码规范的实践解析。强调了超时设置的重要性,提供了多种技术栈的超时设置示例。同时,探讨了高并发服务器的TCP协议time_wait超时时间调优、最大文件句柄数调整、JVM参数优化等实践。还涉及了线程池隔离的必要性及实现方式,以及服务器重定向的规范和线程池管理的解决方案。

1. 【强制】调用远程操作必须有超时设置。

说明:类似于 HttpClient 的超时设置需要自己明确去设置 Timeout。根据经验表明,无数次的故障都是因为没有设置超时时间。

1.1. 📌 为什么必须设置超时时间?

- 防止请求长时间阻塞:如果远程服务无响应、网络异常、服务器挂掉,没有超时设置会导致线程永久等待,最终导致系统资源耗尽。

- 提升系统稳定性:合理的超时可以让调用快速失败,触发降级或重试机制,避免雪崩效应。

- 方便排查问题:超时异常通常能明确暴露在哪个调用点,便于定位问题。

1.2. 🔧 不同技术中的超时设置示例

1.2.1. Java HttpClient (Apache HttpClient)配置

RequestConfig config = RequestConfig.custom()

.setConnectTimeout(5000) // 连接超时

.setSocketTimeout(10000) // 响应超时

.build();CloseableHttpClient client = HttpClients.custom()

.setDefaultRequestConfig(config)

.build();1.2.2. OkHttp配置

OkHttpClient client = new OkHttpClient.Builder()

.connectTimeout(5, TimeUnit.SECONDS)

.readTimeout(10, TimeUnit.SECONDS)

.writeTimeout(10, TimeUnit.SECONDS)

.build();1.2.3. Spring WebClient配置

WebClient webClient = WebClient.builder().clientConnector(new ReactorClientHttpConnector(HttpClient.create().responseTimeout(Duration.ofSeconds(10)).option(ChannelOption.CONNECT_TIMEOUT_MILLIS, 5000))).build();1.2.4. Feign(Spring Cloud OpenFeign)配置

feign:client:config:default:connectTimeout: 5000readTimeout: 100001.2.4.1. Dubbo RPC配置

dubbo.consumer.timeout=50001.3. ✅ 最佳实践建议

- 统一配置:将超时参数统一抽取到配置中心或配置文件,避免散落在代码中。

- 结合降级机制:如与 Hystrix、Sentinel 配合使用超时快速失败。

- 合理设置时间:连接超时较短(1~5秒),读写超时根据业务适当配置。

2. 【推荐】客户端设置远程接口方法的具体超时时间(单位 ms),超时设置生效顺序一般为:1)客户端 Special Method;2)客户端接口级别;3)服务端 Special Method;4)服务端接口级别。

2.1. 1️⃣ 精细化设置超时时间

不同方法的业务复杂度、响应速度差异很大,统一设置会导致:

- 有的方法不必要地等待太长时间;

- 有的方法因为设置太短频繁超时。

建议在客户端对每个远程方法设置具体超时时间,精细控制资源和响应预期。

2.2. 2️⃣ 生效优先级策略

多层配置时,优先级按照以下顺序覆盖:

- 客户端某个方法的特殊配置(最优先)

- 客户端整个接口配置

- 服务端某个方法的特殊配置

- 服务端整个接口默认配置(优先级最低)

2.3. 🔧 实际示例(以 Dubbo 为例)

2.3.1. ✅ 1. 客户端 Special Method 超时配置(优先级最高)

<dubbo:reference interface="com.example.DemoService"><dubbo:method name="getUserInfo" timeout="3000"/>

</dubbo:reference>或通过配置文件方式:

dubbo.reference.DemoService.methods.getUserInfo.timeout=30002.3.2. ✅ 2. 客户端接口级别超时配置

<dubbo:reference interface="com.example.DemoService" timeout="5000"/>dubbo.reference.DemoService.timeout=50002.3.3. ✅ 3. 服务端 Special Method 超时配置(若客户端未指定,则使用此配置)

<dubbo:service interface="com.example.DemoService"><dubbo:method name="getUserInfo" timeout="4000"/>

</dubbo:service>2.3.4. ✅ 4. 服务端接口级别超时配置

<dubbo:service interface="com.example.DemoService" timeout="6000"/>2.4. ✅ 建议实践策略

| 方法类别 | 建议超时设置 | 理由说明 |

| 查询类(read) | 100~500ms | 响应快,尽早失败 |

| 写入类(write) | 500~3000ms | 写操作一般较慢,需一定容忍度 |

| 批量任务/导出等 | 3000~10000ms | 属于大数据处理或异步操作 |

3. 【推荐】高并发服务器建议调小TCP协议的time_wait超时时间。

说明:操作系统默认 240 秒后,才会关闭处于 time_wait 状态的连接,在高并发访问下,服务器端会因为处于

time_wait 的连接数太多,可能无法建立新的连接,所以需要在服务器上调小此等待值。

正例:在 linux 服务器上请通过变更/etc/sysctl.conf 文件去修改该缺省值(秒):net.ipv4.tcp_fin_timeout=30

3.1. 🧠 背景知识:什么是 TIME_WAIT?

TIME_WAIT是 TCP 四次挥手断连接后,主动关闭连接的一方保持的状态,用于确保对端收到最后的 ACK 包。- 默认持续时间为 2 倍的最大报文生存时间(MSL),通常为 240 秒(Linux 默认)。

3.2. 🧨 问题场景

- 在高并发请求中(如网关、服务提供者、反向代理服务器等),频繁创建 TCP 连接可能导致服务器出现大量

TIME_WAIT连接。 - 这些连接会占用端口资源(尤其是客户端使用短连接时),从而触发 端口耗尽或连接失败。

3.3. 🔧 实践操作:Linux 系统调优

3.3.1. 1️⃣ 修改 TIME_WAIT 超时时间(单位:秒)

sudo vim /etc/sysctl.conf添加或修改以下内容:

net.ipv4.tcp_fin_timeout = 30立即生效:

sudo sysctl -p3.3.2. 2️⃣ 推荐搭配的优化参数(可选)

# 启用快速回收 TIME_WAIT sockets(仅建议用于服务器作为客户端发起连接的场景)

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_tw_recycle = 0 # 注意:这个参数在新内核中已被移除/废弃# 增加本地可用端口范围

net.ipv4.ip_local_port_range = 1024 65000# 启用 socket 快速释放

net.ipv4.tcp_max_tw_buckets = 5000⚠️ 注意事项:tcp_tw_reuse=1 是安全的,但 tcp_tw_recycle=1 可能导致 NAT 环境中连接问题,不推荐使用。

3.4. 🧪 验证效果

可以通过以下命令查看 TIME_WAIT 状态数量是否减少:

netstat -an | grep TIME_WAIT | wc -l或者使用更现代的 ss 命令:

ss -ant | grep TIME-WAIT | wc -l3.5. ✅ time_wait优化总结

| 参数 | 推荐设置 | 说明 |

|

|

| 减少 TIME_WAIT 持续时间 |

|

|

| 启用端口重用 |

|

|

| 扩大可用端口范围 |

4. 服务在容器是否还需要调整TIME_WAIT超时时间?

4.1. 容器内是应用服务的主动发起方(例如微服务客户端、短连接调用者)

✅ 建议调优容器宿主机的 TCP 参数(尤其是 tcp_fin_timeout)

- 容器内部的网络请求最终走的是 宿主机的内核网络栈。

- 即使你在容器内看到很多

TIME_WAIT,实际上资源是占用在宿主机。 - 所以要在 宿主机级别调优 TCP 参数,而不是容器内部。

4.2. 服务是高并发服务的接受方(例如网关、Nginx、Tomcat)

✅ 建议调优宿主机内核参数,或通过服务自身连接池等方式优化

- 如果你在容器中部署高并发 Web 服务,连接来自客户端或其他服务,仍然可能产生大量

TIME_WAIT。 - 这时,问题同样表现为宿主机网络栈端口被占满。

4.3. 📌 重点:容器网络模型会影响调优位置

常见的容器网络模式:

| 网络模式 | 是否使用宿主机网络栈 | 参数调优位置 |

|

| ✅ 是 | 宿主机内核 |

|

| ✅ 是 | 宿主机内核 |

|

| ✅ 是 | 宿主机内核 |

|

| ❌ 否(几乎不用) | 容器无网络功能 |

结论:不管是哪种容器网络模式,TCP网络最终都走宿主机网络栈,因此调优参数时重点是宿主机而非容器本身。

4.4. 🔧 建议做法

- 在宿主机上配置如下参数:

echo "net.ipv4.tcp_fin_timeout=30" >> /etc/sysctl.conf

echo "net.ipv4.tcp_tw_reuse=1" >> /etc/sysctl.conf

echo "net.ipv4.ip_local_port_range=1024 65000" >> /etc/sysctl.conf

sysctl -p- 如使用 Kubernetes,可在节点初始化脚本中设置上述参数,或者使用 DaemonSet +

initContainers注入内核配置。 - 容器镜像中不需要专门调这些参数,因为容器本身一般无权限修改内核参数(

/proc/sys是只读的,除非加了--privileged权限,不推荐这样做)。

4.5. 🧪 补充建议

- 使用连接池(如 HTTP 连接池、数据库连接池)减少短连接,降低

TIME_WAIT产生频率。 - 优先考虑 KeepAlive 连接。

- 对于非关键应用,也可以使用无连接协议(如 UDP)或消息队列缓冲。

| 是否需要设置 | 操作位置 | 原因 |

| ✅ 需要 | 宿主机 | 容器网络最终依赖宿主机内核网络栈 |

5. 【推荐】调大服务器所支持的最大文件句柄数(File Descriptor,简写为 fd)

说明: 主流操作系统的设计是将 TCP / UDP 连接采用与文件一样的方式去管理, 即一个连接对应于一个 fd。 主流的 linux服务器默认所支持最大 fd 数量为 1024, 当并发连接数很大时很容易因为 fd 不足而出现“open too many files”错误,导致新的连接无法建立。建议将 linux 服务器所支持的最大句柄数调高数倍(与服务器的内存数量相关)。

5.1. 📌 背景知识

- fd(File Descriptor) 是 Linux 对所有“文件对象”的引用标识,文件、Socket、管道等都通过 fd 访问。

- 每一个客户端连接(如 HTTP 请求)都占用一个 fd,文件打开也会占用 fd。

举例:一个服务并发 5000 个连接,日志写入本地,数据库连接池开了 100,Redis 连接池开了 50,分分钟超过默认的 1024 个 fd 限制!

5.2. 🔧 Linux 中调优最大 fd 的三层设置

5.2.1. ✅ 1. 查看当前最大句柄数限制(软/硬限制)

ulimit -n # 当前用户的软限制

ulimit -Hn # 当前用户的硬限制默认一般是:

10245.2.2. ✅ 2. 临时生效:使用 ulimit 命令(适合调试、容器 entrypoint)

ulimit -n 65535但这种方式 只对当前 shell 有效,重启无效。

5.2.3. ✅ 3. 永久生效方式(推荐)

修改系统最大 fd 配置

sudo vim /etc/security/limits.conf添加:

* soft nofile 65535

* hard nofile 65535* 表示对所有用户,也可以针对具体用户配置。

修改 PAM 会话控制配置

sudo vim /etc/pam.d/common-session添加(有些系统是 common-session-noninteractive):

session required pam_limits.so修改 systemd 启动服务的文件(适用于 systemd 管理的服务)

比如你部署的服务是 systemd 启动的:

sudo vim /etc/systemd/system/your-service.service添加:

[Service]

LimitNOFILE=65535然后:

sudo systemctl daemon-reexec

sudo systemctl daemon-reload

sudo systemctl restart your-service5.3. ✅ 如果在容器中部署该服务

容器默认也继承宿主机的最大 fd 限制,因此还需:

- 在 docker run 启动时添加参数:

docker run --ulimit nofile=65535:65535 ...- 或在 Kubernetes 的 Pod spec 中设置:

spec:containers:- name: appimage: your-imagesecurityContext:privileged: trueresources:limits:memory: "1Gi"...hostConfig:ulimits:- name: nofilesoft: 65535hard: 655355.4. 📊 参考配置建议(按内存大小)

| 服务器内存 | 建议 fd 限制(nofile) |

| 2 GB | 16384 |

| 4~8 GB | 32768~65535 |

| ≥ 16 GB | 131072~1048576 |

5.5. 🧪 验证是否生效

ulimit -n

# 或

cat /proc/$(pidof your-service)/limits | grep "Max open files"5.6. ✅ 最大文件句柄数总结

- 文件句柄(fd)对高并发服务非常关键。

- 默认限制远远不能满足生产需求。

- 正确调优方式应通过

limits.conf + pam_limits + systemd组合实现。 - 容器中需通过

--ulimit或 Kubernetes 配置额外设置。

6. 【推荐】给 JVM 环境参数设置-XX:+HeapDumpOnOutOfMemoryError 参数,让 JVM 碰到 OOM 场景时输出 dump 信息。

说明:OOM 的发生是有概率的,甚至相隔数月才出现一例,出错时的堆内信息对解决问题非常有帮助。开启 -XX:+HeapDumpOnOutOfMemoryError通常不会影响程序正常运行的性能或行为,因为它只在 JVM 抛出 OOM 异常时才会触发操作。

6.1. 🧠 为什么需要开启这个参数?

- OOM(内存溢出)时,堆内对象的分布情况是关键证据。

- 如果没有 dump,开发只能“靠猜”定位问题(如:哪个集合泄漏、线程占用、内存缓存未清理等)。

- 有了 dump,可以通过 MAT、JProfiler 等工具精准分析内存泄漏、引用链、占用比例等。

6.2. 🔧 参数说明

| JVM 参数 | 含义 |

|

| 一旦 OOM,就自动导出堆 dump 文件 |

|

| 指定 heap dump 文件保存路径(默认当前目录) |

6.3. 📌 示例:完整 JVM 启动参数配置

java -Xms1g -Xmx1g -XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=/var/log/heapdump -jar your-app.jar6.4. 📁 HeapDumpPath 配置建议

- 选择一个磁盘空间足够的路径(heap dump 通常 300MB~几 GB)

- 确保运行用户有写入权限

- 可与日志目录统一管理,例如

/var/log/app/、/data/logs/heapdump/

6.5. ✅ Spring Boot 示例配置(application.yml 无法配置,需要在启动脚本中设置)

6.5.1. 启动脚本设置(推荐做法)

JAVA_OPTS="-Xms2g -Xmx2g -XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=/data/logs/heapdump java $JAVA_OPTS -jar app.jar6.6. 📊 dump 文件命名规则

默认生成的 dump 文件格式类似:

java_pid12345.hprof你可以使用 shell 自动定期清理旧文件或做备份上传。

6.7. 🧪 OOM 模拟测试(可选)

public class OOMSimulator {public static void main(String[] args) {List<byte[]> list = new ArrayList<>();while (true) {list.add(new byte[10 * 1024 * 1024]); // 每次申请 10MB}}

}运行时使用:

java -Xmx100m -XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=./ -cp . OOMSimulator观察生成的 *.hprof 文件。

6.8. ✅ 总结

| 项目 | 是否推荐 | 说明 |

|

| ✅ 强烈推荐 | 必须启用,用于排查 OOM 问题 |

|

| ✅ 推荐 | 设置为稳定目录,便于运维 |

7. 【推荐】在线上生产环境,JVM 的 Xms 和 Xmx 设置一样大小的内存容量,避免在GC后调整堆大小带来的压力。

7.1. 🧠 背后原理

| 参数 | 含义 |

|

| JVM 启动时分配的初始堆大小 |

|

| JVM 运行时允许分配的最大堆大小 |

如果这两个值不一致,JVM 会在应用运行过程中动态扩大或缩小堆(尤其是使用 CMS、G1 时),这种行为可能引起:

- 内存分配时卡顿(暂停 STW)

- 频繁的 Full GC

- 性能波动或抖动

- 堆结构重建、碎片整理、虚拟内存抖动

尤其是在高并发、低延迟的生产环境下,这种堆自动扩缩容的开销会让性能不稳定、可观测性变差。

7.2. 📌 正确做法:Xms = Xmx

7.2.1. ✅ 推荐统一设置

-Xms2g -Xmx2g表示:

- 一启动就分配 2GB 的堆

- 后续运行过程不再动态扩缩容

这样做的好处:

| 优点 | 描述 |

| 稳定性高 | 避免动态扩缩容引发的性能抖动 |

| 预留内存 | JVM 一启动就从操作系统预留所有堆内存,防止后期抢不到物理内存 |

| GC 可控 | 堆大小稳定,GC 行为规律,便于调优和预警 |

| 易于监控 | 应用监控中,堆使用率变化更有参考意义 |

7.3. 🧪 实战示例

在 startup.sh 或 systemd 服务中配置:

JAVA_OPTS="-Xms2g -Xmx2g \-XX:+HeapDumpOnOutOfMemoryError \-XX:HeapDumpPath=/data/logs/heapdump"java $JAVA_OPTS -jar app.jar7.4. ⚠️ 注意事项

| 项目 | 注意点 |

| 内存预估 | 需要根据实际业务吞吐量、内存曲线评估一个合理的初始/最大堆大小 |

| 容器环境 | 在容器中使用 |

| 非常规模式 | 某些开发测试环境可以允许不一致(节省资源),但不推荐在生产中使用 |

7.5. JVM 内存参数配置总结

| 参数设置 | 推荐级别 | 说明 |

|

| ✅ 强烈推荐 | 避免扩容/缩容带来的 GC 抖动 |

|

| ❌ 不建议 | 默认行为可能导致不可预知的性能问题 |

8. 【推荐】了解每个服务大致的平均耗时,可以通过独立配置线程池,将较慢的服务与主线程池隔离开,免得不同服务的线程同归于尽。

8.1. 🧠 为什么要线程池隔离?

在微服务或多业务并发系统中,不同的远程调用/任务处理往往具有:

- 不同的平均耗时(fast vs. slow)

- 不同的并发需求(高频 vs. 低频)

- 不同的重要性/容忍度(核心服务 vs. 附属服务)

如果它们共享同一个线程池,可能出现:

8.2. ❌ 问题场景

| 场景 | 问题 |

| 某慢服务卡住线程 | 快速服务也排队等待,整体响应变慢 |

| 突发请求雪崩 | 线程池满,所有服务挂掉 |

| 主线程池共用 | 一个服务崩溃拖垮整个系统(线程池污染) |

8.3. ✅ 线程池隔离示意图

请求 A -->│ Fast Pool │--> FastService(平均耗时 30ms)

请求 B -->│ Slow Pool │--> SlowService(平均耗时 500ms)- 高速、实时接口走 FastPool

- IO 密集、慢调用接口走 SlowPool

避免慢服务拖垮快服务。

8.4. 🧩 实战做法(以 Spring Boot 为例)

8.4.1. 定义多个线程池 Bean(推荐使用 @Configuration)

@Configuration

public class ThreadPoolConfig {@Bean("fastServiceExecutor")public Executor fastServiceExecutor() {return new ThreadPoolExecutor(20, 50,60, TimeUnit.SECONDS,new LinkedBlockingQueue<>(1000),new ThreadFactoryBuilder().setNameFormat("fast-pool-%d").build());}@Bean("slowServiceExecutor")public Executor slowServiceExecutor() {return new ThreadPoolExecutor(10, 30,120, TimeUnit.SECONDS,new LinkedBlockingQueue<>(2000),new ThreadFactoryBuilder().setNameFormat("slow-pool-%d").build());}

}8.4.2. 使用指定线程池异步执行

@Async("fastServiceExecutor")

public void processFast() {// 快速业务处理

}@Async("slowServiceExecutor")

public void processSlow() {// 慢业务调用,如远程 HTTP、数据库大查询等

}记得启用 @EnableAsync 注解。

8.5. 🧠 如何评估是否需要拆分线程池?

| 判断依据 | 描述 |

| 服务平均耗时差距大 | 如一个 50ms、一个 800ms,就应该拆分 |

| 调用量差距大 | 高频与低频请求混用线程池容易抢占 |

| 服务级别差异 | 核心服务与非核心服务不应共享线程池 |

| 出现过线程池打满/阻塞 | 分析后应立即隔离热点服务 |

8.6. 📈 更进一步的优化建议

- 配合 Hystrix/Fuse/Resilience4j 实现线程池+熔断组合策略

- 配合监控系统(如 Prometheus + Grafana)观察线程池使用情况

- 对外部依赖服务(如第三方支付、OCR等)强烈建议独立线程池 + 限流

8.7. ✅ 线程池使用总结

| 项目 | 推荐做法 |

| 多服务调用 | 按耗时拆分线程池 |

| 核心 vs 非核心服务 | 独立隔离,防止拖垮 |

| IO/慢服务 | 设置更大队列、更长超时 |

| 高速/重要服务 | 提高核心线程数,防抖 |

9. 【参考】服务器内部重定向必须使用 forward;外部部重定向地址必须使用 URL Broker 生成,否则因线上采用 HTTPS 协议而导致浏览器提示“不安全”。此外,还会带来 URL 维护不一致的问题。

9.1. 服务器内部重定向使用 forward

✅ 原因

forward是 服务端行为,不会改变浏览器地址,也不会产生额外的 HTTP 请求。- 用于:控制流转逻辑(如认证拦截器跳转登录页、表单校验失败回原页)。

❌ 不建议使用 sendRedirect:

- 多了一次客户端跳转

- 地址栏会改变

- 浏览器感知异常流程,影响体验

✅ 示例(Java Servlet):

request.getRequestDispatcher("/WEB-INF/jsp/login.jsp").forward(request, response);9.2. 外部重定向必须使用 URL Broker 生成地址

✅ 原因

- 在生产环境中,URL 多采用 HTTPS,但硬编码的 URL(如

http://...)容易带来:

-

- 浏览器不安全警告(因为跨协议跳转)

- 维护困难(不同环境地址不同)

- 不一致的跳转行为(域名、端口混乱)

❌ 错误写法(硬编码):

response.sendRedirect("http://example.com/user/home");✅ 正确做法(使用 URL Broker 统一生成):

String redirectUrl = urlBroker.build("userHome");

response.sendRedirect(redirectUrl);URL Broker 通常是一个自定义组件,用于统一管理和构建 URL,例如:

- 按业务模块生成路径

- 按协议自动拼接(http/https)

- 支持灰度域名或测试域名切换

9.3. 🧠 为什么 URL Broker 重要?

| 问题点 | 使用硬编码 | 使用 URL Broker |

| HTTPS 安全警告 | ✅ 有风险 | ❌ 自动规避 |

| 域名变更适配 | ❌ 需要全局修改 | ✅ 自动切换 |

| 多环境部署(dev/test/prod) | ❌ 容易出错 | ✅ 自动识别 |

| 灰度发布支持 | ❌ 不支持 | ✅ 可扩展 |

9.4. 📌 实战建议

- 在前后端分离项目中:后端返回统一跳转标识码 + URL Broker 生成地址,前端执行

window.location.href - 在 Spring 中:建议封装一个

UrlManager组件,支持注入域名/协议/环境前缀等参数 - URL Broker 的配置可以参考 Nacos/Consul 等配置中心

9.5. 服务器地址跳转总结

| 项目 | 推荐做法 | 原因 |

| 内部跳转 |

| 无额外 HTTP 请求,控制流转 |

| 外部跳转 | URL Broker + | 避免 HTTPS 问题、维护一致性 |

| 协议/域名维护 | URL Broker 自动管理 | 降低手动出错风险,提高可维护性 |

10. java项目线程池的使用与解决方案

在中大型 Java 项目中,线程池的设计与管理是并发性能、系统稳定性、故障隔离、资源利用率优化的关键组成部分之一。以下是一个系统化的线程池管理策略,适用于金融、电商、SaaS 等业务密集型应用。在阿里等大厂的 Spring 项目中,线程池资源的使用与管理是非常核心的系统能力,它关系到:

- 服务高可用性(防止线程耗尽)

- 并发性能(提升吞吐)

- 故障隔离(避免雪崩)

- 成本控制(避免过度资源占用)

- 可观测性(线程池运行状态监控)

推荐做法: 只为真正有“资源隔离需求”的业务定义线程池。通常 3~6 个线程池足以支撑绝大多数项目。

10.1. 为什么要统一线程池管理?

| 问题 | 描述 |

| 线程池混乱 | 各模块随意创建,资源不可控 |

| 无法监控 | 无法统一统计任务耗时、队列长度、拒绝次数等 |

| 难以隔离 | 核心服务与边缘服务共用线程池导致雪崩 |

| 故障恢复难 | 无法快速定位、限流、熔断问题接口 |

10.2. 🔆 项目中线程池常见用途分类

| 类型 | 用途 | 特性 |

| Controller异步处理池 | 异步响应客户端请求 | 快速、轻量、低延迟 |

| 远程服务线程池 | 调用外部 HTTP/RPC 接口 | 受服务端性能影响,需超时设置 |

| 定时任务线程池 | 定时执行清理、统计等任务 | 运行时间不一,吞吐量可控 |

| MQ 消费线程池 | 消费 Kafka、RabbitMQ 消息 | 需保证线程安全和幂等 |

| 自定义业务隔离池 | 比如风控、报表生成、OCR | 明显慢任务,必须隔离 |

10.3. 🧠 线程池资源使用设计原则(阿里内部通行规范)

| 原则 | 说明 |

| 1️⃣ 必须统一线程池配置入口 | 所有线程池在统一配置类中定义,便于管理 |

| 2️⃣ 不允许随意创建线程池实例 | 禁用 这类隐式线程池 |

| 3️⃣ 线程池按职责隔离 | 耗时服务、MQ 消费、远程调用、限流服务等用独立线程池 |

| 4️⃣ 必须设置拒绝策略 | 线程池资源耗尽后如何处理(拒绝/降级/阻塞)需明确 |

| 5️⃣ 必须支持可视化监控 | 每个线程池运行指标必须可观测 |

| 6️⃣ 推荐支持动态扩容调参 | 核心线程数、队列大小可在不中断服务情况下动态调整 |

10.4. 🧱 二、典型线程池分类与设计用途

| 类型 | 用途 | 推荐配置(可动态调参) |

|

| 主业务线程池(接口处理) | 核心 20,最大 100,队列 1000 |

|

| 远程 HTTP/RPC 调用 | 核心 30,最大 100,队列 500 |

|

| MQ 消费线程池 | 核心 50,最大 200,队列 2000 |

|

| 慢任务处理(如 OCR、报表) | 核心 10,最大 30,队列 300 |

|

| 定时任务线程池 | 使用 |

10.5. 📦 核心组件设计(阿里风格)

10.5.1. ✅ 统一线程池注册与配置中心

@Configuration

public class ThreadPoolConfig {@Bean("bizExecutor")public ThreadPoolExecutor bizExecutor() {return buildExecutor("biz-pool", 20, 100, 1000);}@Bean("remoteExecutor")public ThreadPoolExecutor remoteExecutor() {return buildExecutor("remote-pool", 30, 100, 500);}private ThreadPoolExecutor buildExecutor(String name, int core, int max, int queue) {return new ThreadPoolExecutor(core, max, 60L, TimeUnit.SECONDS,new LinkedBlockingQueue<>(queue),new ThreadFactoryBuilder().setNameFormat(name + "-%d").build(),new ThreadPoolExecutor.CallerRunsPolicy());}

}10.5.2. ✅ 统一管理中心(支持状态查询)

@Component

public class ThreadPoolManager {@Resource(name = "bizExecutor")private ThreadPoolExecutor bizExecutor;public Map<String, Object> getBizStatus() {return Map.of("active", bizExecutor.getActiveCount(),"queue", bizExecutor.getQueue().size(),"completed", bizExecutor.getCompletedTaskCount());}

}10.5.3. ✅ Prometheus 指标暴露(用于 Grafana 展示)

@PostConstruct

public void registerBizPoolMetrics() {Gauge.builder("threadpool.biz.active", bizExecutor, ThreadPoolExecutor::getActiveCount).register(registry);Gauge.builder("threadpool.biz.queue", bizExecutor, executor -> executor.getQueue().size()).register(registry);

}配合 Grafana 展示图表。

10.5.4. ✅ 动态调参能力(接入配置中心)

- 阿里内部用 Diamond / Nacos + 推送机制 来动态调整核心参数(核心线程数、队列大小)。

- Spring Cloud Alibaba 用户可接入 Nacos + @RefreshScope 实现动态线程池参数注入。

10.6. 🧰 线程池统一监控平台(内部实践)

阿里内部会将线程池指标接入:

- Prometheus / Grafana:实时可视化线程池队列大小、活跃线程数、任务完成率等

- 线程池报警规则:如队列积压 > 1000、活跃线程数超标报警、被拒绝任务 > 100 等

- 线程池慢任务采样分析:分析异常耗时任务堆栈、上下文

- Dump 触发机制:线程池异常时触发线程 Dump,辅助排查

10.7. 🚨 线程池使用禁忌(阿里 P6+ 总结)

| 错误用法 | 风险说明 |

| 使用 | 无法限制队列长度,可能 OOM |

| 所有业务共用一个线程池 | 容易雪崩(一个慢任务拖垮全部) |

| 忽略 | 被拒绝任务丢失无感知,极其危险 |

| 无任何监控 | 无法提前预警线程耗尽或任务积压 |

| 创建过多线程池 | 线程调度频繁切换,增加上下文开销 |

10.8. 线程池解决方案阿里设计

| 步骤 | 动作 | 工具/技术 |

| 1️⃣ 分类 | 按业务/功能/外部接口维度拆分线程池 | 多个命名线程池 |

| 2️⃣ 配置 | 设置合理核心/最大线程数、队列、拒绝策略 | ThreadFactoryBuilder、自定义参数 |

| 3️⃣ 注册 | 将线程池注册进管理中心供统一访问 | ThreadPoolManager |

| 4️⃣ 监控 | 暴露 Prometheus 指标 | Micrometer/Grafana |

| 5️⃣ 调参 | 实现线程池动态配置热更新 | Nacos + @RefreshScope / 自定义方案 |

![[GHCTF 2025]SQL???](https://i-blog.csdnimg.cn/direct/525ce8e22c1649bcbb992a50722fd07c.png)