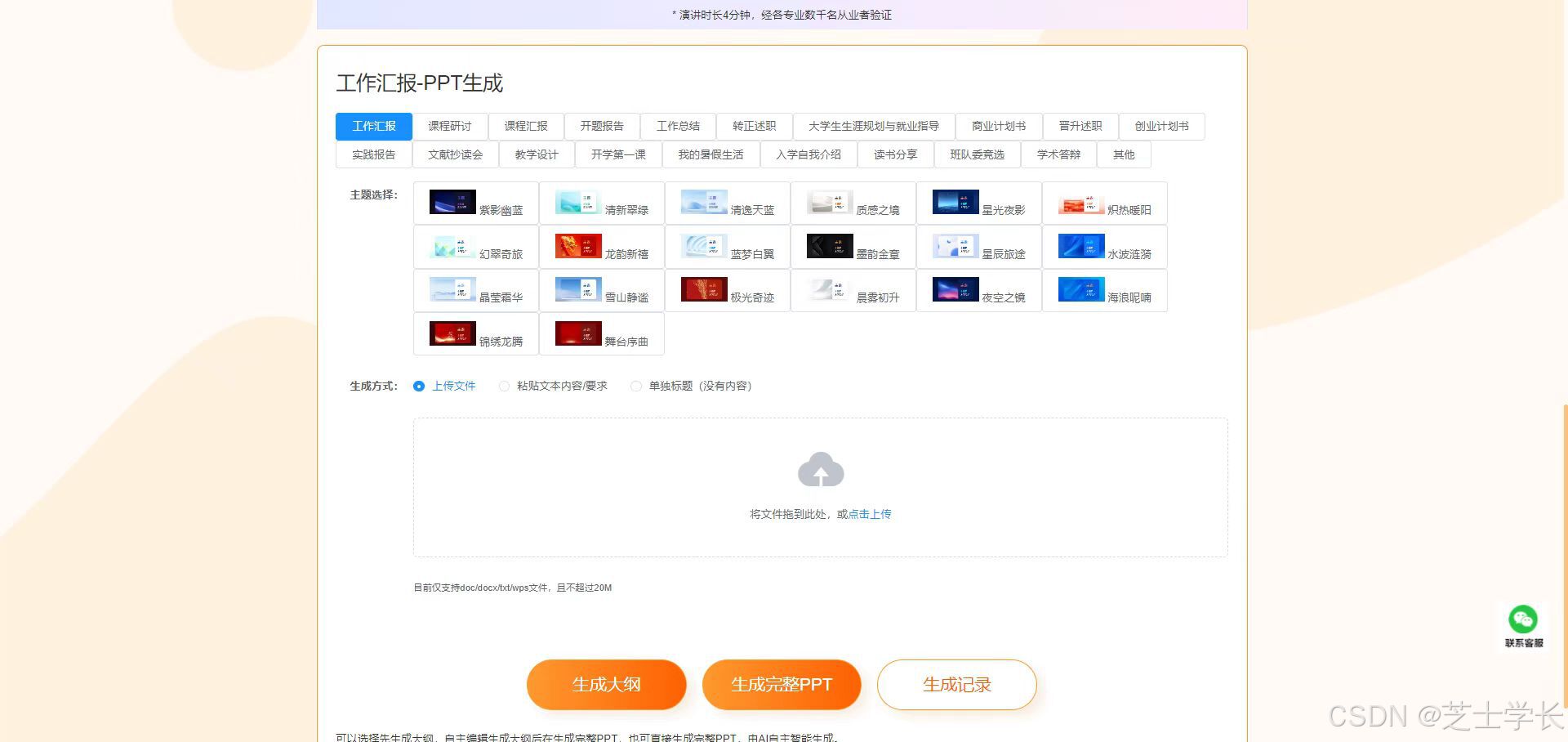

1.创新点介绍

引言

本文将深入解析一个创新的CNN模型架构,它巧妙地将Swin Transformer与自定义的通道-位置交叉注意力(CPCA) 模块相结合。这种设计在保持Transformer强大特征提取能力的同时,通过注意力机制增强了模型对关键特征的聚焦能力。

1. CPCA注意力模块

class CPCA(nn.Module):def __init__(self, in_channels, reduction_ratio=4):# 初始化代码...核心结构

CPCA模块采用双分支并行设计,同时捕捉通道和空间维度的关键信息:

-

通道注意力分支:

-

全局平均池化 → 1×1卷积降维 → ReLU激活 → 1×1卷积恢复维度 → Sigmoid

-

生成形状为

[B, C, 1, 1]的通道权重向量

-

-

<