本文还有配套的精品资源,点击获取

简介:WebRTC是一个开源项目,旨在实现浏览器间无需插件的实时通信,包括音频、视频通话及数据共享。在Android平台上,其实施涉及使用JNI接口进行Java与C/C++代码的交互。本压缩包内容预计涵盖了WebRTC的架构、JNI原理、库集成、连接建立、音视频流处理、信令协议、渲染、错误处理、性能优化以及内存管理等关键知识点,旨在指导开发者在Android应用中实现高质量实时通信功能。

1. WebRTC架构介绍与集成

1.1 WebRTC简介

WebRTC(Web Real-Time Communication)是一项实时通信技术,它允许网页浏览器和移动应用无需插件即可进行实时语音对话、视频聊天以及点对点文件共享。这项技术是由Google公司主导开发,并且免费开源,其设计目标是在网页浏览器之间建立一个点对点的连接,实现低延迟的音视频通信。

1.2 架构概述

WebRTC的架构设计是为了提供高性能的实时通信能力。它由多个组件构成,包括APIs、协议以及硬件抽象层。核心APIs让开发者能够轻松集成WebRTC功能到网页或应用中,而无需深入了解底层细节。底层协议包括了信令协议、媒体传输协议(如SRTP)和ICE网络连通性检测。硬件抽象层用于处理不同硬件平台的兼容性问题。

1.3 集成WebRTC

集成WebRTC到现有的应用或网页中涉及几个关键步骤。首先,需要理解WebRTC的工作方式和其API。然后,获取适合目标平台的WebRTC库,并将其集成到项目中。最后,通过调用API和处理事件来构建应用的实时通信功能。接下来的章节会详细介绍如何在Android等平台上集成WebRTC,以及如何处理媒体流和性能优化等方面的内容。

2. JNI在WebRTC中的应用与优势

2.1 JNI技术概述

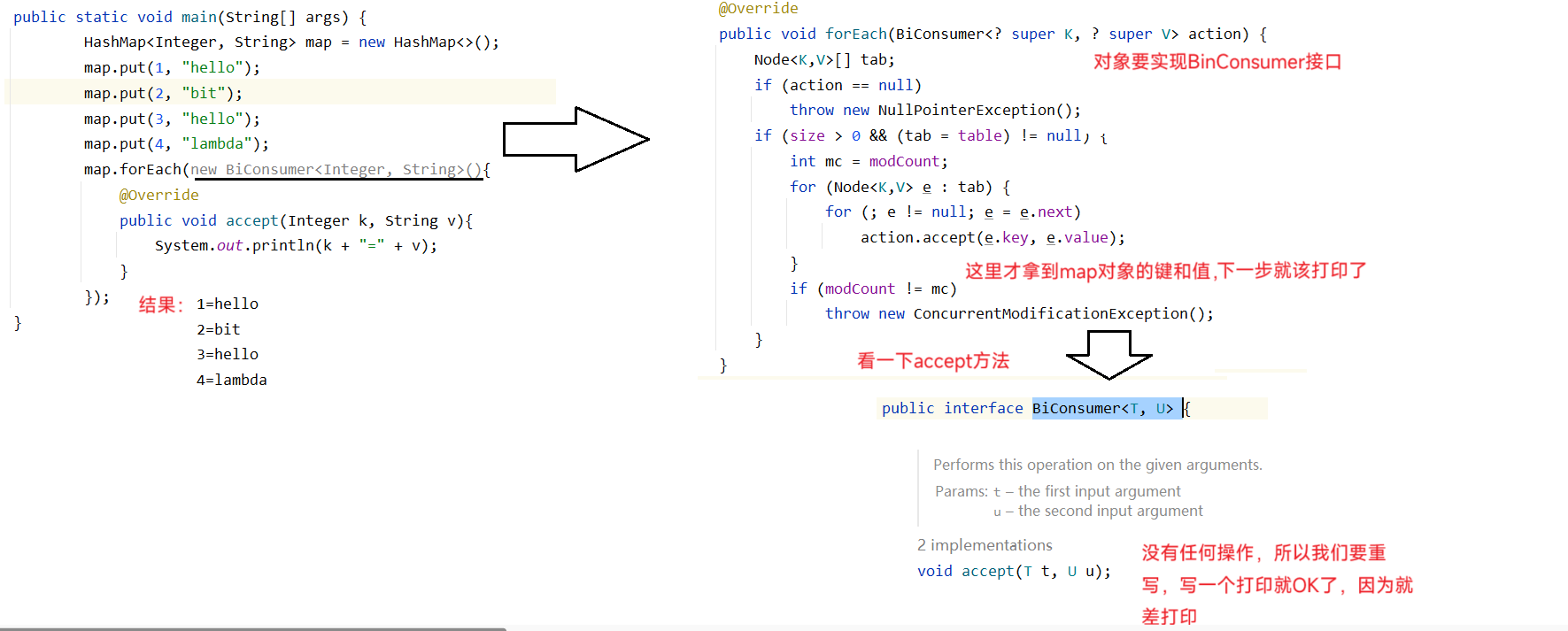

Java Native Interface (JNI) 是一种在Java虚拟机 (JVM) 和本地应用程序或库之间进行交互的标准编程接口。JNI 是Java平台的一部分,允许Java代码调用或被调用本地应用程序接口 (API) 和本地库(如C/C++库)。其主要用途包括性能优化、访问遗留代码库、以及调用其他语言编写的特定平台功能。

2.1.1 JNI的工作原理

在JNI架构中,Java代码运行在JVM上,而本地代码(如C/C++)在宿主操作系统的原生环境中执行。JNI提供了一套规则和函数,使得两者能够互相调用对方的函数或方法。当Java代码需要调用本地代码时,它会通过JNI层来请求,JNI层会负责找到相应的本地函数并调用它,同时处理数据类型之间的转换和内存管理。

2.1.2 JNI与Java和C/C++的关系

JNI位于Java和C/C++的交界处,它是Java和C/C++代码相互通信的桥梁。当Java程序中的方法标记为native时,表示该方法将由本地代码实现。通过使用javah工具生成本地方法的头文件,C/C++代码可以实现这些方法并编译成库文件供Java程序使用。

2.2 JNI在WebRTC中的作用

WebRTC作为一个高性能的实时通信框架,需要与底层的硬件和操作系统紧密集成。WebRTC使用C++编写以保证效率,并且通过JNI技术在Java环境中实现相关接口,以适用于Android等平台上的WebRTC应用。

2.2.1 提高性能的实现机制

WebRTC采用C++来编写其核心算法和数据处理流程,以实现最佳的性能。然而,某些情况下Java层需要访问这些功能,比如在Android应用中。使用JNI,Java层可以调用WebRTC的C++实现的API,并将数据交换给C++层进行处理,这不仅允许Java层处理大量数据,还提高了整体应用的性能和效率。

2.2.2 跨平台兼容性分析

通过JNI,WebRTC能够提供跨平台的兼容性。开发者可以使用Java编写应用层逻辑,通过JNI调用底层的C++编写的WebRTC核心库,而不必担心底层平台的差异。这种设计允许WebRTC被部署到不同的操作系统上,例如在Windows、macOS以及Linux上运行相同的Java应用程序,同时利用各自平台上的WebRTC本地实现。

// 示例代码:Java中的native方法声明

public class WebRTCHelper {static {System.loadLibrary("webrtc_jni"); // 加载WebRTC的JNI库}// Java中声明native方法public native void nativeInitialize();

}

// 示例代码:C++中实现native方法

#include <jni.h>

#include "WebRTCHelper.h"JNIEXPORT void JNICALL Java_WebRTCHelper_nativeInitialize(JNIEnv *env, jobject thiz) {// 在这里初始化WebRTC的C++部分

}

如上面的示例代码展示了Java和C++代码之间的交互。Java代码声明了一个native方法 nativeInitialize ,而C++代码实现了该方法。当Java代码调用 nativeInitialize 时,实际上会委托JNI调用C++层的实现。这是一个双向的过程,Java可以调用C++,反之亦然。

3. Android WebRTC库集成过程

3.1 WebRTC库的下载与导入

WebRTC 是一个开源项目,其源码存储在 Google 的代码托管平台上。为了集成 WebRTC 库到 Android 项目中,开发者通常需要执行一系列的下载和配置步骤。

3.1.1 获取WebRTC源码

WebRTC 的源码可以通过不同的方式获取,但最常用的是使用 depot_tools 工具集中的 fetch 命令。 depot_tools 是 Google 提供的一套用于管理 Chromium 和其他相关开源项目源码的工具集。

以下是获取 WebRTC 源码的基本步骤:

-

安装

depot_tools:bash git clone https://chromium.googlesource.com/chromium/tools/depot_tools.git export PATH="$PATH:<path_to_depot_tools>" -

使用

fetch命令获取 WebRTC 源码:bash fetch --nohooks webrtc

fetch 命令执行完毕后,会在当前目录下创建一个名为 src 的文件夹,其中包含了 WebRTC 的源码。

3.1.2 导入到Android项目中

一旦你有了 WebRTC 的源码,下一步就是将源码导入到你的 Android 项目中。这涉及到以下步骤:

- 在你的 Android Studio 项目中创建一个本地模块,将 WebRTC 源码作为模块加入。

- 确保 Android Studio 能够识别 WebRTC 源码中的 CMakeLists.txt 或 Android.mk 文件。

- 在你的项目级别的 build.gradle 文件中,添加对 WebRTC 模块的依赖。

具体来说,如果你已经有了一个 Android Studio 项目,并希望集成 WebRTC 库,你需要在项目的根目录下的 settings.gradle 文件中添加 WebRTC 模块。例如:

include ':app', ':webrtc'

project(':webrtc').projectDir = new File('path_to_webrtc/src')

然后,在 app 模块的 build.gradle 文件中添加对 webrtc 模块的依赖:

dependencies {implementation project(':webrtc')

}

完成这些步骤后,你可以在 Android Studio 中同步项目,确保所有的 WebRTC 源码都被正确导入并能被项目识别。

3.2 编译和配置WebRTC库

3.2.1 编译环境的搭建

在 Android 上编译 WebRTC 源码需要配置编译环境,通常这包括安装和设置 JDK、Python、 depot_tools 和 NDK 等工具。

-

安装 Java Development Kit (JDK): 为了编译 Android 项目,你需要安装 JDK,并设置 JAVA_HOME 环境变量。

-

安装 Python: Python 是许多构建脚本所必需的,确保你的系统安装了 Python 2.7。

-

安装 depot_tools:

depot_tools包含了编译 WebRTC 所需的工具,如gclient,gn等。 -

安装 Android Native Development Kit (NDK): NDK 是编译 Android 原生代码的必要组件,你需要下载并配置 NDK 路径。

3.2.2 配置项目以支持WebRTC

在 Android Studio 中配置项目以支持 WebRTC 的编译,需要确保所有的编译依赖都已正确设置。这包括:

-

配置 CMakeLists.txt 或 Android.mk 文件来指定编译选项和依赖。

-

在

app/build.gradle中指定 native 依赖和配置编译脚本。 -

设置编译系统的环境变量和路径,确保

gclient和其他depot_tools脚本可以被正常调用。

一旦配置完成,开发者就可以启动编译过程了。在命令行中执行如下命令进行编译:

cd path_to_webrtc/src

gclient sync --with_branch_head

gn gen out/Default --args='is_debug=false use_ozone=true'

ninja -C out/Default

这段代码首先同步 WebRTC 源码,然后使用 GN (Generate Ninja) 生成构建文件,并最终通过 Ninja 构建工具构建 WebRTC。

通过这些步骤,WebRTC 库将被编译到一个 .aar 或 .so 文件中,这个文件随后可以被 Android Studio 识别并集成到你的项目中。

代码块逻辑分析与参数说明

gclient sync --with_branch_head

这一命令用于同步 WebRTC 源码, --with_branch_head 参数确保同步当前分支最新的更新。

gn gen out/Default --args='is_debug=false use_ozone=true'

gn gen 是一个用于生成 Ninja 构建文件的命令。参数 is_debug=false 表示生成非调试版本的构建, use_ozone=true 表示启用 ozone 平台,这是一个用于处理不同平台窗口事件的抽象层。

ninja -C out/Default

最后,使用 Ninja 的 -C 参数指定构建目录,并开始构建过程。在这个命令中, out/Default 表示构建输出的目录。

完成这些步骤之后,WebRTC 库将被编译并准备就绪,可以集成到你的 Android 应用中。

下一章节将继续探讨创建和配置 RTCPeerConnection,这是实现 WebRTC 实时通信的关键步骤。

4. 创建和配置RTCPeerConnection

4.1 RTCPeerConnection基础

4.1.1 实时通信协议概述

实时通信(Real-time Communication, RTC)协议是一系列允许网络应用或站点,在用户代理之间建立和维护实时通信会话的规则和编码标准。它允许在两个或多个参与方之间进行实时交换音频、视频或其他媒体数据。WebRTC(Web Real-Time Communication)是一个支持网页浏览器进行实时语音对话或视频对话的API,它为WebRTC提供了原生组件和协议,使得开发者能够在网页中实现音视频通信或点对点文件共享。

WebRTC协议定义了几个关键组件,包括媒体捕获、网络传输、信号交换和编解码器。其中,RTCPeerConnection是WebRTC协议中一个至关重要的组件,它负责建立和管理网络连接,并协调双方的音视频数据交换。

4.1.2 RTCPeerConnection的角色和功能

RTCPeerConnection(PC)对象是WebRTC协议的中心组件,提供与另一端用户建立连接以及交换音视频和数据的接口。它允许应用程序收集本地媒体流、建立网络连接、协商编解码器和数据通道,以及监控连接状态和性能。

- 连接建立 :PC负责完成信令协议交换过程,与远程端点建立连接。它通过交换称为offer和answer的信息,来协商连接参数和媒体能力。

- 媒体处理 :它还管理媒体流的传输,包括音频、视频和数据通道的实时传输。

- 错误处理和监控 :PC会监控连接的稳定性,处理网络波动和媒体质量的变化,并提供相关的错误处理机制。

4.2 RTCPeerConnection的使用实践

4.2.1 创建RTCPeerConnection实例

创建一个RTCPeerConnection实例是一个关键步骤,它需要传递一些配置参数来初始化连接对象。例如,你需要指定ICEServers,这是WebRTC用来中继信令和媒体数据的服务器列表。

const pc = new RTCPeerConnection({iceServers: [{ urls: 'stun:stun.l.google.com:19302' }]

});

在上面的代码中,我们创建了一个简单的RTCPeerConnection实例,并指定了一个STUN服务器。STUN(Session Traversal Utilities for NAT)服务器用于帮助处于NAT(网络地址转换)或防火墙后面的用户建立连接。

4.2.2 配置和管理连接参数

一旦创建了RTCPeerConnection实例,就需要配置相关参数,包括媒体轨道(track)和传输候选者(candidate)。

// 添加本地媒体轨道到连接

navigator.mediaDevices.getUserMedia({video: true, audio: true}).then((stream) => {stream.getTracks().forEach(track => pc.addTrack(track, stream));}).catch(error => console.error("Error adding media track", error));// 处理连接的 ICE 候选者

pc.onicecandidate = event => {if (event.candidate) {sendToRemote({ type: 'candidate', candidate: event.candidate });}

};

以上代码展示了如何从媒体设备获取媒体流,并将音视频轨道添加到RTCPeerConnection中。另外,我们还监听了icecandidate事件,当有新的ICE候选者出现时,会发送给远程端点,这是实现P2P连接的关键步骤。

至此,RTCPeerConnection已成功创建并配置,可以开始进行连接的协商工作。整个过程是实时的,一旦建立连接,媒体数据就可以实时传输了。

5. 本地与远程媒体流的处理

在WebRTC应用中,处理本地与远程的媒体流是实现音视频通信的核心。这包括对音视频设备的访问权限设置、媒体流的捕获和封装同步、远程流的接收和渲染。本章将深入探讨如何高效处理媒体流以确保高质量的通信体验。

5.1 媒体流的捕获与处理

媒体流的捕获与处理是实现WebRTC音视频通信的基础。首先需要确保应用程序能够访问本地音视频设备,并对捕获到的媒体流进行封装与同步处理。

5.1.1 音视频设备的访问权限

在WebRTC应用中,访问用户的音视频设备需要取得用户的明确授权。通常情况下,浏览器会通过弹窗的方式询问用户是否同意访问设备。开发者需要确保在用户同意授权之前,不要尝试访问任何媒体设备。

在JavaScript中,可以通过MediaDevices接口获取用户的媒体设备信息,代码示例如下:

navigator.mediaDevices.getUserMedia({ audio: true, video: true }).then(stream => {// 用户授权成功,处理媒体流const localVideo = document.querySelector('video');localVideo.srcObject = stream;}).catch(error => {// 用户授权失败或有其他错误,处理异常console.error('获取媒体设备失败', error);});

在Android平台,获取设备权限的过程则更为复杂,涉及到运行时权限请求。Android 6.0以上版本需要在运行时请求权限,代码示例如下:

if (ContextCompat.checkSelfPermission(context, Manifest.permission.CAMERA)!= PackageManager.PERMISSION_GRANTED|| ContextCompat.checkSelfPermission(context, Manifest.permission.RECORD_AUDIO)!= PackageManager.PERMISSION_GRANTED) {ActivityCompat.requestPermissions(activity, new String[] {Manifest.permission.CAMERA,Manifest.permission.RECORD_AUDIO}, REQUEST_CODE);

}

5.1.2 媒体流的封装和同步

获取到媒体流后,WebRTC会使用一系列的封装格式将原始音视频数据打包,以便于在不同的网络环境下传输。媒体流的同步是指确保音视频数据在接收端能够以正确的时序播放,避免音画不同步的情况。

在WebRTC中,通常使用 RTP (Real-time Transport Protocol) 包来封装音视频数据,并通过RTCP (Real-time Control Protocol) 来同步媒体流。开发者无需关心RTP和RTCP的底层实现细节,因为WebRTC已经内置了这些机制。

5.2 远程媒体流的接收与渲染

在WebRTC通信过程中,除了处理本地的媒体流,还需接收和渲染远程媒体流。这一过程涉及到网络传输、解码和最终在用户界面上显示远程音视频。

5.2.1 远程音视频流的接收过程

远程音视频流通过RTP协议传输到本地。接收端首先需要初始化一个 RTCPeerConnection 对象,代码示例如下:

const pc = new RTCPeerConnection(configuration);// 添加一个接收远程媒体流的track

pc.ontrack = function(event) {const remoteVideo = document.getElementById('remoteVideo');remoteVideo.srcObject = event.streams[0];

};

一旦网络连接建立,远程音视频数据包就会通过 RTCPeerConnection 发送到本地,并通过ontrack事件触发媒体流的接收。

5.2.2 音视频流的渲染技术详解

在Web应用中,通常使用 <video> 元素来显示视频流。通过设置video元素的srcObject属性为媒体流对象,浏览器会自动处理视频的渲染工作。渲染技术的关键在于正确地同步和处理音视频数据,保证播放的流畅性和同步性。

在Android中,远程媒体流的渲染涉及到使用SurfaceView或TextureView等组件。以SurfaceView为例,代码示例如下:

// 创建SurfaceView实例

SurfaceView surfaceView = new SurfaceView(this);

surfaceView.getHolder().addCallback(new SurfaceHolder.Callback() {@Overridepublic void surfaceCreated(SurfaceHolder holder) {// 绑定渲染器到SurfaceViewlocalRenderer.init(pc.getRemoteStreams()[0], holder);}@Overridepublic void surfaceChanged(SurfaceHolder holder, int format, int width, int height) {// Surface尺寸变化时的处理}@Overridepublic void surfaceDestroyed(SurfaceHolder holder) {// Surface被销毁时的清理工作}

});

在上述过程中, localRenderer.init 方法负责将远程媒体流绑定到SurfaceView上进行渲染。

本章通过深入探讨媒体流的捕获、封装、同步以及远程媒体流的接收与渲染,为WebRTC应用提供了高效处理音视频通信的理论基础和实践指南。下一章将介绍WebRTC信令协议的交换流程,这是实现WebRTC通信的另一个关键环节。

6. WebRTC的信令协议交换流程

信令协议是WebRTC通信中的关键组成部分,它负责在通信双方之间交换必要的控制信息,以便建立和管理连接。在本章节中,我们将深入探讨信令协议的作用和分类,以及如何实现信令交换的过程。

6.1 信令协议的作用与分类

6.1.1 信令协议的基本概念

在WebRTC中,信令协议是客户端之间交换控制信息的机制,这包括但不限于:会话描述、候选传输地址、会话参数协商等。信令不是WebRTC标准的一部分,这意味着开发者可以使用任何传输机制来传递这些信令消息,只要通信双方都遵循同样的协议。

6.1.2 常见的信令协议对比

传统的信令协议如SIP(Session Initiation Protocol)和H.323在早期视频会议和VoIP应用中广泛使用。然而,WebRTC通常采用基于文本的协议,如SCTP(Stream Control Transmission Protocol)或ICE(Interactive Connectivity Establishment),特别是ICE协议,它为WebRTC提供了NAT穿透和候选地址交换的能力。

6.2 实现信令交换的过程

6.2.1 信令交换的步骤和协议设计

信令交换过程通常包括以下步骤:

- 用户设备(User Agent)启动并注册到信令服务器。

- 用户设备发起会话请求并等待响应。

- 信令服务器转发会话请求给另一用户设备。

- 对方设备接受或拒绝会话请求。

- 会话建立后,双方设备交换ICE候选来建立连接。

- 连接建立后,开始媒体流的传输。

在设计信令协议时,需要考虑以下关键点:

- 信令消息格式:通常为JSON或XML格式,方便阅读和解析。

- 信令服务器选择:可以使用现有的解决方案如Turnpike或自行搭建。

- 安全性:确保信令传输过程加密,防止监听和中间人攻击。

6.2.2 信令服务器的搭建与应用

搭建信令服务器涉及到几个核心组件:

- 用户管理 :用于跟踪在线用户并维护用户状态。

- 信令逻辑处理 :处理信令交换的业务逻辑,如会话建立、候选地址交换等。

- 消息传输 :实际传输信令消息的机制,通常采用WebSocket或HTTP长轮询。

以WebSocket为例,其基本使用流程如下:

// JavaScript WebSocket客户端代码

var signalingSocket = new WebSocket('ws://signaling-server.example.com');signalingSocket.onopen = function(event) {console.log('Connected to signaling server.');// 发送会话请求等初始化信令消息

};signalingSocket.onmessage = function(event) {console.log('Received message: ' + event.data);// 处理从信令服务器接收到的消息

};signalingSocket.onclose = function(event) {console.log('Disconnected from server.');// 处理断开连接的情况

};

信令服务器的搭建需要精心规划,以确保其稳定性和可扩展性,特别是在大型应用中,它需要能够处理大量并发连接。

在搭建和应用信令服务器时,还应考虑包括认证、授权以及服务质量(QoS)等因素,确保系统的健壮性和安全性。通过精心设计的信令协议和服务器,WebRTC通信可以更加流畅和可靠。

本文还有配套的精品资源,点击获取

简介:WebRTC是一个开源项目,旨在实现浏览器间无需插件的实时通信,包括音频、视频通话及数据共享。在Android平台上,其实施涉及使用JNI接口进行Java与C/C++代码的交互。本压缩包内容预计涵盖了WebRTC的架构、JNI原理、库集成、连接建立、音视频流处理、信令协议、渲染、错误处理、性能优化以及内存管理等关键知识点,旨在指导开发者在Android应用中实现高质量实时通信功能。

本文还有配套的精品资源,点击获取