我自己的原文哦~ https://blog.51cto.com/whaosoft/13948969

#用Veo 3+Suno做了个AI Rapper

吊打音乐节上的流量明星

太疯狂了!AI生成的嘻哈歌手唱Rap以假乱真,网友直呼「看不出破绽」。

来来来,眼尖的朋友请告诉我,下面这个嘻哈歌手唱 rap 的视频到底是真实的,还是 AI 生成的?

,时长00:30

我可以 100% 肯定地说,此为 AI 的手笔。你猜对了吗?

三天前,X 博主 @blizaine 使用 Google Flow Veo3 和 Suno 4.5 制作了这一视频。画面和开场声音是 Veo3 生成的,歌曲和歌词则用 了 Suno 4.5。

,时长01:53

由于效果过于逼真,网友直呼「太疯狂」,甚至还让摇滚老炮回想起了当年的舞台时光。

看样子,Veo 3 刚揭开流量明星的遮羞布,这下子又要让歌手瑟瑟发抖了。

循着这个方向在 X 上逛了一圈,发现不少网友热衷于用 Veo 3 生成演唱会视频,而且一个比一个自然。

比如这个另类摇滚迷幻乐队在一家小酒吧的演出片段。主唱站在麦克风前,边弹吉他边演唱成名曲中的副歌部分,情绪饱满但不激烈;贝斯手、吉他手和鼓手沉醉其中,身体随节奏摇摆着,几乎找不出什么 bug。

,时长00:08

Prompt: Mid 90s footage of an alternative rock shoegaze band playing in a small dive bar. The band consists of a lead singer guitarist, a bassist, a drummer, and another guitarist. They are singing the soaring chorus of their biggest hit.

再比如,下面这个妆容怪诞的钢琴家演奏动作自然流畅,手指与琴键接触的力度、节奏与画面中的旋律同步,口型也对得严丝合缝。身后交响乐团不同乐器组的演奏姿态各具特色,指挥家起伏的手势也不机械重复。

更妙的是,Veo 3 还能找准时机切换镜头,细节之丰富几可乱真。

,时长00:10

Prompt: Early 2000s footage of an australian goth pianist making a whimsical song about God in front of an orchestra.

还有这个混乱的摇滚音乐会,三名乐队成员完全失控:主唱挥舞着鼓槌冲着观众嘶吼,吉他手头发凌乱猛拨琴弦,身后的鼓手则疯狂击打鼓面。唯一的瑕疵就是那莫名飞起的镲,说实话有点出戏。

,时长00:08

Prompt:A chaotic grunge rock concert circa 1995 captured on an old VHS camcorder from someone in the audience. The band members are acting erratically, throwing guitars and smashing drums.

接下来,我们也来复刻一个,看看 AI 能否拯救犹如一潭死水的华语乐坛。

这第一步就是生成音乐。

前段时间一个名为「梁正尚能饭」的博主火了。他凭借「粤语 + 古诗 + 摇滚」的独特风格,创作出《将进酒》《木兰辞》《王维说》《春归何处》等音乐作品,在各大平台播放量超百万。

,时长01:12

视频来自博主「梁正尚能饭」

我们就用 Suno3.5 和豆包尝试一下。

Suno 算是资深的 AI 音乐生成模型,当初一问世就被外界称为「音乐界的 ChatGPT」,经过一年多的技术迭代,Suno 已更新至 4.5 版本。

那么我们为何选择 Suno3.5 而不是最新的 4.5 版本?原因只有一个:抠。4.5 版本要花钱升级会员,3.5 版本可免费体验,只需点击「Create」,上传歌词输入风格,它就能秒出 2 首歌。

Suno 版的《木兰辞》有嘻哈那个味了,不过咬字会在粤语和普通话之间来回横跳,女声吟唱部分还会掺杂明显的电音,听起来不是很自然。

Suno版《木兰辞》,1分钟

Suno版《木兰辞》,3分钟

与 Suno 的专精不同,豆包就像一个啥都能装的菜篮子,涵盖 AI 搜索、视频生成、音乐生成、AI 编程等 15 项功能。它的音乐生成功能可直接套模版,或让 AI 自动写歌词,或自己输入歌词,再选择音乐风格、情绪、音色即可。

相比于 Suno,豆包的咬字更清晰,尤其是「鞍鞯」、「辔头」等生僻字,豆包都能读准,但旋律相对来说比较单一。

豆包版《木兰辞》,1分钟

豆包还有一个优势,就是可以直接通过对话的方式,让它润色歌词以更好地配合嘻哈音乐风格。

经过改编后的《木兰辞》听起来就顺耳多了:

豆包改编《木兰辞》,1分钟

第二步就是用 Flow 中的 Veo3 生成画面和开场白。

Flow 是谷歌打造的一站式 AI 电影制作平台,用户可以通过输入文本提示或上传图像,让 Flow 生成完整的电影场景或短片,同时它内置一整套视频制作工具,包括摄像机控制、场景构建器和素材管理器等。

Flow 链接:https://labs.google/flow/about

要想生成以假乱真的演唱会效果,提示词是关键。经过多次调试,我们搞了个像样的:

A high-energy hip-hop concert scene. A stunningly handsome Chinese hip-hop artist, early 20s, wearing a stylish streetwear outfit — oversized jacket, graphic tee, chunky sneakers, silver chains, and a snapback cap. He has sharp facial features, confident expression, and a charismatic stage presence. The confident Chinese hip-hop artist stands center stage , holding a microphone. As the intro music plays, he looks directly into the camera and says, "What's up, everyone? Long time no see, haha." The camera then pans smoothly from the rapper to the excited audience — people are cheering, waving their hands, and jumping to the beat. Then the camera moves behind the rapper as he turns to face the crowd and begins his rap performance. The atmosphere is electric, with lights flashing and the crowd fully engaged.

来看看实际生成效果:

,时长00:08

由于 flow 每次只能生成 8 秒视频,要想延长时长,只需点击「Add to scene」,选择「Extending」,再输入提示词:The hip-hop artist is facing the audience while rapping, with their back to the camera, and the crowd is waving and dancing to the rhythm.

多次重复此操作,就能得到一段自然流畅的嘻哈歌手演唱会视频。

最后,再用剪映将视频和音乐片段拼合在一起,大功告成!

上最终视频效果:

,时长00:51

感兴趣的朋友也去试试吧!

参考链接:

https://x.com/rpnickson/status/1925079953206608257

https://x.com/bitfalls/status/1925072790593405065

https://x.com/TheJasonRink/status/1925372569714090429

https://x.com/nearcyan/status/1924966995910631899

https://x.com/blizaine/status/1926757581021684215

#Linear-MoE

线性注意力遇上混合专家的开源实践

近年来随着大语言模型的爆火,旨在取代 Transformer 的高效模型架构及其预训练成为大模型领域的研究热点,主要包括线性序列建模(如 Linear Attention、SSM、Linear RNN 等)和混合专家(Mixture-of-Experts, MoE)两部分。这两部分分别都有了长足的进步,但两者的结合却鲜少有人研究,两者结合后的 Linear-MoE 架构开源实现更是完全缺失。

值得一提的是,近期广受好评的 MiniMax-01 模型(使用 Lightning Attention-MoE)和腾讯混元 TurboS 模型(使用 Mamba2-MoE)均属于 Linear-MoE 架构。

来自上海人工智能实验室团队的最新成果 Linear-MoE,首次系统性地实现了线性序列建模与 MoE 的高效结合,并开源了完整的技术框架,包括 Modeling 和 Training 两大部分,并支持层间混合架构。为下一代基础模型架构的研发提供了有价值的工具和经验。

论文标题:Linear-MoE: Linear Sequence Modeling Meets Mixture-of-Experts

论文地址:https://arxiv.org/abs/2503.05447

项目地址:https://github.com/OpenSparseLLMs/Linear-MoE

线性序列建模的崛起

过去两年,线性序列建模技术取得了显著进展,其核心优势在于线性时间复杂度的训练和恒定内存占用的推理。

这类模型主要分为三大类:线性注意力(Linear Attention)、状态空间模型(SSM)和线性 RNN(Linear RNN),代表性工作包括 Lightning Attention、GLA、Mamba2、RWKV 等。

已有研究工作表明,这些模型实际上可以通过统一的递归形式进行表达,如下表所示。这也反映出,尽管三类方法分别出自不同的技术流派,但已逐渐收敛至统一的表达形式。

混合专家 MoE 成为事实标准

另外一方面,从国际上的 GPT-4 系列、Gemini 系列、Claude 系列到国内的 DeepSeek 系列、Qwen 系列、腾讯混元 LLM、字节豆包、MiniMax-01、Moonshot-Kimi 等,都在步伐一致地 All in MoE。其重要性不言而喻,本文不做过多展开。

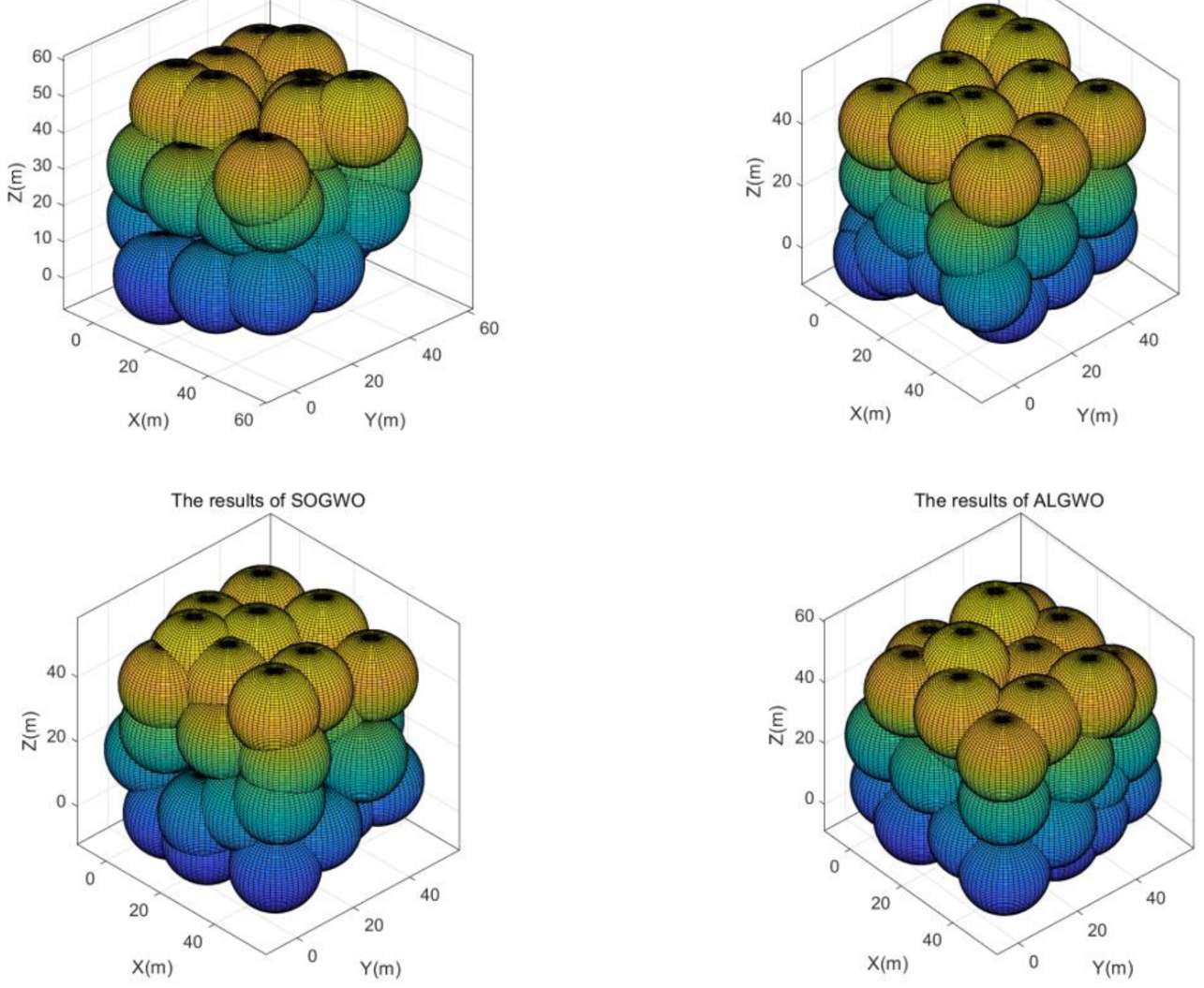

Linear-MoE:模型架构与高效训练

Linear-MoE 的核心贡献在于构建了一个从 Modeling 到 Training 的完整系统,支持线性序列建模层与 MoE 层的灵活组合,同时兼容传统的 Softmax Attention Transformer 层,支持形成混合架构。其设计亮点包括:

- 模块化架构:

- LSM 层(线性序列建模层):支持各类线性序列建模方法(如 Lightning Attention、Gated-DeltaNet、Mamba2 等)。

- MoE 层:集成多种 MoE 实现(如 Qwen-MoE、DeepSeek-MoE、Mixtral-MoE),以及一种 Dense 实现(Llama3)。

- 高效训练技术:

- 基于 Megatron-Core 框架开发,确保系统稳定性和可扩展性。

- 支持张量并行、流水线并行、专家并行、LASP(线性注意力序列并行)和 MegaBlocks 等优化技术,显著提升训练效率。

实验验证

大规模实验验证了 Linear-MoE 的优越性:

- 训练稳定:混合模型(线性 + Softmax Attention)比纯线性模型表现出更稳定的训练曲线。

- 训练效率:借助专家并行和 MegaBlocks,系统在超大参数规模下仍保持高吞吐量。

- 推理优势:线性模型的推理速度比传统架构快 2-5 倍,内存占用降低 50% 以上。

- 性能扩展:在不同规模的基准测试中,Linear-MoE 展现出良好的性能线性增长。

开源生态与未来展望

目前 Linear-MoE 已全面开源,支持多种主流的线性序列建模方法和 MoE 实现。这一工作不仅填补了线性建模与 MoE 结合的技术空白,还为社区提供了可复现的高效训练方案。未来将进一步探索 Linear-MoE 在长上下文理解、Vision-Language 模型架构中的应用潜力。

#NoCode

美团开放AI代码工具,零代码实现全栈能力,项目负责人揭秘架构细节

一句话,呈所想。

谁都没有想到,如此实用的 AI 代码生成工具,竟是出自美团。

上周,有媒体曝出了美团的 AI 零代码工具 NoCode,这是一款无需编程背景和经验,仅通过自然语言和对话形式即可快速生成应用的工具。

顾名思义,NoCode 可帮助很多人以「零代码」的方式创建个人提效工具、产品原型、可交互页面等。它不仅能生成代码,还可以进行实时预览,局部修改并一键部署,大幅降低了开发的门槛,可以帮助更多人释放创意。

而且,NoCode 是完全免费的,用美团 App 或微信扫码就能登录。

产品链接:https://nocode.cn/

NoCode 是美团开放 AI 生态的最新实践,旨在通过免费开放自身积累的 AI 技术能力,助力中小商户实现 IT 化与数字化升级,同时让更多用户体验 AI 技术带来的效率提升与创新乐趣。在公司内部,人们已经利用它构建出了从网站页面到效率工具、数据分析再到简单游戏等大量不同种类的应用。

虽然目前还未正式发布,不过我们已经在社交网络上看到了一些使用 NoCode 构建产品的案例。

比如使用 NoCode 生成的五子棋游戏,落子时有视觉反馈效果,可以进行人机对战:

项目链接:https://nocode.host/6281d/wqtkm8blcfm3ovhk

一个热点美食追踪的网站,详细区分了品类、门店详情等页面,包含门店覆盖热力图:

项目链接:https://nocode.host/3a6ad/m3dbk1k0j4ksr99s

商家数字运营系统,包含运营数据、订单管理、库存和分析等多个项目:

项目链接:https://nocode.host/6281d/1o5c1i2i9bdacm06

也有越来越多的人分享了自己的使用心得。简单说来,NoCode 具备以下一些特点:

- 自然语言编程:使用自然语言描述想法,NoCode 就能自动解读并转化为完整功能,无需编程经验即可生成可用能力。在用户输入指令后,NoCode 会对指令进行拓展、优化,还可以进行一键优化。

- 实时预览效果:NoCode 能根据对话内容即时渲染、呈现结果,可实时查看每次对话后的实际效果。

- 局部定位修改:使用 Visual Edit 功能,可针对定位内容进行局部修改及完善;同时支持版本间对比、回退,保障每一步都「有迹可循」。

- 一键部署分享:应用构建完成后,代码将自动上传到仓库,即可立即部署并与其他人分享,点击即可直接访问链接查看作品,同时后方会展示复制按钮,用户也可以选择一键复制链接后,分享给其他人查看。

NoCode 由美团研发质量与效率团队研发,该团队属于美团基础研发平台。赶在 NoCode 正式上线之前,美团基础研发平台工程效率负责人、美团技术委员会委员程大同,与美团基础研发平台智能开发工具负责人俞超接受了我们的采访。他们就 NoCode 的产品形态,技术架构和应用能力对我们进行了详细介绍。

在 NoCode 的开发者们看来,这款工具就像是一个全栈工程师,它可以在不同的工作流程中提升生产力。从技术架构上看,NoCode 的背后是多个 AI 模型,又针对多项业务进行了专门的训练与调优。在美团内部的应用中,NoCode 已经展现出了极强的实用性。或许用不了多久,我们的编程范式就会因为这些 AI 工具而迎来翻天覆地的变革。

这是我们第一次能够了解美团这一神秘产品的技术细节,让我们看看他们是怎么说的。

部分文字进行了不改变原意的改写。

有关新工具的发布

1、请简要介绍一下美团即将发布的 AI 零代码工具 NoCode。

程大同:某种程度上,你可以把 NoCode 理解成为一个全栈的 AI 工程师,它拥有完整的环境,一个能够直接运行程序的沙箱。

即使你没有技术背景,也能生成小工具、网页前端、产品原型、小程序、小游戏等等。你只需要把需求提给 AI,它就能帮你 work,不需要麻烦开发团队,也不需要考虑安装和部署。在美团内部,很多完全没有编程经验的同学经过与 AI 的多轮对话构建起了具有实际生产力的应用,它们虽然没有专业开发者构建的那样复杂,但已经是完全能用的。

我认为它意味着创造力:你在自己的专业领域里有了 idea,NoCode 就可能提供帮助,不过得有一些耐心。在美团内部,一些用 NoCode 做出的优秀实践案例会与 AI 进行超过一百轮的对话。

2、我们知道,长期以来美团一直在零售场景中探索新技术的应用,本次提出的产品则面向代码开发,可以说是开拓到了一个新的方向。开放 NoCode 是出于怎样的考量?

程大同:我们认为目前已经到了这个阶段。我们的产品在内部使用效果很好,但大家的想象力其实也有穷尽的时候。如果把 NoCode 开放到更广阔的场景下,让更多人来使用,可能会带来更多的可能性,不仅对于我们,对于整个行业也能产生价值。

一直以来美团聚焦的方向是零售加科技,除了自动配送车、无人机等相对硬核的技术以外,其实在 AI 模型等软核技术上我们的迭代也很快。

相比市面上一些 AI 代码生成工具,我觉得我们开放出来是为了让大家能够参与 AI 这件事。我们会在零售加科技的方向上持续投入,而且有一些还不错的进展。

3、NoCode 的能力如何?是否有代码基准评测上的成绩可以分享?

程大同:我们没有对外去打榜。在内部测试时可以看到 code agent 在 SWE-Bench(注:基于 GitHub 的大模型能力评估数据集)上跑分是比较高的,Verified 项目上行业 SOTA 水平在微调后分数在 65% 左右,我们在没有微调的情况下分数能达到 50% 以上,差不多在 Top5 的水平。

我们更加关注的是实际的生成效果。在内部实践中可以看到,NoCode 的使用率很高,非技术人员用户是技术人员数量的三倍。

在 AI 代码生成这件事情上,我们有很多的实战经验。相比创业公司,我们已经拥有了相当数量的「客户」—— 美团的一线 BD 和销售,甚至一些 B 端商户,他们都已经用得很娴熟了。另外,我们在智能体上的经验和积累也推动了技术栈的构建。

我们希望 AI 技术的应用能够更加平民化,从需求、debug 到环境部署更加自动化,可以实现应用构建的从零到一。

NoCode、Dev Mode 背后的技术

4、请简要介绍一下 NoCode 的大致框架。支撑 NoCode 的基础大模型是怎样的?

俞超:NoCode 是一个大模型智能体产品,围绕基础设施、runtime sandbox 和大模型构建,多个 AI 模型进行协作。

高清图片链接:https://nocode.host/6281d/lp1779rwn2cpl5lms

大体来说,NoCode 整体架构分为三层,分别为基础设施和模型层、runtime sandbox 和 baas 层、Agent 应用层。基础设施层面,包括 K8S 大规模集群调度算力,分布式文件系统提供代码存储能力,Ingress 网关实现网站路由,部署系统提供部署能力,图片检索服务适配网页图片等。再往上是 runtime sandbox 层,基于特定技术框架(如 react、云 IDE)构建镜像,通过池化技术加速冷启,热更新实现页面实时渲染。最后是 Agent 应用架构,一个大尺寸主推理模型,外加一些垂直场景的小模型,构建包括 plan、context 管理、code 场景下的 tool set 在内的 code agent。

切换到 Dev Mode 之后,用户视图转变为完整的 Agentic IDE — CatPaw,适用于专业用户进行更精细化控制。CatPaw 于 2022 年 11 月启动,当时名字叫做 MCopilot,后来我们认为 Copilot 这个词不太好,改名 CatPaw,目前在美团内部研发的渗透率超过 90%,这部分技术架构,细节更为复杂,后续有机会单独分享。

高清图片链接:https://nocode.host/6281d/snpwps0uq1nje77bg

5、在这其中,美团的工程团队实现了哪些创新,其核心技术在于哪些方面(如模型训练和调优、数据集等)?

俞超:我们专门构建了一个 7B 参数的 apply 专用模型,用来解决大尺寸模型生成慢的问题。这个专用模型基于美团自研代码基座,通过美团内部真实代码数据及部分合成数据进行训练,它的任务是根据源文件 + 修改方案进行全量代码生成。我们离线评估它的生成指标后在线上进行 A/B 实验,衡量整个产品最终的端到端运行效果,不断进行优化迭代,目前已经迭代了十几个版本。

Apply 专用模型,我们有一个专门的优化团队,不断优化算法和工程,可以在不损失精度的情况下实现每秒 2000 token 的推理,而且使用的还不是业界最先进的 GPU 卡,如果用大尺寸模型去输出代码的话,生成速度可能只能达到每秒几十 token。

实际上,除了 Apply 模型之外,我们还自行训练了很多小模型,比如最早期的代码补全模型,Embedding 模型,Rerank 模型等,它们在架构中发挥的效果就是在不降低指标的前提下提升推理速度,可以做到又快又好。相对而言,使用大尺寸模型就显得有些浪费 token。

对于模型迭代来说,数据的质量和实验迭代的速度至关重要。我们基于美团内部数据以及合成数据构建训练集和评测集,并加入人工校对审核。为了提升垂直场景的效果,我们进行了很多离线评测和线上 A/B 实验。我们不仅对小模型进行垂直评测,也对整个产品端到端的链路进行评测。我们的目标并不是 Benchmark 打榜,而是针对美团生态的开发者、非开发者需求,持续进行微调。

6、选择对外界进行开放,就意味着可能的大规模应用。在产品体验上,美团对 NoCode 实现了哪些优化?

俞超:极致的技术优化带来极致的产品体验。比如说代码实时渲染,它的背后其实需要调用服务器的算力。最好的情况就是像本地开发一样,改完代码立马就可以看到输出效果,然后我就可以进行快速迭代。

在对话过程中,每一个 NoCode 作品背后都有一个 runtime sandbox ,提前安装好环境、依赖、ide 等,能够快速的去帮你去把代码实时更新到容器里面,热更新后快速看到效果。

当然,这也会带来另一个问题,容器资源的开销是很大的。我们专门设计了回收容器的机制,结合无状态设计及容器池化,让你在下次打开容器时可以实现秒级启动。

为了对抗大模型输出的不稳定性,我们还设计了 Visual Edit。你可以在网页上选中部分区域进行局部修改,比如改个文字,改个背景图,不需要依赖大模型就可以改,既快又准。

每一次对话后,我们都会默认生成一个带有页面截图的版本,通过浏览带图的历史,你可以很容易回顾每次改动,从而方便切换版本或者一键回退。

如果你使用过 NoCode,你应该会注意到,NoCode 生成的网页中的图片,是非常符合生成网页上下文这个场景的的,这里其实涉及到图片搜索,我们也有团队专项优化这个服务。具体来说,我们会结合网页的上下文,通过关键字、语义化去进行图片检索后放置到网页中,合适的图片对于网页整体的美感非常重要。

最后,为了适配更专业用户的诉求,解决非专业用户和专业用户间的协同,我们设计了 Dev Mode。Dev Mode 几乎是把美团内部更专业版本的 AI Native IDE 搬到浏览器,以实现更加精细化的控制。当非专业用户使用 NoCode 经过一些迭代之后,如果发现改不动了,可以直接 share 链接给到专业用户,他切换到 Dev Mode 进行快速迭代,非专业用户刷新就能看到实时效果,实现协同创作。

这里只是举了几个例子,我们还有很多优化在路上,也欢迎大家在社区( feedback.nocode.cn)中给我们多多提意见。

7、如何让 AI 更准确地遵循人类给出的指令,写出好用的代码,美团的工程师们在构建 NoCode 的过程中克服了哪些挑战?

俞超:遵循指令的能力主要考验模型推理能力,另外也需要提供足够多无歧义的上下文给到模型,在 NoCode 这个场景,还需要选择模型输出效果最佳的前端技术框架。对于每个模型我们都会花费大量时间调整 system prompt,如模型是否足够主动,使用的代码规范,工具的描述是否精准,格式是否最优等。我们后续还会支持用户自定义的一些 system prompt,你可以制定一些以符合你的个人习惯。前端技术框架层面,我们选择了 react+tailwind+shadcn+vite 的组合。此外,模型输出的代码有时会发生编译不通过的情况,我们也会把编译器的报错自动给到模型进行修复,直到能成功渲染为止,这里的修复策略我们也会有团队专项优化迭代。

8、人们在真实生产环境中构建项目时,通常会需要大模型工具保持连贯性,拥有长期记忆能力,NoCode 是否拥有这样的机制,它是如何做到的?

俞超:如果代码文件不多,你可以直接把所有代码塞到一个窗口中,超过模型的上下文窗口之后,我们一方面会通过 RAG 来实现知识增强,另一方面也会给模型提供一些工具来进行代码检索。针对 RAG 场景我们专门训练了 search 系列模型。比如 embedding 模型如何向量化数据集,rerank 模型进行重排等等。这个里面的每项任务、每一个细节都进行了专门的训练和评估,在单点上做到极致,然后再把它串联起来,组合实验。随着模型的推理能力增强,将更多的 tool 直接训到模型中之后,模型可以基于当前的上下文动态 plan 后续的 action,比如通过关键字来检索代码仓库,或者列出某个目录的目录树结构,从而增强后续的推理。

AI 让人人都能写好应用

9、我们知道,使用 AI 代码工具经常需要多次生成、调整才能输出实用代码。对于非专业人员来说,我们如何知道 AI 生成的代码是否管用?NoCode 是如何帮助人们对代码进行迭代优化的?

俞超:你需要进行不断的迭代,先把你脑子里的想法输入进去,看看它会出来什么样的结果。我们很多内部员工在刚开始使用 NoCode 时在经验上会稍显不足,生成出来的结果完全不符合预期。但是他们慢慢的在对话过程中,逐渐摸索出 AI 的脾气到底是什么样子的。在我看来每一个模型都有他自己的脾气,就是「模性」。在用的过程中你会发现什么样的指令,对它来说这个最稳定、最容易遵循的。逐渐形成自己的方法经验。

这个学习的速度应该是非常快的,因为不需要你去学很多枯燥的代码,了解其中的语法结构和规则。只需要改进你的描述,然后调整模型输出的结果。

在使用 NoCode 的过程中,当你发现模型输出不符合预期,在页面右侧的可视化版本历史中,点下鼠标就能轻松实现回退,回退后可以补充更多的信息或者换一种描述,让 NoCode 帮你生成新版本。

我们也会放出一些实践案例,完整地呈现每个作品的对话过程,此外还会有社区方便大家分享经验。我相信这样一款产品,它的学习门槛相比传统代码要低很多,可能你一天时间就能够摸索出来高效实现的方法。

10、使用 NoCode 写应用,工作流程会发生怎样的变化?

程大同:主要看使用者的角色。

对于产品经理来说,我以前提一个需求,可能需要找一个研发做出 demo,然后再过设计,做好之后再 review,可能一两周就过去了。现在我用 AI 工具就可以直接做出原型,开发如果觉得 OK 的话,可以在原型上直接修改,进行更深层的开发。如果动手能力强的话甚至可以自己使用 AI 工具来进一步修改。

很多我们一线的业务人员,面对一些紧急的小项目都可以这样快速构建,实现业务的闭环。

第三类是全栈能力的补全。假如我是写后端的,需要自己写一个前端,就可以用 NoCode 来帮忙。我作为一个开发工程师,它拓展了我的技术栈。

还有就是数据分析人员,他们以前需要大量使用 Excel,还需要懂 VB 编程。现在通过自然语言直接进行分析,如何填写数据,如何生成图表,都可以用 AI 来帮忙。

可以说每个人都在发生变化,整个链条里面工作流程、协作模式。我们做过一些调研,不论是否懂编程,工作方式都能发生变化。

11、在美团内部,人们应用 NoCode 已经带来了哪些效率提升?是否有一些更具体的例子。

程大同:在美团,有很多对接出海业务的员工会使用 NoCode 构建学习外语的软件,他们会按照个人学习习惯和需要来设计产品,引入第三方工具,或是协同学习,还有人会用 NoCode 来写抽奖程序。

我们的 HR 团队、行政团队也发生了变化。比如像 HR 团队去年过年需要发的红包,就是有些同学拿 NoCode 做的,经过研发的一些辅助,他们让公司的 10 万人拿到了红包。他们完成这项任务只用了一到两个工作日。

在数据团队中,以前进行数据分析需要依赖专业的软件,其中有很多工具套到底层的大数据仓库。但这样的工具是通用化的,对于定制化需求,你就需要向专用软件的团队提需求。现在人们不需要提需求了,只需要用 NoCode 做一个端上的数据分析工具,基本只需要三四十轮的对话,一个早上的时间。

有结构化的数据,有 NoCode,就能很快把我的需求实现出来。

12、美团目前每天提交的代码有百分之多少是由 AI 代码生成工具构建的,使用自然语言创建出可用于生产的应用,可以把开发时间缩短多久?

程大同:在今年第一季度财报上有提到,美团使用 AI 生成代码占比达到了 27%。目前这个数字还在提升,目前每周使用我们内部的 AI 工具,生成代码增量占仓库增量的 50%。第一季度的统计数据还没有加入 NoCode。

我们认为(使用 AI 开发工具)在内部能带来 30-50% 的提效。

项目背景、未来展望

13、NoCode 这个项目是从何而来的?能否简要介绍一下它背后的历程和研发团队。

程大同:我们团队做 AI Coding 的 code agent 的时间有两年半,但是 NoCode 项目的启动到今天其实只经历了 6 个月。它是从 2024 年 10 月开始的,最开始是公司内部的一个黑客松项目,只有三个同学,现在核心技术人员也不到十个人。

在去年 11 月,项目开始后一个多月,我们突然发现这个项目能火,于是去快速地 ramp up 这个项目。

当然这里面肯定是有相互的依赖和认知迭代。能快速的做出这个东西,我觉得跟我们前面的积累有非常深的关系。

在 AI 产品的持续研发过程中,我们发现必须得有快速的迭代,你晚一分钟都不行。另外在这种新方向的尝试上,新的 AI 产品上得注意细节,特别是钻研垂类。

我们做了模型基座不能做的事情,其中的很多细节是我们打磨的,比如部署时云盘的链接,模型知识中调用工具依赖版本的问题,所有这些都是链路上的优化。

俞超:NoCode 在内部至少每周会发布一个新版本,多的时候每周两个版本。在把内部版本转换成可以对外的版本后,我们也会继续保持这样节奏迭代。

14、另一方面,对使用 AI 的人来说,使用大模型是对已有专业知识的放大,未来人与 AI 合作开发的新形式,对人提出了哪些新要求?

程大同:有很多需要改变的地方。我认为大家都需要持续学习,对于参与者来说,你得看 paper,了解从后端到前端的算法、工程问题,你要去用很多产品。

对于 AI 产品的使用者来说,上手去做很重要。你需要输入第一个 query,保持耐心。现在还不是 AGI 的时代,但越来越多的事情已经可以由 Agent 自动化来帮你完成了。你要学会在这个 human-in-the-loop(人在回路)的环境中快速交付结果,而不仅仅是提效。

如果你拥有更多专业编程知识的话,还可以去尝试更加专业的开发工具。

我认为 AI 编程未来会变成「车与司机」的关系 —— 三十年前大家认为司机是个职业,但是现在基本上大家都能开车,未来自动驾驶出现,甚至都不需要开车了,编程这种技能会变得非常具有普适性。

15、下一步会是什么?能否透露一下 NoCode 未来的发展方向,美团是否会推出更多的生产力应用?

程大同:对于 NoCode 来讲,我们会在近期持续提升稳定性与体验,对模型进行持续的优化。更长期的看,发展方向可能会在于打通非专业到专业的 AI 开发自动化。我们希望能够提出一个比较好的开发环境,在 IDE 领域进行探索。

我们可能在 6 月发布开发工具「Dev Mode」,实现更专业的 IDE,构建全量的代码、编译能力。

,时长02:17

美团演示了正在开发的 Dev Mode 模式,向更专业需求提供了更加复杂的能力。

我们不知道 NoCode 会在市面上创造出怎样的影响,但我觉得能有多少影响,就创造多少影响。能够以务实的态度做好产品,聚焦效果,聚焦产品能力,我们的目标就是这样。

#LaViDa

多模态扩散模型开始爆发,这次是高速可控还能学习推理

近段时间,已经出现了不少基于扩散模型的语言模型,而现在,基于扩散模型的视觉-语言模型(VLM)也来了,即能够联合处理视觉和文本信息的模型。今天我们介绍的这个名叫 LaViDa,继承了扩散语言模型高速且可控的优点,并在实验中取得了相当不错的表现。

现目前,几乎所有流行的 VLM 都是基于大型语言模型(LLM)构建的,而这些模型采用的范式是自回归(AR),即按照从左到右的顺序逐一生成 token。

在很多任务上,自回归模型都表现出色,不过缺点也仍然存在。首先,由于它们是按顺序生成,因此这个过程本质上难以并行化,从而导致推理速度缓慢。另外,由于它们是从左到右生成,因此难以处理需要双向上下文或结构约束的任务 —— 例如文本填空。

例如,生成一首每行都以特定音节开头的诗歌,或从预定义 JSON 格式的图像中提取结构化信息 —— 这些任务通常需要模型填充或协调整个序列中的内容。即使使用精心设计的提示词和演示,自回归模型仍然难以稳定地满足此类约束。

近段时间,离散的扩散模型(DM)开始崛起,甚至被许多人认为是自回归 LLM 的一种有力替代,比如我们曾报道过的首个 8B 扩散大语言模型 LLaDA、扩散推理模型 Dream 7B 以及首个商业级扩散 LLM Mercury。

不同于自回归 LLM,扩散模型是将文本生成视为在离散 token 上的扩散过程。会有一个前向过程逐渐将离散文本 token 序列退化(corrupt)为一个掩码 token 序列。在推理过程中,则是从一个掩码 token 序列开始,并通过一个学习到的反向过程逐渐将其转换为一个有意义的文本 token 序列。

相比于自回归 LLM,扩散模型具有多项理论优势,可直接解决自回归生成的局限性。

首先,自回归 LLM 的吞吐量是固定的 —— 每次生成一个 token;而扩散模型则可以通过调整扩散步骤的数量来灵活地控制速度与质量之间的平衡。此外,它们能够建模双向上下文,这使得它们非常适合文本填空等任务,从而实现更有效的约束生成和结构化的输出格式化 —— 这些功能在视觉-语言环境中尤其有价值,因为其输出可能需要遵循特定的模式。

基于这些观察和实践,LaViDa 诞生了,其全称为 Large Vision-Language Diffusion Model with Masking,即「带掩码的大型视觉-语言扩散模型」。

- 论文标题:LaViDa: A Large Diffusion Language Model for Multimodal Understanding

- 论文地址:https://arxiv.org/pdf/2505.16839

该模型来自加利福尼亚大学洛杉矶分校、松下、Adobe 和 Salesforce,算得上是首批基于扩散的 VLM 之一,我们之前还报道过的另外几个多模态的扩散语言模型可供对照:

- 比 Gemini Diffusion 更全能!首个多模态扩散大语言模型 MMaDA 发布,同时实现强推理与高可控性

- 舍弃自回归!国内团队打造纯扩散多模态大模型 LLaDA-V,理解任务新 SOTA

- 谷歌之后,英伟达入局扩散大语言模型,Fast-dLLM推理速度狂飙27.6倍

简单来说,为了使预训练的扩散模型能够感知视觉输入,LaViDa 的做法是使用一个视觉编码器将视觉特征整合进扩散主干网络 —— 类似于 LLaVA 使用视觉输入增强大型语言模型 (LLM) 的方式。训练方法上,他们采用了以扩散为目标的两阶段训练流程:先进行预训练,然后进行监督微调。

下面来详细看看 LaViDa 的具体方法和实验表现。

LaViDa 是如何构建的?

LaViDa 的模型架构与 LLaVa 等常见的自回归视觉-语言模型(VLM)类似。它由视觉编码器和扩散语言模型组成。这两部分通过一个 MLP 投射网络连接。其整体设计如图 2 所示。

视觉编码器:给定输入图像 I 和文本提示词 P,首先将图像大小调整为 768²,并将其分成四个 384² 的不重叠视图,记为 I_{1:4}。另外,按照之前的相关研究,也将原始图像的大小调整为 384²,以获得第五个视图 I_5。

这五个视图分别由视觉编码器(SigLIP-400M)独立编码,每个视图产生 27² 个嵌入,记为 V_{1:5}。总的来算,每个图像会产生 3645 个嵌入。

为了减少序列长度以提高训练效率,该团队还会在每个视图上应用 2×2 平均池化,从而将嵌入减少到了每个视图 14² 个,即总共 980 个。

然后,这五个视图的嵌入会被展平并连接成一维序列,然后由投射网络处理,从而获得扩散语言模型的最终视觉上下文。此过程与自回归 LLM 的视觉编码过程相似,如图 2 底部所示。

扩散语言模型:这里的扩散语言模型是一个多层 Transformer,其架构与 LLM 类似。唯一的主要区别是:它的注意力掩码是非因果式的,并且它使用的建模目标是如下扩散语言建模目标,而不是自回归模型使用的下一个 token 预测。

扩散语言模型的输入包括投射的视觉嵌入、提示词 P ,以及部分遮掩的响应 X_t 。最后一个 Transformer 块的输出会经过最终线性层,以获得无掩码的响应 X_0 的逐 token logit

。在其实验中,他们探索了 LLaDA-8B(默认)和 Dream-7B 作为扩散语言模型。该过程如图 2 的上半部分所示。

下图展示了 LaViDa 的更多技术细节,而有关其训练算法和推理算法的更详细描述请参阅原论文。

LaViDa 的实验表现如何?

从高层面看,LaViDa 总体上采用了一种两阶段训练流程。

在预训练阶段(阶段 1),仅更新投射算子,从而让视觉嵌入与 DLM 的隐空间对齐。

在微调阶段(阶段 2),对所有组件进行端到端联合训练,以实现指令遵循。此外,该团队还对阶段 2 的模型进行了进一步微调,并得到了两个分别用于推理和文本填空任务的专用模型。

主要结果

评估使用了多种视觉-语言任务。表 1 报告了在视觉理解任务上,LaViDa 使用 LLaDA-8B(LaViDa-L)和 Dream-7B(LaViDa-D)作为语言主干网络的结果,另外还有一些对比模型的结果。

可以看到,在一般任务、推理、光学字符识别 (OCR) 和科学等类别的众多任务上,LaViDa 展现出极具竞争力的性能。

其中,在一般性的视觉-语言理解方面,LaViDa-L 在 MMMU 上取得了最高分 (43.3),优于所有同类模型。LaViDa-D 在该类别的多个基准测试中也排名第二。

在推理任务方面,这两个模型在数学密集型和基于空间的基准测试中均超越了规模相似的基线模型。

在科学方面,LaViDa 在 ScienceQA 上取得了最高分和第二高的成绩(分别为 81.4 分和 80.2 分),同时在基于复杂图表的基准 AI2D 上的表现与 Open-Llava-Next 相当。

最后,在 OCR 方面,LaViDa 表现还算不错,但落后于一些最新的自回归模型。该团队分析表示,这种差距主要是因为 LaViDa 使用了平均池化进行视觉 token 压缩,这会导致细粒度空间信息丢失。虽然这在计算预算方面是必要的权衡,但对于需要精确文本识别和布局理解的任务来说,这会带来困难。

整体来看,这些结果凸显了 LaViDa 的优势,表明基于扩散的方法颇具竞争力,可以与自回归模型一样 scale,同时在多种视觉-语言任务上取得稳健的表现。

推理蒸馏

为了提升 LaViDa 模型的推理能力,该团队使用从 VL-Rethinker-7B 蒸馏出的 1.92 万个 CoT 样本又进行第三阶段训练。最终,他们得到了一个推理模型 LaViDa-Reason,并在 MathVista、MathVerse 和 MathVision 上进行了评估,结果见表 2a。

在这些任务中,最大生成长度 L 设置为 1024。从结果可以看到,LaViDa-Reason 在所有基准测试中均优于 LaViDa,在最难的 MathVision 推理数据集上更是提升明显(相对提升了 18%)。

文本填空

LaViDa 为文本生成提供了强大的可控性,尤其是在文本填空方面。

给定一份由 L 个 token 构成的草稿,其中包含 L_M 个掩码,跳转到时间步骤 t = L_M / L 并运行标准推理直到 t = 0。这会直接将 L_M 个掩码替换为 L_M 个 token。

然而,在实践中,补全所需的 token 数量可能会更少 —— 例如,There is a [M][M][M][M] in the image 可能会变成 dog 或 traffic light。

为了支持长度可变的补全,该团队使用阶段 2 数据一个 20% 的子集进行了额外的阶段 3 训练,并将该模型命名为 LaViDa-FIM。

在训练期间,他们会在文本中间插入随机长度的 [S]...[S][FIM] 序列。在推理时,则将 [FIM] 附加到已遮掩的片段(例如 [M][M][M][M][FIM])以为灵活的终止提供信号。然后,该模型可以生成类似 [dog][S][S][S][FIM] 或 [traffic][light][S][S][FIM] 形式的补全。

虽然 FIM 目标通常是在语言任务(例如代码补全)的语境中讨论,但它们与多模态应用同样相关。

图 4a 展示了有约束诗歌生成的定性结果,其中模型需要生成一首描述图像的诗歌,并且每行要以特定的音节开头。与自回归模型不同,LaViDa 和 LaViDa-FIM 都成功完成了任务。值得注意的是,LaViDa-FIM 会动态调整每行的 token 数量。

表 2b 则展示了 100 个样本的定量结果:这两个 LaViDa 变体均实现了 100% 的约束满足率,而对比的自回归模型则均在 50% 以下。

速度与质量的权衡

通过控制离散化步数 K,LaViDa 提供了一种便捷的方法来实现速度与质量的权衡。

基于 COCO 2017 val 数据集的 500 张图像,该团队比较了不同 K 值下的图像描述性能。其中 K ∈ {32, 24, 16, 8},等价地 NFE∈ {100%, 75%, 50%, 25%}。

图 4b 报告了在单个 A5000 GPU 上测得的每张图像的平均延迟和 CIDEr 分数。

当 NFE=100% 时,LaViDa 的 CIDEr 得分高于自回归基线,但速度略慢。当 NFE=75% 和 NFE=50% 时,LaViDa 的速度比自回归基线更快,并且质量更好。当 NFE=25% 时,速度明显更快,但性能略逊一筹。这表明 LaViDa 可以根据应用需求灵活调整其推理速度,允许用户根据具体需求在生成延迟和输出质量之间进行权衡。

此外,该团队还研究了 KV 缓存的影响和噪声调度,并进行了消融研究,详见原论文。

#Agentic ROI

大模型智能体如何突破规模化应用瓶颈,核心在于Agentic ROI

本文第一作者为上海交通大学计算机学院副教授刘卫文,研究方向为大模型智能体,大语言模型,个性化算法等。

近年来,随着大语言模型的快速发展,基于其构建的大模型智能体(LLM Agents)正逐步从技术演示走向实际应用部署。然而,真正实现规模化应用仍面临诸多瓶颈。使用范围主要集中于专业领域,如代码生成、科研辅助等。在大众、高频、日常的应用场景(如电商、个人助理)中,普及率依然较低。这一现象引发了一个关键问题:

当前制约大模型智能体实际可用性的真正原因是什么?

上海交通大学联合中科大在本文中指出:现阶段大模型智能体的主要障碍不在于模型能力不足,而在于其「Agentic ROI」尚未达到实用化门槛。

论文题目:The Real Barrier to LLM Agent Usability is Agentic ROI

论文链接:https://arxiv.org/pdf/2505.17767

Agentic ROI:大模型智能体实现规模化应用的关键瓶颈

研究团队提出 Agentic ROI(Agentic Return on Investment)这一核心指标,用于衡量一个大模型智能体在真实使用场景中所带来的「信息收益」与其「使用成本」之间的比值:

- Information Quality:指智能体所生成的信息质量,包括准确性、完整性等。

- Quality Threshold:指最低可接受的信息质量阈值(注:根据上下文推断)。

- Human Time和 Agent Time:分别指人类与智能体完成对应任务所需的时间。

- Interaction Time:指用户与智能体交互所需要的时间,如用户进行任务描述、验证结果过程中所消耗的时间。

- Expense:指用户经济成本,如模型调用、API 使用的开销。

只有当信息质量超过一定阈值,且智能体所节省的时间和成本之比足够高时,智能体才真正具备可用性。

如上图所示,当前大部分 LLM 智能体集中应用于人类任务时间成本高的信息密集型场景(如科研、编程),此类任务本身就需要大量人力投入,因此即便智能体部分替代也能显著提高效率。然而,在用户量庞大的日常场景中(如电商、搜索、助理等),任务本身较为简单,交互成本低(如点击、下滑操作),智能体提升的边际价值不明显,反而可能引入额外的交互成本和延迟,从而导致 Agentic ROI 较低。

因此,当前高用户需求与低 Agentic ROI 之间的矛盾,反映了智能体在日常应用中的实用性不足,需进一步优化信息价值、智能体任务完成时间、及交互时间以填补市场空白。

优化 Agentic ROI 智能体发展的「之字形」轨迹

研究团队提出,LLM 智能体的发展路径并非线性增长,而是呈现出一种「先规模化、后轻量化」的「之字形」发展模式:首先规模化(scaling up)参数规模、训练数据、推理能力以提升信息质量;之后在保证信息质量的前提下,轻量化(scaling down)进行模型压缩、蒸馏、推理优化以减少智能体所用时间与调用成本。我们正处于智能体规模化发展的高峰阶段,优先提升信息质量。

基础模型如 OpenAI 系列模型的发展也体现了这一「之字形」发展趋势:同系列模型如 o1-mini 到 o1 模型表现显著增强,而新一代小模型如 o3-mini 则在持平 o1 性能的同时显著降低了推理费用和延迟。

规模化提升信息质量(Scaling Up)

预训练规模化(Pre-training Scaling)

预训练阶段通过扩大模型规模、数据量和计算资源,使智能体在语言理解、推理和世界知识等基础能力方面获得稳步提升。而规模化使用包含任务结构和操作流程的文档数据(如操作手册、工作流程指南)能够帮助模型学习实际任务的分解逻辑和执行顺序。此外,随着上下文窗口的扩展和记忆机制的引入,智能体可以处理更长的交互历史和用户偏好,从而提升多轮任务执行的能力。

后训练规模化(Post-training Scaling)

后训练阶段(如监督微调和强化学习)使智能体更贴近人类的需求与价值观。同时,智能体性能提升还依赖于大规模复杂环境(网页、API 接口)交互轨迹数据,使用外部工具进行操作决策。此外,在真实部署中积累的用户反馈、任务完成记录和错误修复数据,构成了智能体持续学习与演化的基础,形成智能体的数据飞轮,使其在真实使用中不断优化行为。

推理时规模化(Test-time Scaling)

推理时规模化包括:

- 规模化推理步骤(Scaling reasoning process),以应对复杂任务并生成更可靠的输出;

- 规模化多智能体系统(Scaling multi-agent system),通过协作完成任务分解与执行;

- 扩展工具调用(Scaling tool calling),通过多次工具调用使智能体能够逐步验证中间结果;

- 扩展推理时训练(Scaling test-time training),通过利用无标签测试数据实时更新快速适应新任务或用户需求

- 有约束条件下直接优化 Agentic ROI(Scaling towards Agentic ROI under budget constraints),智能体可在给定预算约束(如时间、API 成本)下动态评估每一步操作信息收益,直接整体优化 Agentic ROI。

构建世界模型(Building World Model)

构建真实的「世界模型」对于实现真正规模化数据合成、智能体评估至关重要。世界模型应支持多模态交互(语言、图像、文档、音频),具备处理多步骤、长时程任务的能力,并能模拟用户的多样化偏好与反馈机制。此外,它还应反映现实世界中的不确定性,例如信息不完全、用户意图变化、环境干扰等。

确保鲁棒性与安全性(Ensuring Robustness & Security)

确保智能体行为的稳健性与安全性也是提升信息质量的重要一环。鲁棒性方面,智能体应防止奖励机制被利用,避免出现「奖励黑客」现象;安全性方面,需要防范训练数据污染、防止反馈被篡改和后门攻击等。在运行过程中,智能体应配备异常检测和事实核查能力,确保输出内容的准确性与一致性。同时,构建行为审计机制和可解释性工具,可以提升智能体的可控性和可靠性。

轻量化降低智能体时间与成本(Scaling Down)

减少智能体任务完成时间

引入记忆机制: 引入记忆机制是提高效率的重要手段。具备记忆能力的智能体可以跳过重复计算,直接调用以往任务中积累的知识,从而加快处理速度。这种方式模拟人类专家的行为,依靠经验而非实时推理来完成任务。

模型压缩: 通过模型压缩或蒸馏来减少计算资源和推理延迟,是另一个核心方向。借助模型蒸馏等技术,可以将大模型的能力迁移到更小的模型中,从而在不显著降低性能的前提下,显著缩短响应时间、减少部署成本。

优化推理策略: 智能体的时间消耗不仅来源于计算,还受到推理链条长度的影响。如果推理过程过于复杂或冗余,例如频繁的自我反思、递归规划等,可能会延长任务完成时间而未带来质的提升。因此,更高效的智能体应具备「少而精」的思维能力,能够通过最短路径达成最优解。

基础设施优化: 硬件层面的升级,如 Groq 和 Cerebras 等新型 AI 芯片,以及软件层面的优化,如 vLLM 和 FlashAttention 等推理引擎,都能显著提升模型运行速度。只有软硬件协同进化,才能真正满足低延迟、实时响应的实际需求,从而提升智能体的整体可用性。

降低成本

降低交互时间: 当前的智能体往往要求用户提供冗长、明确的指令,这带来了较高的使用门槛与认知负担。为此,智能体的交互方式应从被动解析输入,转向主动理解用户意图,具备一定程度的目标推理与任务自完成能力。这种转变不仅可以减少用户的操作负担,也有助于提升整体使用体验。此外,产品设计上的新范式也有助于进一步降低用户交互时间。

降低开销: 智能体的运行费用可能因模型规模、推理深度、调用外部工具等因素而迅速上升。尤其在大规模部署或持续运行场景下,成本问题尤为突出。因此,未来的智能体需要更智能地管理上下文,合理控制推理复杂度与工具调用频率,确保在保证性能的前提下,尽可能降低资源消耗与使用开销。

Agentic ROI 提供了一个衡量智能体真实可用性的系统框架,帮助我们超越模型性能的单一维度,转向「实际效益」导向的设计与评价逻辑。智能体的「可用性」不应仅以模型性能定义,而应以综合效益衡量。在实际部署中,Agentic ROI 为我们提供了一个更贴近真实世界的评价维度,帮助我们识别系统中被忽视的「隐藏成本」,并指导我们构建真正高效、可用、可负担的智能体系统。

#Fast-dLLM

谷歌之后,英伟达入局扩散大语言模型,Fast-dLLM推理速度狂飙27.6倍

在大语言模型(LLM)领域,推理效率是制约其实际应用的关键因素之一。谷歌 DeepMind 的 Gemini diffusion 曾以 1400 tokens / 秒的生成速度震惊学界,展现了扩散模型在并行生成上的潜力。然而,开源扩散 LLM 却因缺乏 KV 缓存机制和并行解码质量衰退,实际推理速度长期被自回归模型压制.

近日,NVIDIA 联合香港大学、MIT 等机构重磅推出 Fast-dLLM,以无需训练的即插即用加速方案,实现了推理速度的突破!

论文:Fast-dLLM: Training-free Acceleration of Diffusion LLM by Enabling KV Cache and Parallel Decoding

项目地址:https://nvlabs.github.io/Fast-dLLM

论文链接:http://arxiv.org/abs/2505.22618

GitHub 链接:https://github.com/NVlabs/Fast-dLLM

通过创新的技术组合,在不依赖重新训练模型的前提下,该工作为扩散模型的推理加速带来了突破性进展。本文将结合具体技术细节与实验数据,解析其核心优势。

一、 核心技术

分块 KV 缓存与置信度感知并行解码

1. 分块 KV 缓存(Block-Wise KV Cache):激活重用率超 90% 的双向加速

传统扩散模型因双向注意力机制难以直接复用计算结果,导致长序列推理效率低下。Fast-dLLM 提出分块 KV 缓存机制,通过以下设计实现高效计算:

- 双向缓存策略:采用 DualCache 同时缓存前缀(Prompt)和后缀(Masked Tokens)的注意力激活值(KV Cache),如图 1 (a)(b) 所示。在分块生成时,前序块的 KV 激活可直接复用于后续块,减少重复计算🔄。

- 高相似度验证:实验表明,相邻推理步骤的 KV 激活余弦相似度接近 1(图 2),证明缓存复用的可行性。例如,在 LLaDA 模型中,通过缓存可实现 90% 以上的激活重用,单步计算量显著降低。

2. 置信度感知并行解码(Confidence-Aware Parallel Decoding)

并行解码虽能提升速度,但条件独立假设易破坏 token 依赖关系,比方说这个例子 The list of poker hands that consist of two English words are: _ _.。后续两个单词可以是 “high card,” “two pair,” “full house,” 或者是 “straight flush.”。值得注意的是,这两个单词之间存在关联。

然而,MDMs 中的多令牌预测过程首先为每个令牌生成一个概率分布,然后从这些分布中独立采样。这种独立采样可能导致不理想的组合(如生成 “high house” 等无效组合)。Fast-dLLM 通过动态置信度筛选解决这一问题(所谓置信度,是指模型给 token 赋予的概率大小):

- 阈值激活策略:仅对置信度超过阈值(如≥0.9)的 token 进行并行解码,低置信度 token 留待后续步骤处理。如图 3 所示,该策略可在保证生成质量的前提下,并行输出多个 token。

- 理论证明:当 (n+1)ϵ≤1 时(n 为并行解码 token 数,并且并行解码的 n 个 token 的置信度都大于 1-ϵ),贪婪解码策略下并行解码与顺序解码结果一致,从数学层面确保了生成逻辑的连贯性。

3. 伪代码:分块 KV 缓存与置信度感知并行解码流程

以下是 Fast-dLLM 算法的核心伪代码,结合了分块 KV 缓存以及置信度感知并行解码,无需训练就可以在现有的开源 Diffusion LLM(如 LLaDA、Dream)上即插即用进行推理加速。

二、 性能突破

速度与精度的均衡优化

1. 长文本生成:27.6 倍端到端加速

在 LLaDA 模型上,针对 1024 token 的长文本生成任务,Fast-dLLM 将单步延迟从 0.26 秒降至 0.09 秒,整体耗时从 266 秒压缩至 12 秒,实现 27.6 倍端到端加速。这一提升在代码生成、数学推理等长序列场景中尤为显著,例如 8-shot 提示的 GSM8K 任务中,加速后仍能保持 76% 的准确率。

2. 精度保持:损失 < 2% 的基准测试表现

在主流基准测试中,Fast-dLLM 的准确率损失控制在 2% 以内:

- GSM8K(5-shot):LLaDA+Fast-dLLM 准确率为 78.5%,仅比基线低 0.8%,但吞吐量提升 8.1 倍(图 5)。

- HumanEval(代码生成):准确率达 44.5%,较基线提升 1.2%,同时吞吐量提升 3.7 倍。

- 多模型兼容:在 LLaDA、Dream 等模型上均实现高效加速,验证了技术的通用性。

三、 应用价值

无需训练的即插即用方案

Fast-dLLM 的零训练成本特性使其成为理想的推理优化工具,能够快速集成到现有的系统中。对于那些已经在使用扩散模型的企业和开发者来说,可以在不改变模型架构和训练流程的基础上,直接利用 Fast-dLLM 提升推理效率,缩短长文本生成耗时,为实际部署提供更可行的方案。

四、 总结与展望

Fast-dLLM 通过分块 KV 缓存与置信度感知并行解码的创新组合,实现了扩散模型推理效率的跨越式提升,同时保持了生成质量的稳定性。其技术设计为非自回归生成模型提供了新的优化范式,有望推动扩散模型在实时交互、长文本生成等场景中的广泛应用。未来,随着模型规模的扩大和蒸馏技术的深化,Fast-dLLM 或将进一步缩小与自回归模型的性能差距,成为 LLM 推理加速的核心方案之一。

#自动化失败归因(Automated Failure Attribution)

谁导致了多智能体系统的失败?首个「自动化失败归因」研究出炉

想象这样一个场景:你开发了一个由多个大型语言模型 Agent 组成的智能团队,它们协作完成复杂任务,比如一个 Agent 负责检索,一个负责决策。然而任务失败了,结果不对。

问题来了:到底是哪个 Agent 出了错?又是在对话流程的哪一环节?调试这样的多智能体系统如同大海捞针,需要翻阅大量复杂日志,极其耗时。

这并非虚构。在多智能体 LLM 系统中,失败常见但难以诊断。随着这类系统愈加普及,我们急需新方法快速定位错误。正因如此,ICML 2025 的一篇 Spotlight 论文提出了「自动化失败归因(Automated Failure Attribution)」的新研究方向,目标是让 AI 自动回答:是谁、在哪一步导致了失败。

该工作由 Penn State、Duke、UW、Goolge DeepMind 等机构的多位研究人员合作完成。

论文标题:Which Agent Causes Task Failures and When? On Automated Failure Attribution of LLM Multi-Agent Systems

arXiv 地址:https://arxiv.org/pdf/2505.00212

代码地址:https://github.com/mingyin1/Agents_Failure_Attribution

背景挑战

LLM 驱动的多智能体系统在诸多领域展现出巨大潜力,从自动化助手协同办公到多 Agent 合作完成 Web 复杂操作等。然而,这些系统脆弱性也逐渐显现:多个 Agent 之间的误解、信息传递错误或决策不当,都可能导致整体任务失败。

对于开发者来说,一个失败案例往往意味着必须手动审阅长长的对话日志,试图找出哪个 Agent 在哪一步出了差错。这种调试过程既费时费力,也需要调试者对整个任务逻辑非常熟悉。更大的挑战在于,缺乏系统化的方法来定位失败原因 —— 传统评估只关注任务成功与否,但很少深入到「失败责任」这一层面上。

结果就是,多智能体系统一旦出错,我们往往只能知道「出了问题」却无法快速知道「问题出在哪、因何而起」。这种局面严重限制了多智能体系统的改进和可信度。如果无法自动归因失败,我们就难以针对性地加强某个 Agent 的能力或优化协作策略。换言之,失败归因是连接评估与改进的缺失环节。

研究内容

针对上述挑战,这篇 ICML 2025 Spotlight 论文率先提出并 formalize 了 LLM 多智能体系统的自动化失败归因这一新任务。

研究的核心目标:给定一个多 Agent 协作任务的失败日志,自动确定导致失败的罪魁祸首是哪个 Agent(「Who」),以及决定性错误发生在交互的哪一步(「When」)。

为推动这一方向,作者构建了首个用于失败归因研究的基准数据集 ——「Who&When」。该数据集精心收集了 127 个多智能体系统的失败日志,涵盖了多个公开基准(如 GAIA、AssistantBench 等)中的复杂任务,具有相当的多样性。更重要的是,作者为每条失败日志都提供了细粒度的人工标注:

- 标记出导致任务失败的责任 Agent(即「Who」,哪个智能体犯了错)

- 标记出导致失败的关键错误步骤(即「When」,在整个对话 / 操作序列中的第几步出了错)

- 以及相应的自然语言解释(即「Why」,为什么这个错误会导致失败)

基准数据集地址:https://huggingface.co/datasets/Kevin355/Who_and_When

这种标注使得数据集既可用于训练模型自动定位「谁」和「何时」出错,也方便人类分析失败的原因。数据集中「Who」和「When」标注的引入填补了以往多智能体评测中对失败原因关注的空白。可以说,Who&When 数据集为自动失败归因任务提供了首个标准测试床,让研究者能够在统一语境下探索让 AI 自动当「故障侦探」的可能性。

技术细节

有了数据集,接下来作者设计了三种用于自动失败归因的初步方法,并对它们进行了系统比较:

- All-at-Once 方法:将完整的多 Agent 日志一次性交给 LLM,让其整体判断 「哪个 Agent 在哪一步出错」。优点是调用少、成本低,擅长宏观归因;缺点是信息量大,易错过细节。

- Step-by-Step 方法:模拟人工调试,让 LLM 逐轮分析每一步交互,逐步定位错误。优点是粒度细、定位准;缺点是调用频繁、成本高,且误判可能累积。

- Binary Search 方法:对日志进行二分,逐步缩小范围,最终锁定出错步骤。在调用次数和定位精度之间取得平衡,适合长日志。缺点是需要多轮交互,复杂度居中。值得注意的是,每种方法在准确性、成本和粒度上各有权衡,没有一种方法能在所有指标上全面胜出。这三种方案共同构成了自动失败归因任务的初步解法库,探索了从「一步到位」到「循序渐进」再到「折中求解」的不同思路。作者在论文中详细讨论了它们各自的优劣。

实验结果

作者在 Who&When 数据集上对上述方法进行了系统评估,带来了许多发人深省的发现:

- 整体表现有限:当前方法效果仍较差。最佳模型在识别出错 Agent 上准确率仅约 53.5%,而准确定位错误步骤的准确率更低,仅 14.2%,几乎接近瞎猜。一些方法甚至表现不如随机,显示任务本身极具挑战性。

- 各有所长:不同方法擅长不同子任务。All-at-Once 更擅长识别「谁」出错,Step-by-Step 更适合找出「何时」出错,而 Binary Search 表现居中,平衡调用成本和定位精度。

- 混合策略更优但代价高:将多种方法结合(如先用 All-at-Once 找嫌疑 Agent,再用 Step-by-Step 精查)确实提升了准确率,验证了方法间的互补性。但计算成本显著增加,需在效果与资源之间权衡。

- 现有 SOTA 模型乏力: OpenAI o1 或者 DeepSeek R1,表现仍不理想,远未达到实用水平。可见,失败归因任务对 AI 推理与理解能力的要求,远超当前模型在常规任务中的表现,凸显了其挑战性和研究价值。

结论

自动化失败归因有望成为多智能体 AI 系统开发中的重要一环,它将帮助我们更深入地理解 AI 代理的失败模式,将「哪里出错、谁之过」从令人头疼的谜题变成可量化分析的问题。因此,我们可以在评估与改进之间架起桥梁,打造更可靠、更智能的多 Agent 协作系统。

#MaskGIT

一个 Transformer 统一多模态理解和生成!Show-o:LLM 自回归做理解,MaskGIT做生成

本文介绍了一个将多模态理解与生成任务相统一的Transformer模型Show-o,它通过结合自回归和离散扩散建模,创新性地用一个Transformer处理文本和图像的不同特性,并在多种视觉-语言任务中展现出与专门模型相当甚至更优的性能,同时支持文本引导的图像修复与外推等应用,为下一代多模态基础模型提供了新的范式。

LLM 自回归做理解,MaskGIT 方案做生成的理解生成统一模型。

Show-o 是一个 Unified Model,是个生成理解统一模型。Show-o 使用 LLM 自回归做理解,MaskGIT方案做生成的理解生成统一模型。多模态理解方面,Show-o 可以做 visual question-answering 等等,视觉生成方面,Show-o 可以做 text-to-image generation, text-guided inpainting/extrapolation,以及混合模态生成。

1Show-o:MaskGIT 方法做生成理解统一模型

论文名称:Show-o: One Single Transformer to Unify Multimodal Understanding and Generation (ICLR 2025)

论文地址:https://arxiv.org/pdf/2408.12528

项目主页:https://github.com/showlab/Show-o

1.1 Show-o 模型

用一个统一的模型 (Unified Model) 来处理多模态理解和生成任务的常见做法如图 1(c) 所示,比如 Next-GPT, SEED-X,使用模型独立处理视觉域和语言域。另一个最近很热门的方向是:使用单个 Single Transformer 同时处理理解和生成任务。

图1:仅理解,仅生成,和统一理解生成模型的比较

Chameleon 证明了这点,即:早期融合不同模态的数据,通过相同的自回归建模方式生成文本和图像 token。自回归预测图像的一个明显的瓶颈是:

Causal attention 需要大量采样步骤,尤其是处理高分辨率图像或者视频时。扩散模型在视觉生成方面表现出比自回归模型更好的潜力。

这促使作者思考:单个 Single Transformer 能否同时涉及自回归和扩散建模?

Show-o 设想了一种新的范式,即文本被表示为 discrete tokens,用大语言模型 (LLM) 自回归建模。图像被表示为连续的,使用 Denoising Diffusion Model 进行建模。

然而,由于离散文本 token 和连续图像表征之间的显着差异,将这两种不同的技术集成到一个单一网络中并非易事。另一个挑战是,现有的最先进的扩散模型通常依赖于 2 个不同的模型,即 Text Encoder 对文本 Condition 信息进行编码,以及用于预测噪声的去噪网络。

Show-o 可以同时处理理解和生成任务,使用自回归-扩散混合建模。Show-o 建立在预训练 LLM 上,继承了基于文本的推理的自回归建模能力。Show-o 还采用 discrete denoising diffusion model 对离散图像 token 进行建模。为了适应任务的不同输入数据和变化,采用文本 tokenizer 和图像 tokenizer 将它们编码为离散 token,并进一步提出了统一的提示策略,将这些 token 作为输入处理。因此,给定一个伴随问题的图像,Show-o 自回归给出答案。当只提供文本 token 时,Show-o 以离散去噪扩散的风格生成图像。

Show-o 基于 MaskGIT[1]。MaskGIT 是一种 mask token prediction 的方法。

Show-o 的最终目标是开发一个统一模型,涉及自回归和扩散建模,且可以联合多模态理解和生成。

核心问题:

- 如何定义模型的输入和输出空间?(1.3 节,tokenizing text 和 image 数据到 discrete tokens)

- 如何统一来自不同模态的各种输入数据?(1.4 节,架构和 unified prompting)

- 如何在单个 Transformer 中涉及自回归和扩散建模?(1.4 节)

- 如何有效地训练这样一个统一的模型?(1.5 节,3 阶段训练策略)

1.2 Show-o Tokenization

Show-o 建立在预训练的 LLM 上,在离散空间上执行统一学习是一种自然的方式。需要维护一个统一的词汇表,其中包括离散文本和图像 token。统一模型的任务是预测离散 token。

Text Tokenization

Show-o 基于预训练的 LLM,使用相同的 tokenizer 进行文本数据标记化,无需任何修改。

Image Tokenization

按照 MAGVIT-v2[2]的做法,训练一个 quantizer,维持一个 K=8,192 的 codebook,把 256×256 图片编码为 16×16 的 discrete token。按照 MAGVIT-v2 的原因是它易于微调,可以很容易变成一个 video tokenizer。

图2:在多模态理解生成统一模型中,图像编码的几种方式:(a) 使用 vector quantization 在离散空间中操作;(b) 和 (c) 在连续空间中操作。Show-o 使用 (a) 模式

还有 2 种做法是使用 continuous 的图片表征,如图 2(b),2(c) 所示。Show-o 默认使用 discrete image tokens 用于理解和生成。

1.3 Show-o 模型架构

Show-o 继承了现有 LLM 的架构,除了添加 QK-Norm 操作外,没有任何架构修改。作者使用预训练 LLM 的权重初始化 Show-o。

Unified Prompting 策略

为了统一训练多模态理解和生成,作者设计了一种 Unified Prompting 策略来格式化各种输入数据。给定 image-text pair,首先 tokenized 变为 个 image tokens 和 个 text tokens 。根据图 3 所示的格式的任务类型将它们形成输入序列。

[MMU] 和 [T2I] 是预定义的 task token,表示输入序列的学习任务。

[SOT] 和 [EOT] 分别作为表示 text token 的开始和结束 token。

[SOI] 和 [EOI] 分别作为表示 image token 的开始和结束 token。

图3:Unified Prompting 策略图解

使用这种提示设计可以有效编码各种输入数据进行多模态理解、文生图和混合模态生成。一旦训练好,就可以相应地提示 Show-o 以处理各种视觉语言任务,包括视觉问答和文生图。

Omni-Attention 机制

Show-o 的注意力机制并非全是 Causal Attention,也并非全是 Full Attention,而是一种综合注意力机制,根据输入序列的格式自适应地混合和更改。

如下图 4 所示,Show-o 能够以不同的方式对各种类型的信号进行建模。Show-o 通过 Causal Attention 对序列中的文本 token \textbf{v} 进行建模。对于图像 token \textbf{u} ,Show-o 通过 Full Attention 建模它们。给定一个格式化的输入序列:

多模态理解中 (图 4(a)),文本 token 可关注所有先前的图像 token。

文生图中 (图 4(b)),图像 token 能够与所有先前的文本 token 交互。

文本建模中 (图 4(c)),退化为 Causal Attention。

图4:Omni-Attention 机制。深色方块代表 "attend",白色方块表示 "不允许 attend"。它是一种具有 causal attention 和 full attention 的混合注意力,根据输入序列的格式自适应地混合和更改。

1.4 Show-o 训练目标

为了执行自回归和(离散)扩散建模,Show-o 采用了 2 个训练目标:

- Next Token Prediction (NTP)

- Mask Token Prediction (MTP)

给定 个 image tokens 个 text tokens 。

NTP 使用语言建模损失来最大化文本 token 可能性:

式中, 代表条件概率, 为 Show-o 的权重。

MTP 作为另一个训练目标,可以无缝集成到 discrete diffusion modeling 中。对于输入序列中的 个 image tokens ,首先以一定的比例(受 timestep 控制)随机将图像 token 随机替换为[MASK]token,得到 。然后目标是以 unmasked 区域和 text token 为 condition,重建原始的图像 token。可以写成:

注意到这个损失函数仅应用于 masked token。具体来说,以 unmasked image token 和所有 text token 为条件,重建那些 masked image tokens。遵循 classifier-free guidance 的做法,以一定的概率用空文本 "" 随机替换 conditioned text token。

给定 1 个 Batch 的输入序列,总的损失函数:

其中, 是超参数。

图5:Show-o。输入数据,无论模式如何,都被 token 化,然后按照指定的格式输入。Show-o 自回归地处理 text token (causal attention 模式),使用离散扩散模型处理 image token (full attention 模式)

1.5 Show-o 训练策略

Show-o 采用 3 阶段的方法逐步有效地训练 Show-o:

- Stage 1:Image Token Embedding 以及像素依赖关系的学习。 使用 RefinedWeb 数据集来训练 Show-o 以保持语言建模能力。同时,采用 ImageNet-1K 数据和图像-文本对分别训练 Show-o 进行类条件图像生成和图像字幕。作者直接使用 ImageNet-1K 中的类名作为文本输入来学习类条件图像生成。这一阶段主要涉及学习 learnable embeddings 为今后的离散图像 token 打底,还有图像生成的像素依赖关系,以及图文之间的对齐来进行图像字幕。

- Stage 2:多模态理解和生成的图文对齐。 基于预训练的权重,继续训练文生图。这一阶段主要关注图像字幕和文生图中的图像和文本对齐。

- Stage 3:高质量的数据微调。 结合高质量图文对进行文生图,以及教学数据进行多模态理解和混合模态生成。

1.6 Show-o 推理

推理中,Show-o 涉及 2 种类型的预测,即 text token 和 image token。

在多模态理解中,给定图像和问题,text token 是从具有更高置信度的预测 token 中自回归采样的。

在视觉生成中,生成图像需要 步。最初,是 个 text token 作为 condition,以及 个 [MASK]token 作为输入。然后 Show-o 为每个[MASK]token 预测一个 logit ,其中 是时间步。每个[MASK]token 的最终预测 logit 使用 conditional logit 和 masked token 的 unconditional logit ,通过下式计算:

其中, 是 guidance scale。

每一步保留置信度更高的 image token,同时用[MASK]token 替换置信度较低的 image token,这些 token 随后都被反馈到 Show-o 以进行下一轮预测。图 6 提供了一个说明。这个去噪过程需要 步,类似于 Diffusion Model 的方法。

图6:增加噪声的 image corruption 过程,以及逐渐去噪的图像生成过程

1.7 Show-o 实验设置

数据: 3种类型的数据:

- Text-only Data: 使用公开可用的 RefinedWeb 数据集来保留预训练的 LLM 的文本推理能力。

- Image Data with Class Names: 使用来自 ImageNet1K 数据集的 1.28M 图像来学习像素依赖关系。

- Image-Text Data: 多模态理解和生成,从公开可用的数据集中组装了大约 35M 的图像-文本对,包括 CC12M 、SA1B 和 LAION-aesthetics-12M。此外,通过结合 DataComp 和 COYO700M 以及一些过滤策略,进一步将数据规模增加到 2.0B 左右。使用 ShareGPT4V 来重新描述这些数据集。此外,LAION-aesthetics-12M 和 JourneyDB 作为用于最终微调的高质量数据集。继 LLaVA-v1.5 之后,结合了 LLaVA-Pretrain558K 和 LLaVA-v1.5-mix-665K 做指令微调。此外,GenHowTo 用于混合模态生成。

评价指标:

多模态理解 benchmark:POPE, MME, Flickr30k, VQAv2, GQA, MMMU

视觉生成 benchmark:FID on MSCOCO,GenEval

训练过程:

Stage 1:RefinedWeb,35M image-text pairs,ImageNet-1K 联合训练 500K steps。训练语言建模,图像字母,和 class-conditional 图像生成。

Stage 2:35M image-text pairs 训练 1000K steps。训练文生图。

Stage 3:高质量 image-text pairs。训练遵循指令。

1.8 Show-o 评测

多模态理解

图 7 显示了 Show-o 在公共基准上的多模态理解能力,例如图像字幕和视觉问答任务。与 understanding only 模型 (包括 InstructBLIP、Qwen-VL-Chat 和 mPLUG-Owl2 在多模态理解方面进行比较时,本文模型模型大小会小得多,在 POPE、MME、Flickr30k 和 VQAv2 benchmark 中也取得了有竞争力的性能,并且在 GQA benchmark 测试中表现更好。与具有大量参数的 Unified Model 相比,例如 NExT-GPT-13B 和 Chameleon34B,Show-o 在 Flickr30k benchmark 中也取得了不错的性能,并在 VQAv2 benchmark 上表现更好。

图7:多模态理解 benchmark 结果

图 8 展示了 Show-o 的视觉问答能力并与 Chameleon 和 SEED-X 进行了比较。

图8:多模态理解定性结果

视觉生成

MSCOCO 30K 结果

图 9 展示了 MSCOCO 30K 的 Zero-shot FID 结果。与使用更多参数和训练图像 (如 GLIDE 和 DALL·E 2) 训练的模型相比,Show-o 实现了更好的 FID (9.24),只有 1.3B 参数和 35M 训练数据。与 Unified Model 相比,Show-o 也表现出了提升。值得注意的是,MSCOCO 30K 上的 FID 可能无法全面准确地评估生成保真度。原因在于现有的生成模型通常是用与 MSCOCO 数据集分布不一致的高质量和美学图像微调之后得到的。因此,这种不匹配导致生成保真度的测量不准确。

图9:MSCOCO zero-shot FID 结果

GenEval 结果

作者评估了 Show-o 在 GenEval benchmark 上的文生图能力,结果如图 10 所示。当与 LDM (1.4B) 等类似大小的模型比较时,Show-o 在所有 6 个指标中都获得了显著更好的性能,总体提高了约 0.31。此外,Show-o 实现了比模型尺寸大 5 倍的 DALL·E 2 更好的性能。此外,仅具有 1.3B 参数的 Show-o 实现了比 SD3 (2B) 等参数数量约 2 倍的模型更好的性能。这表明 Unified Model 的生成能力与专业生成模型相当。

图10:GenEval benchmark 结果

图 11 展示了一些比较结果,包括 Diffusion Model,例如 SDv1.5、SDXL、以及自回归模型,比如 LlamaGen,以及 Unified Model,包括 LWM 和 SEED-X。与 SDv1.5 和 LlamaGen 相比,Show-o 表现出更好的视觉质量和图像-文本对齐。例如,如第 2 列所示,SDv1.5 和 LlamaGen 都不能完全理解文本提示并错过生成图像中的一些属性,例如 sunset 和 blue domes。与 SDXL 相比,Show-o 表现出相当的视觉质量和对齐,例如 "a rally car race" 和 "stunning contrast against the vibrant sunset"。

图12:SDXL, LlamaGen, LWM, SEED-X, 和 Show-o 的定性比较结果

参考

- ^Maskgit: Masked generative image transformer

- ^Language model beats diffusion– tokenizer is key to visual generation

#气象服务与低空经济赛道引发热烈反响

“数据要素×”安徽分赛高校宣讲走进中科大

为深入推进“数据要素×”大赛安徽分赛高校动员工作,5月23日,大赛组委会走进中国科学技术大学,围绕“气象服务”与“低空经济”两大赛道,开展专题宣讲与互动交流,吸引百余名青年学子到场聆听,现场气氛热烈,反响良好。

本次宣讲由安徽省数据资源管理局指导,芜湖市数据资源管理局联合承办,旨在面向高校师生深入解读大赛背景、赛道方向与参赛机制,鼓励青年科技人才以赛促研、以赛促创,积极投身数据要素时代的技术突破与应用创新。

宣讲会上,芜湖市数据资源管理局数字芜湖科科长 苗振营介绍了“数据要素×”大赛作为国家级数字经济赛事的重要意义,阐述了安徽分赛“四个赛出”目标:赛出新场景、赛出新技术、赛出新业态、赛出新标准。特别聚焦的“气象服务”与“低空经济”两个赛道,作为国家政策重点支持的前沿方向,不仅具备丰富的数据资源和真实应用需求,也为高校团队提供了广阔的创新舞台。

在气象服务赛道方面,赛题涵盖气象决策支持新模式、指数型产品开发、跨行业数据融合等多个创新方向;而在低空经济赛道,参赛团队将围绕无人机在农业、水利等行业的融合场景及基础设施建设等核心问题开展技术攻关。活动现场,不少学生表示已组建团队、计划参与报名,期待在大赛中展现专业实力、探索落地路径。

据悉,2025年“数据要素×”大赛安徽分赛已于5月全面启动,项目征集工作正在火热进行中。大赛将为获奖团队提供奖金激励、成果转化支持与全国总决赛推荐机会,真正实现“以赛促用、以赛引才、以赛兴业”。

安徽,作为国家数据要素制度改革先行区,正加快推动数据资源市场化配置和数字产业融合发展。高校是数据创新的重要源头,也是未来产业人才的摇篮。本次走进中科大宣讲,是安徽分赛与高校深度联动、聚才育才的重要一环,携手青年力量共同描绘数据要素驱动的产业未来。

#Pangu Embedded

大模型推理的“左右脑”革命!华为盘古Embedded凭昇腾之力,让快慢思考合二为一

孙子兵法有云:“故其疾如风,其徐如林”,意指在行进迅速时,如狂风飞旋;而在行进从容时,如森林徐徐展开。同样,对于大模型,我们也希望其面对简单问题时能减少思考内容,快速输出答案。而当面对困难问题,其可以进行详尽的思考分析,保证输出的准确性。

传统大模型面临二者不可兼得的困境 —— 快思考面对复杂任务显得力不从心,而深度思考面对简单问题经常输出冗余 token。为此,华为盘古团队创新性地提出盘古 Embedded 模型,在多个领域实现了高效精准推理。

基于昇腾 NPU,盘古 Embedded 采用双系统认知架构,在一个模型中集成 “快思考” 与 “慢思考” 双推理模式,并通过两阶段训练及多源动态奖励系统,实现了推理效率与精度的协同提升。

论文标题:Pangu Embedded: An Efficient Dual-system LLM Reasoner with Metacognition

报告地址:https://arxiv.org/abs/2505.22375

序言

大模型推理长期受制于两大矛盾:长链条深度思考与低时延反馈。

为了解决这个问题,基于昇腾 NPU(Ascend Neural Processing Unit)算力,华为盘古团队提出具备灵活切换快慢思考能力的盘古 Embedded 模型。

该模型由两阶段训练框架得到:

在阶段 1 中,模型通过迭代式蒸馏,结合训练过程中的模型合并,以高效地聚合互补知识。RL 过程由多源指导自适应奖励系统(MARS)指导,该系统使用确定性指标和轻量级 LLM 评估器为数学任务、编码任务和通用任务生成动态的、特定于任务的奖励信号。

在阶段 2 中,通过双系统框架赋予模型用于简单任务的 “快” 模式和用于困难任务的的 “慢” 模式。该框架提供了用户控制的手动切换以及问题难度感知的自动切换,以取得推理效率和推理深度的动态平衡。盘古 Embedded 实现了在统一的模型架构中融合快慢思考能力,为开发强大而实用的语言模型指明了方向。

昇腾亲和的快慢思考融合架构:从单推理进化到双推理

问题背景

当前主流的语言模型基于强化学习等策略实现了复杂推理,在数学和代码基准上取得了惊人的成绩。但是通常存在过度思考的问题,庞大的计算开销限制了其更广泛的部署应用,尤其是在资源受限的端侧设备上。

基模型构建

为了系统性地解决上述问题,华为团队在这项工作中提出了 7B 参数量的盘古 Embedded,该模型同时具备快慢思考能力。对于预训练数据与分词器,与该团队之前发布的盘古 Ultra 保持一致。对于后训练数据,引入了推理和非推理多种任务,并通过先验过滤和多样性检验,确保了训练数据的质量和多样性。

在训练策略上,团队提出了基于模型感知型迭代蒸馏(Model-aware Iterative Distillation)的 SFT 方案。这种方法不仅能够动态选择与模型当前能力相匹配的数据样本进行训练,还能通过训练过程中的模型合并策略保留训练早期的知识,从而实现性能的持续提升。具体细节如下:

- 数据合成与验证:教师模型先为初始数据池中的问题生成答案,构建初始蒸馏数据集,并对其进行双重数据验证,包括规则验证和模型验证,以确保数据质量。

- 模型感知型数据难度评估:对于每个数据样本,基于学生模型对输入的 k 次响应与真实答案的匹配情况,计算出数据复杂度分数,以此衡量数据样本的难易程度。

- 迭代训练与动态数据选择:在每次迭代中,根据学生模型的当前能力,选择具有适当复杂度的数据进行训练,以确保训练过程的数据难度适当。

- 训练迭代中的模型合并:通过计算当前迭代得到的 N 个检查点的平均参数差异,并将其应用到前一次迭代的合并模型参数上,实现跨迭代的知识整合,避免知识遗忘,提升模型的稳定性和泛化能力。

模型感知型迭代蒸馏整体架构

重复输出自修正

为了实现重复输出自修正,团队引入了局部 n-gram 重复检测和显式 prompt 注入。其中,前者是在限定窗口内进行 n-gram 比较,以低计算量有效检测重复 token。后者则是通过显式注入特定的 prompt,引导模型自主脱离重复输出。

该方案可有效避免生成长篇连贯文本时的内容重复问题,确保输出结果的高质量。

多源自适应奖励系统与课程数据混合策略

多源自适应奖励系统流程

在强化学习阶段,盘古 Embedded 采用了多源自适应奖励系统(MARS),该系统融合了正确奖励、偏好奖励和其他奖励三部分,保证了模型输出的稳定性和结构完整性。

课程数据混合策略

同时,在强化学习阶段,团队还采用了课程学习策略,通过评估每个数据样本对于当前策略的复杂性,将不同难度的样本组合逐步反馈给模型训练,有助于实现高效且稳定的策略更新。

基于昇腾集群的 RL 基础架构

基于昇腾集群的 RL 基础架构

为了实现基于昇腾的大规模 RL 训练,团队还设计了针对昇腾优化的高效可扩展框架。

首先,通过结合延时同步并行(Stale Synchronous Parallel)调度器和分布式优先级数据队列,该团队解决了大规模 RL 中的协调瓶颈问题,实现了系统吞吐量的显著提升。在 128 个节点的昇腾集群上,相较于完全同步的基线,该框架可减少 30% 的设备空闲时间,同时保持训练的稳定性。

其次,通过主机和设备之间的自适应权重调整,实现了在训练和推理管道之间的模型参数无缝共享。相比于孤立的训练和推理部署,该方法可将吞吐量提升近 2 倍。

最后,通过面向昇腾的 vLLM 推理优化,降低批处理序列之间的延迟方差,从而保证在大规模批处理解码期间的高吞吐量。

快慢思考双系统认知结构

受认知心理学中双过程理论的启发,盘古 Embedded 提出双系统认知架构,使得模型同时具备快思考(System 1)与慢思考(System 2)两种思维能力。

三种不同的思考模式:(a) 传统的推理模型,默认慢思考。(b) 手动切换,允许用户手动调整快思考(System 1)与慢思考(System 2)模式。(c) 自适应切换,模型将基于任务复杂度自动切换快慢思考。

首先,团队实现了手动切换功能,允许用户通过给定的 meta prompt 来指定模型的认知模式,例如 META_PROMPT: system 1 和 META_PROMPT: system 2,分别指代模型采用快思考模式与慢思考模式。这种特殊的 meta prompt 独立于 system prompt,可在避免干扰预期功能的情况下显式指定模型的快慢思考模式。

为了将快慢思考两种不同的能力灌输给模型,团队采用了融合训练的方式:基于已经训练好的一阶段慢思考模型,辅以快慢思考混合数据进行训练。

- 慢思考数据:继续训练部分已经掌握的慢思考数据,避免可能出现的遗忘;

- 快思考数据:引入新的快思考数据(直接输出答案,或者非常短的 CoT)。

在此基础上,分别添加 “System 2” 和 “System 1” 指令,这种训练方式使得模型保留了深度推理能力的同时,能够学习到快速思考的能力,并可以基于用户的指令熟练地切换两种模式。

此外,团队还提出新颖的自适应切换功能,能让模型根据任务的难度自动选择快慢思考。

以数学任务为例:首先判定问题的难易程度 —— 这会用到大模型评估问题的计算复杂度

与思考复杂度

,其中前者主要关注回答中所需要的计算量,如数值计算和符号计算,后者则关注推理步骤的数量,更多的步骤意味着更高的思考复杂度。当

和

时,问题会被分类为简单,其余则为困难。对于简单的问题,采用擅长快思考能力的模型生成答案,并采样正确的回答;而对于困难的问题,采用具备慢思考能力的模型来解答。最终,经由困难与简单样本构建的快慢混合的数据集补充后训练,可实现很好的自适应快慢切换的能力。

模型能力

通用评测榜单

盘古 Embedded-7B 与 Qwen3-8B、GLM-4-9B 和 Nemotron-Nano-8B 的主要对比详见下表。

不同模型在通用领域基准测试的能力对比。盘古 Embedded 的模型参数量级为 7B。“Nothinking (system1)” 和 “Thinking (system2)” 分别对应其快思考和慢思考模式。† 表示结果来自模型官方的报告。每个数据集的最佳结果以粗体显示。

可以看到,在慢思考和快思考模型式下,盘古 Embedded 在多项基准测试中均表现出一流的水准。

在使用 “慢思考” 模式时,盘古 Embedded 在多个推理密集型基准测试中表现出领先能力。在使用可提高推理效率的 “快思考” 模式时,盘古 Embedded 仍具有很强的竞争力。

行业垂域能力拓展性

在通用的推理能力增强之外,团队也探索了在垂域任务的表现。以法律行业为例,团队基于行业语料,通过合成思维过程数据、多种类型数据配比、拒绝采样、蒸馏等技术提升模型的法律专业能力。

不同推理模型在 LawBench 基准上的能力比较

在 LawBench 为代表的法律任务中,在使用了法律领域的长思考数据继续训练之后,盘古 Embedded 在 17 项子任务上的表现有了进一步提高,平均准确率达到 54.59%。这些结果表明,在强大的通用推理模型基础上,通过有针对性的继续后训练,还有很大的空间可以提升在专业任务上的能力水平。

自适应快慢思考模式切换

盘古 Embedded(自适应)在 MATH-500 基准测试中自主激活慢思考模式的比例分析(问题按难度分类)。说明该模型能够根据任务复杂程度自动调整推理深度。

团队在数学测试基准上分析了模型自动采用慢思考的问题比例。结果表明,这一比例随任务复杂程度的不同而变化:对于相对简单的 GSM8K 数据集,慢思考模式的使用率低至 14.56%。而在 MATH500 基准测试中,如上图所示,使用慢思考模式的趋势随着问题难度的增加而单调增加。这表明,盘古 Embedded 能够有效地自动分配推理资源,以取得计算效率和推理准确性的平衡。

总结

华为盘古团队推出基于昇腾 NPU 开发的高效语言模型盘古 Embedded,其在同规格模型中实现了精度和速度的平衡。

该研究的核心创新在于提出的两阶段训练框架:第一阶段通过迭代蒸馏构建鲁棒的基础推理器,关键技术包括模型型感知数据复杂度筛选、训练迭代间检查点融合实现知识巩固,以及采用延迟容忍调度器与多源自适应奖励系统优化的大规模强化学习。第二阶段创新性地赋予盘古 Embedded 双系统快慢思考能力,兼具用户手动切换与自适应模式选择功能,动态平衡推理深度与计算效率,并配合重复自修正机制提升生成质量。

本研究为开发效率更高、性能更强的语言模型提供了新的路径探索。

#Hugging Face 发布史上最亲民人形机器人

250美元起售,还开源

网友笑称: Hugging Face开源的机器人看起来不太聪明。

伊隆・马斯克曾预测称到 2040 年,全球将有 100 亿台人形机器人在工作,而现在,随着 Hugging Face 正式开源发布两款新的人形机器人,让我们离这一预言成真又近了一步。

图源:路透社

此次 Hugging Face 开源的两款机器人分别名为 HopeJR 和 Reachy Mini。

其中 HopeJR 是一款全尺寸人形机器人,拥有 66 个驱动自由度,具备行走和手臂移动能力。

而 Reachy Mini 则是一款桌面机器人,可以移动头部、说话、倾听,并可用于测试 AI 应用程序。

至于大家关心的价格,HopeJR 每台售价约为 3,000 美元,而 Reachy Mini 每台售价约为 250 至 300 美元,具体取决于关税。相比于售价 16000 美元的宇树 G1,这个价格可以说相当良心了。

不过,这些机器人还没有具体的发货时间表。据该公司联合创始人兼首席执行官 Clem Delangue 透露,他们预计至少在今年年底前开始发货首批机器人,目前已开放等候名单。

总之,此次 Hugging Face 开源意味着,任何人都可以组装、重建这些机器人并了解它们的工作原理,而且价格实惠,这样机器人技术就不会被少数拥有危险黑箱系统的大公司所主导。

长的像班德的 HopeJR

网友笑称:像患有帕金森症

HopeJR 是由 Hugging Face 与法国机器人公司 The Robot Studio 联合设计并开源。它长得有点粗糙,框架结构的脑袋上忽闪着两个大眼睛,很像著名搞笑科幻动画《飞出个未来》里的班德。(注:这两个大眼睛现在还不能控制显示。)

它还配备了一对机械臂,人类可以通过一副装有芯片的专用手套远程控制它。HopeJR 的机械臂可以模拟手套佩戴者的动作。Hugging Face 分享的一段演示视频显示,该机器人可以握手、指向纸上的特定文本片段以及执行其他任务。

,时长02:04

视频来自https://x.com/RemiCadene/status/1928015436630634517

和其它人形机器人一样,它也需要开发者手动操控机器人,录制其在模拟或现实环境中的动作数据,然后使用这些数据通过模仿学习算法来训练机器人的自主控制策略。

目前 HopeJR 还只能在 3D 模拟环境中行走,下一步将会从模拟环境中转移到现实世界中。

有网友表示,虽然价格便宜,但这个机器人瘫在椅子上像患有帕金森症,看起来也不太聪明。

现在,该机器人的完整物料清单及零件采购链接均在 GitHub 上提供。

https://github.com/TheRobotStudio/HOPEJr

可伸缩脖子的 Reachy Mini

成本低至 250 美元

Hugging Face 的另一款新机器人 Reachy Mini 同样采用开源设计。它基于该公司今年早些时候收购初创公司 Pollen Robotics 时所获得的技术。

Reachy Mini 是一款外形类似乌龟的机器人,采用矩形外壳设计。其主要机械特征是可伸缩的颈部,使其能够跟随用户移动头部或缩回外壳内。这款固定式外壳结构紧凑轻便,可放置在桌子上。

,时长00:24

视频来自 https://x.com/Thom_Wolf/status/1928103448970473962

在被 Hugging Face 收购的几年前,Pollen Robotics 曾详细介绍过一款内部开发的机器人颈部设计。该模块使用名为 Orbita 的定制执行器进行移动。当时,Pollen Robotics 详细介绍了 Orbita 的动力来自瑞士公司 Maxon Motor AG 的多个紧凑型电机。

Orbita 的颈部设计图,更多详情可访问 https://forum.pollen-robotics.com/t/orbita-presentation/20

Hugging Face 设想,客户可使用 Reachy Mini 开发 AI 应用。例如,一家工业自动化公司可能希望训练一个人工智能模型,使其机器人能够与工厂车间的人类工人互动。Reachy Mini 可用于在将此类软件部署到生产之前对其进行测试。

Reachy Mini 的相关组件可访问 https://github.com/pollen-robotics

看起来,Reachy Mini 属于 Pollen Robotics 开发已经相当长时间的 Reachy 机器人系列 —— 毕竟它们的头看起来差不多。

,时长01:00

装配了机器臂的 Reachy 2 执行简单的烹饪任务。

视频来源:https://x.com/HaixuanT/status/1923671447534194970

据官网介绍,Reachy 2 是第一款专为开发具身人工智能和现实世界应用而设计的开源人形机器人。「Reachy 2 配备两个生物启发式 7-DOF 机械臂,可提供先进的操控能力,并配备了用于远程操作和数据采集的最佳 VR 应用程序,是用于高级感知和无缝人机交互的完美 AI 硬件」。

本月初,还演示了 Reachy 2 与 GPT-4 的集成 —— 让其可以理解英语、西班牙语、法语等多种语言并报以带情绪的响应。

,时长01:50

视频来自 https://x.com/pollenrobotics/status/1920025812939784666

Hugging Face 的机器人之心

事实上,HopeJR 和 Reachy Mini 并非 Hugging Face 在机器人方面的首次尝试 —— 该公司去年就已经发布了 LeRobot 项目,旨在推理自动机器的发展。此平台提供了用于驱动机器人的 AI 模型以及可用于训练这些模型的数据集。Hugging Face 于去年年底发布了其首个硬件蓝图 —— 一款名为 SO-100 的机械臂设计。

- 项目地址:https://huggingface.co/lerobot

- GitHub:https://github.com/huggingface/lerobot

据了解,SO-100 是与一家名为 The Robot Studio 的初创公司合作开发的 —— 这也是 HopeJR 的合作开发方。

从 LeRobot 到 SO-100,再到如今的 HopeJR 和 Reachy Mini,Hugging Face 正在一步步构建起一个开源机器人生态。而这恰恰揭示了开源在机器人发展中的巨大意义:它打破了知识与技术的壁垒,让机器人不再是巨头公司的专属,也不再是锁在黑箱里的昂贵玩具,而是任何人都可以研究、复制、改进、再创造的技术平台。

正如开源软件曾推动整个 AI 行业加速演进,开源硬件与机器人平台的出现,也有望在这一代工程师和研究者中激发出新的浪潮。在这个过程中,机器人不再只是冰冷的机器,而逐渐成为一种「公共智慧」的载体 —— 它由社区共同塑造,也将在社区中不断进化。开放,是智能的真正起点。

马斯克的百亿人形机器人之梦,或许比预想的还要更近一些。

参考链接:

https://techcrunch.com/2025/05/29/hugging-face-unveils-two-new-humanoid-robots/

https://x.com/RemiCadene/status/1928015436630634517

https://x.com/Thom_Wolf/status/1928103448970473962

#RM-R1

从打分器到思考者:RM-R1用推理重塑模型价值判断

「知其然,亦知其所以然。」

这句儒家命题强调,真正的理解不仅在于结果,更在于推理过程。如今,在大型语言模型的后训练阶段,奖励模型承担着桥接模型行为与人类价值的重要职责;但现有模型往往只给出一个分数,却难以解释其依据。缺乏推理的奖励,就如「知其然而不知其所以然」,既难以建立信任,也难以指导更优的学习。

伊利诺伊大学香槟分校的研究团队提出了 RM-R1 框架,将奖励建模重新定义为推理任务,提出了推理奖励模型(Reasoning Reward Models, ReasRMs)。RM-R1 关注于如何通过整合推理能力来增强奖励模型,使其能够更准确地对模型输出进行评估和打分,从而更好地与人类偏好对齐。RM-R1 通过生成结构化的评估标准和推理过程,提升了奖励模型的可解释性和性能。

论文标题:RM-R1: Reward Modeling as Reasoning

论文链接:https://arxiv.org/pdf/2505.02387

代码仓库:https://github.com/RM-R1-UIUC/RM-R1

开源模型:https://huggingface.co/collections/gaotang/rm-r1-681128cdab932701cad844c8

文章验证了三个核心发现:

- 规模带来增益:随着模型变大、计算力增强,RM-R1 的推理链训练方法效果越好,性能几乎线性提升;

- 简单套用旧 RL 策略行不通:想让模型「会推理」,得精准划分问题类型、并对推理过程进行定向蒸馏训练,才能带来真正泛化的提升;

- 推理比直接输出答案更通用:相比传统的直接监督,RM-R1 的推理能力更稳健、更易扩展到新任务,即使训练数据少也有优势。

推理驱动的奖励建模:从评分到解释

RM-R1 引入了「推理奖励模型」(ReasRMs)的概念,将奖励建模视为一个推理过程。模型在评估候选响应之前,先生成结构化的评估标准或推理过程,然后根据这些标准进行评估。这一方法提升了模型的可解释性,使其能够更好地处理复杂的推理任务。

图 1: 直接用现有的 Instruction-tuned model 过拟合于 SFT 数据中的表层模式,无法识别被拒绝回答中的情感伤害和细节缺失。而右下角的推理奖励模型则能跳出表面特征,从回应所造成的深层影响出发进行评估。

核心机制:链式评估准则 (CoR) 如何引导模型「思考」

RM-R1 的核心创新之一在于其引入的链式评估准则(Chain-of-Rubrics, CoR)机制。该机制将奖励建模任务分解为一系列结构化的推理步骤,使得模型在给出最终偏好判断之前,能够像人类专家一样进行深层次的「思考」和评估。CoR 机制的精髓在于其「自适应性」和「内部专家」角色,这不仅提升了评估的准确性,更揭示了模型在复杂任务中进行「元推理」(meta-reasoning)的潜力。

CoR 机制能够根据任务类型动态调整其评估策略。系统提示会指导奖励模型(rθ)首先将每个偏好数据样本分类为「推理型」(Reasoning)或「对话型」(Chat)任务。

对于推理任务(如数学、编程、逻辑推理、多步推理等),模型被指示首先自行解决用户的问题并生成解决方案,并将其封装在 < solution>... </solution > 标签内。这个内部生成的解决方案充当了「标准答案」 或「内部专家」的参考。模型随后会以此为基准,评估两个候选响应的正确性、完整性和推理质量。这种机制使得模型能够进行内部自洽性检查和「自我纠错」,因为它在判断外部答案之前,先独立地得出了自己的「真理」。这种「内部专家」机制使得模型能够进行更深层次的正确性验证,而不仅仅是表层模式匹配,从而显著提高了在复杂推理任务上的判断准确性。

对于对话任务(如开放式对话、安全问题、风格改写或一般性帮助请求),模型则被指示生成定制化的评估准则(rubric),并为每个准则分配权重,同时提供理由(justify),解释选择这些准则及其权重的原因。这些准则和理由被封装在 < rubric>...</rubric > 和 < justify>...</justify > 标签内。随后,模型会根据这些明确定义的准则对两个候选响应进行详细比较和评估,并将评估结果放在 < eval>...</eval > 标签中,最后给出最终判断,如 < answer>[[A]]</answer > 或 < answer>[[B]]</answer>。这种方法反映了人类偏好判断的复杂性和多维度性,模型不再是简单地进行二元判断,而是能够像人类一样权衡多个因素。

CoR 机制通过强制模型遵循预定义的逻辑序列、进行任务特定评估、提供透明的推理痕迹以及将评估基于实际内容而非表面特征,从而实现了深度推理并增强了可解释性。这种「自适应性」表明 RM-R1 不仅仅是学会了「如何推理」,更学会了「何时以及如何应用不同的推理策略」,这是一种更高层次的认知能力,即「元推理」能力。这种能力是其在多样化基准上取得最先进表现的关键,因为它能够为不同类型的任务提供最恰当、最细致的评估。

图 2: CoR 机制将输入样本划分为两类之一:对话类(chat)或推理类(reasoning)。这种任务感知机制使模型能够根据任务类型灵活调整推理策略,从而生成更契合、更有效的奖励信号。

训练流程:从推理蒸馏到强化学习

RM-R1 的训练包括两个关键阶段:

- 推理蒸馏:从高质量的推理链中提取知识,训练模型生成结构化的评估标准。

- 强化学习:使用可验证的奖励信号,进一步优化模型的推理能力。

这一训练流程使得 RM-R1 在 RewardBench, RM-Bench 和 RMB 等多个奖励模型基准测试中表现出色,超过了更大规模的开源模型(如 INF-ORM-Llama3.1-70B)和闭源模型(如 GPT-4o) 。

图 3: RM-R1 的训练流程分两步走。第一步:推理链的蒸馏(Distillation of Reasoning Chains),使用高质量的推理链数据对模型进行蒸馏,使其初步具备推理能力。第二步:强化学习(Reinforcement Learning, RL):在蒸馏的基础上,使用可验证的奖励进行强化学习,进一步提升模型的推理能力。

实验验证:RM-R1 如何刷新奖励模型性能

为了全面验证 RM-R1 在奖励建模任务中的有效性,研究团队在 RewardBench, RM-Bench 和 RMB 等多个权威基准上进行了系统性实验。实验设置使用了 7B/14B/32B 的 Qwen-2.5-Instruct 以及 DeepSeek-Distilled-Qwen 作为基础模型。对比了多种训练策略,包括原始模型、监督微调(SFT)以及 RM-R1 提出的推理蒸馏与强化学习结合的策略。主要评估维度是模型的准确率,以及在不同任务类别和难度下的泛化能力。

核心结果:

显著性能提升: RM-R1 模型在所有评估基准上均实现了最先进(SOTA)或接近 SOTA 的性能。例如,RM-R1-DeepSeek-Distilled-Qwen-14B 模型在平均表现上超越了 INF-ORM-Llama3.1-70B、Nemotron-4-340B-Reward 和 GPT-4o,尽管其模型规模远小于这些基线模型。RM-R1-Qwen-Instruct-32B 和 RM-R1-DeepSeek-Distilled-Qwen-32B 进一步扩大了领先优势,在某些基准上,性能提升高达 8.7%。这表明,在奖励建模任务中,模型的「推理能力」比单纯的「模型规模」或「参数数量」更为关键。传统奖励模型可能依赖于从海量数据中学习到的表层模式或统计关联,而 RM-R1 通过 CoR 机制,强制模型进行深层逻辑推理,从而能够更好地理解和判断复杂场景。

卓越的推理能力: 特别是在 RM-Bench(推理密集型基准)上,RM-R1-DeepSeek-Distilled-Qwen-32B 在数学和代码任务中取得了突破性进展,准确率分别达到 91.8% 和 74.1%,远超此前的最佳表现(数学 73%,代码 63%)。这直接证明了 RM-R1 通过其独特的推理训练范式,显著增强了模型的深层推理能力。

模型规模与推理计算的积极影响: 实验还发现,更大的 RM-R1 模型(7B、14B、32B)不仅最终性能更好,而且从推理训练中获得的性能增益也更大,呈现出近乎线性的趋势。同时,增加推理时的计算预算(允许更长的推理链)也能显著提升性能,这进一步验证了深度推理对奖励模型性能的重要性。

鲁棒性与泛化能力(消融研究):消融研究深入剖析了 RM-R1 成功的关键因素。结果表明,单独的强化学习训练不足以弥补与完整 RM-R1 模型之间的性能差距。CoR 提示工程,包括评估准则(Rubrics)和查询分类(Query Categorization),显著优化了奖励模型的推理过程,尤其是在对话、安全和推理任务上。推理蒸馏被证实是性能提升的关键因素,它为模型提供了强大的基础推理能力。

数据效率:基于 Instruct 的模型展现出惊人的数据效率。仅使用 8.7K 蒸馏示例,RM-R1 就达到了与使用 800K 示例训练的 DeepSeek-Distilled 模型相当的竞争性性能。这意味着,通过创新的架构和训练方法(如推理蒸馏和 CoR),可以在相对较小的模型上实现卓越的性能,这对于计算资源有限的团队和实际部署具有巨大的经济和效率优势。

这些实验结果共同表明,RM-R1 的成功暗示了未来奖励模型研究的一个重要方向:不仅仅是扩大模型规模,更要注重提升模型的内在认知和推理能力,使其能够像人类一样「理解」和「思考」偏好,而非仅仅「识别」偏好。

结语:RM-R1 开启奖励建模的新篇章

RM-R1 的提出,不仅提供了一种新的奖励模型训练方法,更开创了一种基于推理的可解释奖励范式,为大型语言模型与人类偏好对齐领域带来了深远的影响。通过大规模实验与深入对比分析,该研究验证了几个核心发现。首先,推理能力是奖励模型的关键要素。RM-R1 将奖励建模重构为一项推理任务,显著提升了模型的准确性,并提供了前所未有的可解释性。其次,两阶段训练范式展现出卓越的高效性。推理蒸馏与强化学习的协同作用,特别是高质量推理链的生成,被证实是其成功的基石。最后,链式评估准则(CoR)机制带来了深度可解释性与卓越性能。通过结构化推理和任务定制化评估,RM-R1 在性能上超越了现有最先进的模型,同时提供了透明的判断依据。通过大规模实验与深入对比分析,文章验证了三个核心发现:

1. 规模带来增益:随着模型变大、计算力增强,RM-R1 的推理链训练方法效果越好,性能几乎线性提升;

2. 简单套用旧 RL 策略行不通:想让模型「会推理」,得精准划分问题类型、并对推理过程进行定向蒸馏训练,才能带来真正泛化的提升;

3. 推理比直接输出答案更通用:相比传统的直接监督,RM-R1 的推理能力更稳健、更易扩展到新任务,即使训练数据少也有优势。

📮欢迎来 repo 提 issue 或交流想法,我们在 GitHub 见~

如需深入了解 RM-R1 的实现细节和实验结果,欢迎访问其论文和代码仓库:

- 论文链接:https://arxiv.org/pdf/2505.02387

- 代码仓库:https://github.com/RM-R1-UIUC/RM-R1

RM-R1 的发布标志着奖励建模领域的一次重要进展,为大语言模型的对齐和可解释性研究提供了新的思路。

#从性能到实战,怎样才算是靠谱的 Agent 产品?

红杉中国团队近日提出了 AI 基准测试工具 Xbench,其双轨测评体系强调了不再单纯执着于测评问题的难度,而是重点量化 AI 系统在真实场景的效用价值。

01. 基准测试要开始关注 AI 的「业务能力」了?

Xbench 是什么来历?为什么评估 Agent 产品需要双轨评估体系?基准测试不能只设计更难的问题?...

02. 什么是长青评估机制?

LLM 与 Agent 产品的测评集有何区别?IRT 如何支撑评估系统的动态更新?...03. 当前的领先模型在「招聘」和「营销」中的表现如何?「招聘」和「营销」任务对 Agent 产品有什么要求?Xbench 如何评估 Agent业务能力?国内外领先模型在「招聘」和「营销」测试中表现如何?...

01 基准测试要开始关注 AI 的「业务能力」了?

红杉中国的研究者近期在论文《xbench: Tracking Agents Productivity, Scaling with Profession-Aligned Real-World Evaluations》中介绍了 XBench 基准测试,并在同期的博文中介绍了该项目的由来和更新过程。

1、Xbench 项目最早在 2022 年启动,起初作为红杉中国内部使用的工具,用于跟踪和评估基础模型的能力,其题库经历过三次更新和演变,后在 2025 年 5 月下旬正式对外公开。

① Xbench 缘起于 2022 年底 ChatGPT 发布,红杉中国开始对主流模型进行月度评测和内部汇报,后于 2023 年开始建设 Xbench 的第一批私有题库,当时主要针对 LLM 和智能体简单问答和逻辑思考能力进行评测。

② 伴随模型能力演进,Xbench 后在 2024 年 10 月进行第二次大规模更新,题目开始上升,关注 LLM 的复杂问答及推理能力,以及简单工具调用能力。

③ Xbench 的第三次升级发生于 2025 年 3 月,红杉团队在该时段开始思考现今模型能力和 AI 实际效用之间的关系,质疑测评题目难度不断升高的意义,及其对 AI 落地的实际经济价值的关联,并发现每次换题后无法追踪 AI 能力的前后可比性。

2、在 5 月公布的论文中,研究者强调了 Xbench 在评估模型技术能力上限的基础上,同样对 LLM-based Agent 在现实工作任务、关键商业指标以及经济产出的实际效能的关注。

① 在博客中,研究者表示 xbench 针对各种商业领域设计评估任务,评估任务由对应领域的专家结合实际业务需求设定,再由大学教授将评估任务转化为评估指标,通过该流程使基准与生产力价值之间建立强相关性。

② 研究者另外强调了 xbench 将工作任务的难度与各个企业的现实需求对齐,而并非单纯追求高难度。

3、出于同时对模型能力和实际「生产力」的关注,Xbench 团队构建了双轨评估体系,并设计了基于基于项目反应理论的长青评估机制,以此测试 AI 技术能力上限,同时量化真实场景效用价值。

① 双轨评估体系将评测任务划分为两条互补的主线。其中,AGI Tracking 用于评估 Agent 的能力上限与技术边界;Profession Aligned 用于量化 AI 系统在真实场景的效用价值。

② 长青评估机制通过持续维护并动态更新测试内容,以确保双轨评估结果具备时效性和相关性。

4、Xbench 首期的 AGI Tracking 线包含科学问题解答测评集(xbench-ScienceQA)与中文互联网深度搜索测评集(xbench-DeepSearch),Profession Aligned 线则提出了面向招聘(Recruitment)和营销(Marketing)领域的垂类 Agent 评测框架。

① 在首期测试中,不同模型在招聘和营销领域的表现存在显著差异,表现最好的模型是 OpenAI 的 o3 在所有测试中排名第一,GPT-4o 由于倾向于提供较短的回答,在评估中得分最低。

② 评估还发现模型的尺寸并非影响其任务表现的决定性因素,谷歌 DeepMind 的 Gemini-2.5-Pro 和 Gemini-2.5-Flash 在测试中的表现相当。

③ 此外,研究者还发现尽管 DeepSeek R1 在数学和代码基准测试中表现出色,但由于其在搜索中心任务上的适应性不足,导致其在此次评估中的表现较低。

02 什么是长青评估机制?

1、长青评估机制是 Xbench 工作提出的「动态更新的评估系统」(Continuously Updated Evaluations),用于规避静态评估集容易出现题目泄露导致过拟合,从而迅速失效的问题。[2-1]

① 研究者指出,Agent 应用的产品版本需要考虑其生命周期。当下的 Agent 产品迭代速率很快,且 Agent 接触的外部环境也在动态变化,同样的题目在不同时间的测试效果均有不同。

② Xbench 团队计划定期测评市场主流 Agent 产品,试图在人力资源、市场营销、金融、法律、销售等领域构建匹配的动态评估机制 ...

#DeepEyes

OpenAI未公开的o3「用图思考」技术,被小红书、西安交大尝试实现了

OpenAI 推出的 o3 推理模型,打破了传统文字思维链的边界 —— 多模态模型首次实现将图像直接融入推理过程。它不仅 “看图”,还能 “用图思考”,开启了视觉与文本推理深度融合的问题求解方式。例如,面对一张物理试卷图像,o3 能自动聚焦公式区域,分析变量关系,并结合知识库推导出答案;在解析建筑图纸时,o3 可在推理过程中旋转或裁剪局部结构,判断承重设计是否合理。这种 “Thinking with Images” 的能力,使 o3 在视觉推理基准测试 V* Bench 上准确率飙升至 95.7%,刷新了多模态模型的推理上限。

然而,OpenAI 如何赋予 o3 这一能力,学界和工业界仍不得而知。为此,小红书团队联合西安交通大学,采用端到端强化学习,在完全不依赖监督微调(SFT)的前提下,激发了大模型 “以图深思” 的潜能,构建出多模态深度思考模型 DeepEyes,首次实现了与 o3 类似的用图像进行思考的能力,并已同步开源相关技术细节,让 “用图像思考” 不再是 OpenAI 专属。

论文地址:https://arxiv.org/abs/2505.14362

项目地址:https://visual-agent.github.io/

Github 地址:https://github.com/Visual-Agent/DeepEyes

用图像进行思考

近期,受到 R1 的启发,出现不少多模态模型采用以文本为核心的思考方式,即 “先看后想”—— 模型先观察图像,再通过纯文本推理来解决复杂的多模态问题。然而,这种方法存在显著局限:一旦进入推理阶段,模型无法 “回看图像” 来补充或验证细节信息,容易导致理解偏差或信息缺失。

相比较之下,更为有效的多模思考方式应是 “边看边想”—— 模型在推理过程中能够动态地调用图像信息,结合视觉与语言的交替交互,从而增强对细节的感知与理解。这种把图像融入思考过程不仅提升了模型应对复杂任务的灵活性,也显著增强了其多模态理解与推理能力。

我们先简单感受一下 DeepEyes 和 o3 是如何结合图像进行推理的!

DeepEyes 与 o3 的推理流程对比

我们使用与 OpenAI o3 官方评测中相同的图像进行测试。测试用户提出问题 “What is written on the sign?”(牌子上写了什么?),DeepEyes 展现出与 o3 类似的 “用图像思考” 的能力,整个过程可分为三步:

第一步:全局视觉分析

模型快速扫描图像,利用自身的视觉感知能力精准锁定画面中的矩形牌子区域,并识别其为文字信息载体。

第二步:智能工具调用

鉴于原图中文字区域分辨率较低,模型自主决策调用图像缩放工具,生成边界框并裁剪放大目标区域,使内容清晰可辨。

第三步:细节推理识别

在清晰图像的基础上,模型结合视觉和文本推理能力,准确识别并输出牌子上的文字:Ochsner URGENT CARE。

整个流程无需依赖任何外部 OCR 工具,纯粹通过模型内部的定位、变换和推理完成识别任务,充分展示了 DeepEyes 原生的 “看图思考” 能力。

DeepEyes:激发模型原生的用图像思考能力

一、模型结构

DeepEyes 的架构与传统多模态推理模型一致,但在推理流程上引入了 “自驱动视觉聚焦” 机制。推理起始阶段,模型首先基于文本内容构建初步思维链。例如,在判断 “手机与背包的位置关系” 这一问题时,模型会生成内部推理如:“需要确定手机与背包的位置,可能需在图像中定位相关物体”。随后,模型根据推理进展判断是否需要图像辅助信息。若问题涉及小物体、模糊区域或细节不清晰的区域,模型将自主生成边界框坐标,裁剪图像中可能包含关键信息的区域(如手机和背包位置),并聚焦这些区域进行深入分析。裁剪图像随后以自回归方式重新输入模型,作为新的视觉证据,与现有文本推理共同作用,驱动后续推理过程更加准确、具备视觉上下文感知能力。

二、如何获得用图像进行思考的能力?从生物进化的角度进行思考

直观来看,如果希望模型掌握利用工具进行图像分析的能力,就应提前准备一批调用工具的思维链数据,并通过监督微调(SFT)逐步训练模型,从模仿过渡到真正掌握这种能力。不少多模态模型会采用「先监督,后强化」的训练路径:先用推理数据进行冷启动,让模型 “学会思考”,再通过强化学习(RL)提升其推理上限。

不过,这种能力形成的路径与生物进化迥异。例如,生活在约 3.75 亿年前的提塔利克鱼是鱼类向陆生脊椎动物演化的关键过渡物种。它并非通过模仿其他生物在陆地上的行为获得生存能力,而是在水陆环境差异巨大、旧能力难以应对新环境时,原生出一种全新的适应机制 [Nature. 440 (7085): 757–763]。

类比来看,如果将大模型视作一种 “生物”,是否也能在训练环境和奖励结构发生巨大变化时,像提塔利克鱼一样,激发出原本不具备的新能力?

三、基于 outcome-based 奖励的端到端强化学习策略

受提塔利克鱼进化机制的启发,我们设计了一套具备难度差异的数据集,用于有效激发大模型的工具使用能力。数据筛选和构建遵循以下三项原则:(1)剔除过难或过易的问题;(2)优先选取通过图像分析工具可以显著提升信息增益的样本;(3)补充传统推理数据,以维持图像领域的推理能力。数据集的构建细节可参考原文及代码实现。

在这套具备难度与奖励差异的数据集上,我们发现,即使不经过 SFT 冷启动,仅依赖端到端的强化学习,也能有效激发模型的调用工具进行图像推理的能力。具体来说,DeepEyes 使用了如下的 outcome-based 奖励函数:

奖励函数分为准确率奖励,格式奖励,以及条件工具奖励。准确率奖励和格式奖励与 R1 的奖励类似,而条件工具奖励则是只有当模型正确回答且正确使用工具才会给予额外的奖励,指导模型在必要时候使用工具。

在上述奖励函数的激励下,DeepEyes 将在学习用图像推理的过程中,从最开始的「盲目尝试」,再到后期的「有效调用」,呈现出了与人类类似的学习模式。具体而言,学习过程可以分为三个阶段:

1. 懵懂期(前 20 步):DeepEyes 像新手一样乱点屏幕,随便框选区域,结果十次有九次「瞄错地方」,准确率较差;

2. 探索期(20-45 步):DeepEyes 开启「广撒网模式」,疯狂调用工具缩放各种区域,虽然准确率提升,但像「多动症患者」一样生成冗长响应;

3. 成熟期(45 步后):DeepEyes 突然「开悟」,学会先在脑子里「预判」关键区域,再精准缩放验证,工具调用次数不断减少,准确率却持续提升。

DeepEyes 性能评估

DeepEyes 在多个测试集上表现出色,尤其在视觉搜索任务中展现出领先优势。在 V* Bench 上取得了 90.1 的准确率,在 HR-Bench 上也大幅超越现有的基于工作流的方法。另外,DeepEyes 7B 模型在视觉搜索任务中显出高于 Qwen-VL 32B 模型,这也进一步说明了构建用图像思考能力的必要性。

值得一提的是,DeepEyes 在无需调用任何外部工具的情况下,便具备出色的图像定位与理解能力,这些能力完全由模型自身学习获得。同时,当需要更高精度时,DeepEyes 也可以选择调用工具对图像细节进行确认,从而在降低幻觉方面取得改进。

此外,除了视觉感知,DeepEyes 的数学推理能力也有明显提升,展现出多模态模型在跨任务能力上的潜力。

DeepEyes 的独特优势

与传统的基于工作流或纯文本推理的模型相比,DeepEyes 具备以下关键优势:

1. 训练更简洁:传统方法依赖大量难以构建的 SFT 数据,而 DeepEyes 仅需问答对即可训练,大幅降低数据获取门槛。

2. 更强泛化能力:基于工作流的模型受限于人工规则设计,适用范围有限。DeepEyes 通过端到端强化学习,能在不同任务中动态选择推理路径,展现出跨任务泛化能力。

3. 端到端联合优化:工作流方法通常对各子模块独立优化,容易陷入次优。DeepEyes 通过端到端强化学习实现全局联合优化,显著提升整体性能。

4. 深度多模态融合:相比纯文本推理,DeepEyes 构建融合视觉与文本的思维链,在推理过程中动态交织图像与语言信息,提升感知与决策精度。

5. 原生工具调用能力:DeepEyes 依靠内生视觉定位能力而非外部工具,能原生执行 “图像思考” 流程。工具使用过程可被直接优化,实现更高效、更准确的图像辅助推理,这是传统外部调用方法所不具备的能力。

结语

DeepEyes 展示了多模态推理模型的新范式:无需依赖复杂工作流或大规模监督数据,通过端到端强化学习,即可实现视觉与文本深度融合、原生工具调用和动态推理路径选择。它不仅降低了训练门槛,还显著提升了泛化能力和整体性能。在多个视觉推理任务中,DeepEyes 已成功展现出与 OpenAI o3 相当的 “图像思考” 能力,为开放世界的多模态智能探索提供了切实可行的新路径。

作者介绍

本文作者来自小红书和西安交通大学,其中郑子维、Michael Yang、Jack Hong 和 Chenxiao Zhao 为共同一作,排名不分先后。郑子维,就读于西安交通大学,主要研究方向是 VLM Reasoning、Agent 以及视频理解;Michael Yang 的研究方向是 RL、LLM Reasoning 以及 Agent;Jack Hong 的研究方向为多模态大模型、LLM Reasoning 以及计算机视觉;Chenxiao Zhao 是小红书 Hi Lab 算法研究员,主要研究方向是 RL。该工作是郑子维、Michael Yang 和 Jack Hong 在小红书实习期间完成。