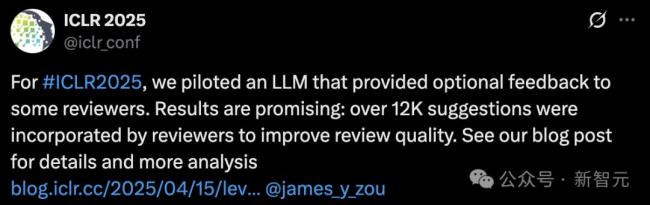

AI审稿首次席卷ICLR 2025,12222条建议被接受!

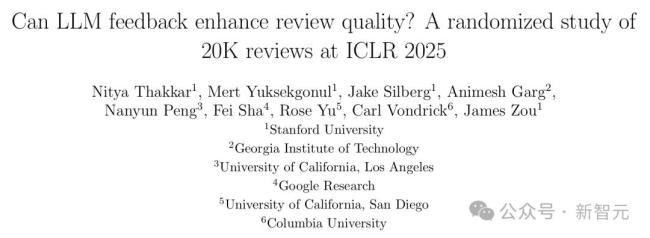

AI审稿首次席卷ICLR 2025,12222条建议被接受!ICLR 2025正式开启了审稿周期,并首次引入了大模型参与评审。根据最新公布的结果,AI智能体提供了12,222条建议,被审稿人采纳,显著提高了评审质量。ICLR还发布了一份30页的详细报告,介绍了实验中AI在学术评审中的巨大潜力。

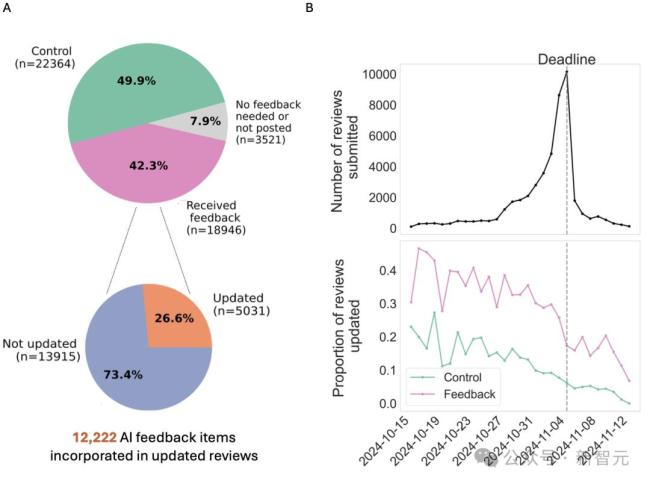

研究显示,有26.6%的审稿人根据AI的建议更新了评审,反馈使审稿意见平均增加了80个字,从而提供了更丰富的反馈。此外,AI反馈还在Rebuttal期间提升了讨论活跃度,作者和审稿人的回应篇幅都有所增加。然而,在最终论文的录用结果方面,反馈组和对照组之间没有显著差异,这与设计目标一致。

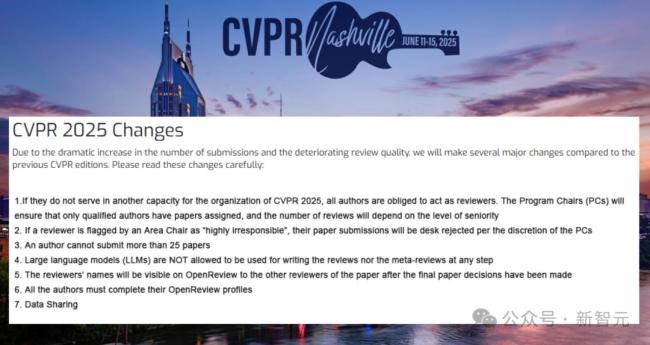

ICLR是目前唯一允许AI参与审稿的AI顶会。此前,CVPR 2025曾禁止使用LLM参与审稿。ICLR组委会采纳AI建议的原因在于同行评审面临日益严峻的压力,尤其是随着论文投稿量的迅速增长。低质量的反馈不仅让作者不满,还影响了学术交流效率。据统计,ICLR 2024年约有10.6%的审稿人利用LLM辅助完成评审。

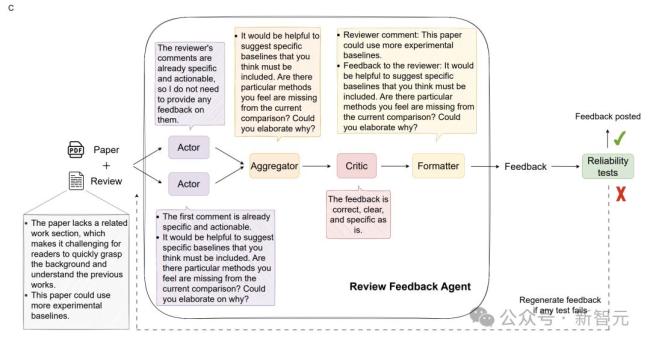

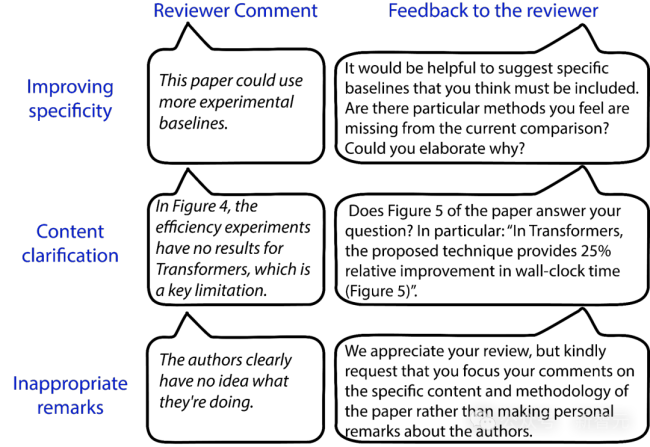

为了提升评审质量,ICLR 2025为每位审稿人分配了最多3篇论文,并引入了“评审反馈智能体”,识别审查中的问题并向审稿人提供改进建议。这些建议包括鼓励审稿人改写含糊的评论,突出文章中可能已经回答的问题部分,以及处理不专业、不恰当的言论。

这项试点研究由ICLR联手OpenReview进行,以Claude Sonnet 3.5为核心模型,构建了一个由五个大语言模型协作的系统。在四周内,AI智能体为18,946份随机选取的ICLR评审提供了反馈,占总评审量的42.3%。平均每份评审通过整个处理流程大约耗时1分钟,成本约为50美分。

实验结果显示,收到反馈的评审比未收到反馈的评审更新可能性高17%,且评审长度显著增加。分析表明,89%的评审者至少采纳了一条反馈,总体共有12,222条反馈项被采纳并融入修订后的评审意见中。此外,采纳反馈的评审更清晰、具体、可操作,显著提升了评审质量。

在反驳过程中,反馈组的作者反驳篇幅比对照组长6%,审稿人回应反驳的回复也更长,修改评分的比例更高。研究者对AI智能体提供的69,836条反馈进行了聚类分析,发现大多数反馈针对审稿意见的模糊评论,旨在使其更具体、可操作、论证充分。

相关文章

秋葵再次成为养生热门!医生提醒:吃秋葵时,这3点一定要牢记 科学食用更健康

肥娟获赠100桶冰淇淋 小店经营意外走红

这根本不是对等关税而是空气税 引发全球投资者紧张

省长、部长等职上 唐仁健收受巨额财物 涉嫌受贿被公诉

中国女冰取首胜 逆转世界排名最低对手 保组形势向好 关键战告捷

男子贪图报酬帮人代取诈骗包裹被抓 高薪诱惑下的陷阱

4月楼市变局,三大结局前瞻!

美媒:15年过去美国还是没搞定稀土 政策与产业进展缓慢

中国管制稀土出口对西方影响有多大 威胁美国军事能力

中纪委老将率队赴昆明 市委书记表态!

美媒曝特朗普政府计划减半美国国务院预算 大幅削减或关闭近30使团

遇见小面年入11亿每单赚1块4 快速扩张助力上市

韩国一女子打开客机紧急出口 自称有幽闭恐惧症

敦煌网创始人曾在清华大学任教 从清华女老师到电商领军人

布彭扎家人:布彭扎不可能自杀;他因为高薪而被人仇视 谋杀猜测未证实

中方代表呼吁国际社会加大对南苏丹援助力度

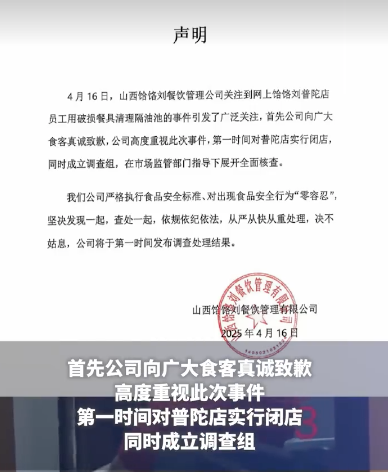

多方回应饭店员工用碗清理下水道:山西饸饹刘餐饮公司致歉

全美经济最强州起诉特朗普政府 关税政策引发争议

理疗馆给半岁婴儿刮痧引争议 官方已介入核查

- 看多看好中国依然是众多外资企业的共识 外资企业尽展优势

- 呼吁理解!刘国梁解读奥运蓝图:给年轻人机会,期待续写辉煌

- 雷军感谢大家支持小米手机 激活量登顶市场第一

- 为挽救客源 加州州长录旅游宣传视频 吸引加拿大游客

- 极端大风吹过你家了吗 屋顶消失引热议

- 克雷桑7轮造9球身价已涨5倍 中超最贵外援闪耀赛场

- 郑州多家酒店举报携程平台私自调价 商家权益受损引争议

- 全国多地25条河流发生超警以上洪水 多河段水位创历史新高

- 北京城区暴雨为何比预报下得大 副高外围影响加剧

- 外卖大战的订单冲爆咖啡奶茶店 补贴战引发销量激增

- 韩媒:蓉城旧将安德里戈加盟水原FC,合同为期六个月 租借期满寻新东家

- 本升专?职业技术学院3专业招本科生 职业教育新趋势