📖标题:One-shot Entropy Minimization

🌐来源:arXiv, 2505.20282

🌟摘要

我们训练了 13,440 个大型语言模型,发现熵最小化只需要一个未标记的数据和 10 步优化,以实现比使用数千个数据获得的性能改进,并在基于规则的强化学习中精心设计的奖励。这种惊人的结果可能会促使重新思考大型语言模型的训练后范式。我们的代码可在 https://github.com/zitian-gao/one-shot-em 获得。

🛎️文章简介

🔸研究问题:如何实现一种有效的无监督方法来提升大语言模型(LLM)的推理能力,而不需要大量的标注数据?

🔸主要贡献:论文提出了一种名为“一次性熵最小化”(One-shot EM)的方法,该方法在无监督的情况下,实现了与传统强化学习相当甚至更优的模型性能。

📝重点思路

🔸使用熵最小化(EM)算法来减少模型在生成过程中对自身预测的不确定性,鼓励模型在生成的每一步中聚焦于高概率的正确答案。

🔸通过基于方差的数据选择策略来优先选择那些在多个采样中表现出最高行为方差的输入,以促进熵驱动的优化。

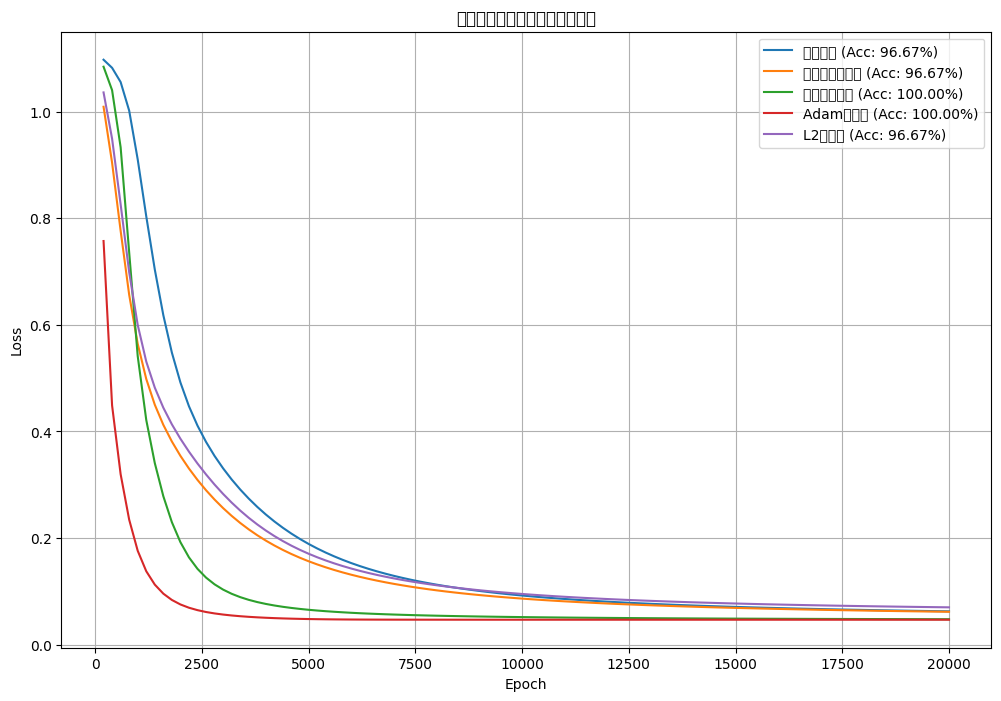

🔸进行了一系列实验,以评估EM在不同基线模型上的表现,并分析温度对训练和推理的影响。

🔸探讨了数据选择目标的设定和模型的预测不确定性如何引导参数更新。

🔎分析总结

🔸实验结果表明,仅使用一个样本的EM方法在多个数学推理基准上表现出了显著的性能提升,显示了该方法的高效性和快速收敛性。

🔸EM训练后的模型表现出更高的置信度和更一致的输出,通过对浮动质点分布的分析,EM显著增强了高概率推理路径的有效性。

🔸研究发现,EM在提升模型表现时要求更少的样本和计算资源,与强化学习相比,其需求大幅降低,同时在一些情况下可能会导致模型过于自信,影响性能。

🔸通过对数量样本和样本长度的基础研究,论文指出一键EM的训练动力学显示出更稳定的输出,从而减少了样本偏差。

💡个人观点

论文的核心在在于通过熵最小化机制来优化模型输出分布,并基于此来选择高方差数据,显著增加了模型的收敛效率。

🧩附录

![MYOJ_4149:(洛谷P1002)[NOIP 2002 普及组] 过河卒(坐标型DP)](https://i-blog.csdnimg.cn/direct/7d522ec8a8924c138b18d13f3e1f775d.png)