Dify对比主流大模型开发框架:Langchain、LlamaIndex、n8n,谁更适合企业落地?

随着大模型(LLM)技术的迅猛发展,智能体(Agent)开发从实验室走向企业生产环境。开发者对大模型开发框架的需求日益增长,不仅需要支持复杂业务流程、RAG(检索增强生成)、多模态接入,还必须兼顾易用性与扩展性。

在这股浪潮中,Dify以“全流程可视化开发+开箱即用”的定位成为热门开源框架之一。然而,面对Langchain、LlamaIndex、n8n等竞品,Dify是否能够在企业级应用中脱颖而出?本文将从架构、功能、落地部署和运维角度进行深入对比,并探讨如何高效利用Dify实现分布式部署和业务集成。

一、主流框架全景对比

| 框架 | 主要定位 | 技术特性 | 优势 | 挑战 |

|---|---|---|---|---|

| Dify | 大模型应用开发平台 | 低代码、可视化、支持RAG与Agent、Docker部署友好 | 快速上手、支持企业落地、接口开放 | 定制能力受限、深度扩展需投入 |

| Langchain | 通用LLM开发框架 | 高度模块化、强灵活性、支持多LLM与RAG | 适合底层开发、可定制性强 | 学习曲线陡峭、部署复杂 |

| LlamaIndex | 数据连接与RAG | 数据接入灵活、支持多存储 | 数据层聚焦,适合研发验证 | 部署能力有限、需要与Langchain等配合 |

| n8n | 自动化与工作流 | 高度可定制工作流、支持插件扩展 | 支持多任务自动化、适合复杂流程 | 与LLM深度集成需额外开发 |

二、Dify在企业落地中的优势

1. 开发效率优先

Dify主打“开箱即用”,通过可视化和模块化显著降低开发门槛,适合中小企业快速构建应用,尤其适合20人以内的算法团队。

2. 一体化平台

不仅支持对话、RAG、Agent,还内置了用户管理、日志监控、任务流控制和API接口,减少集成成本。

3. 易部署特性

支持Docker Compose部署,便于本地开发和调试;同时支持Kubernetes等云原生平台,可实现高可用生产部署,适应企业私有云、混合云需求。

4. API与插件支持

虽然封装度较高,但通过API层和插件机制(如插件远程安装与INNER_API_KEY接口),Dify可与企业自有服务、底层大模型实现无缝对接,灵活应对多样场景。

三、深度定制与分布式部署的挑战

核心问题

-

定制灵活性受限:高度封装导致业务特殊需求(如自定义RAG流程、QPS优化、多模态需求)需二次开发。

-

分布式扩展复杂:虽然支持Docker,但生产部署需要结合分布式存储、独立数据库、任务调度器,架构设计难度大。

-

数据隔离与安全:企业级多租户部署需设计完善的权限控制和数据隔离策略。

解决路径

-

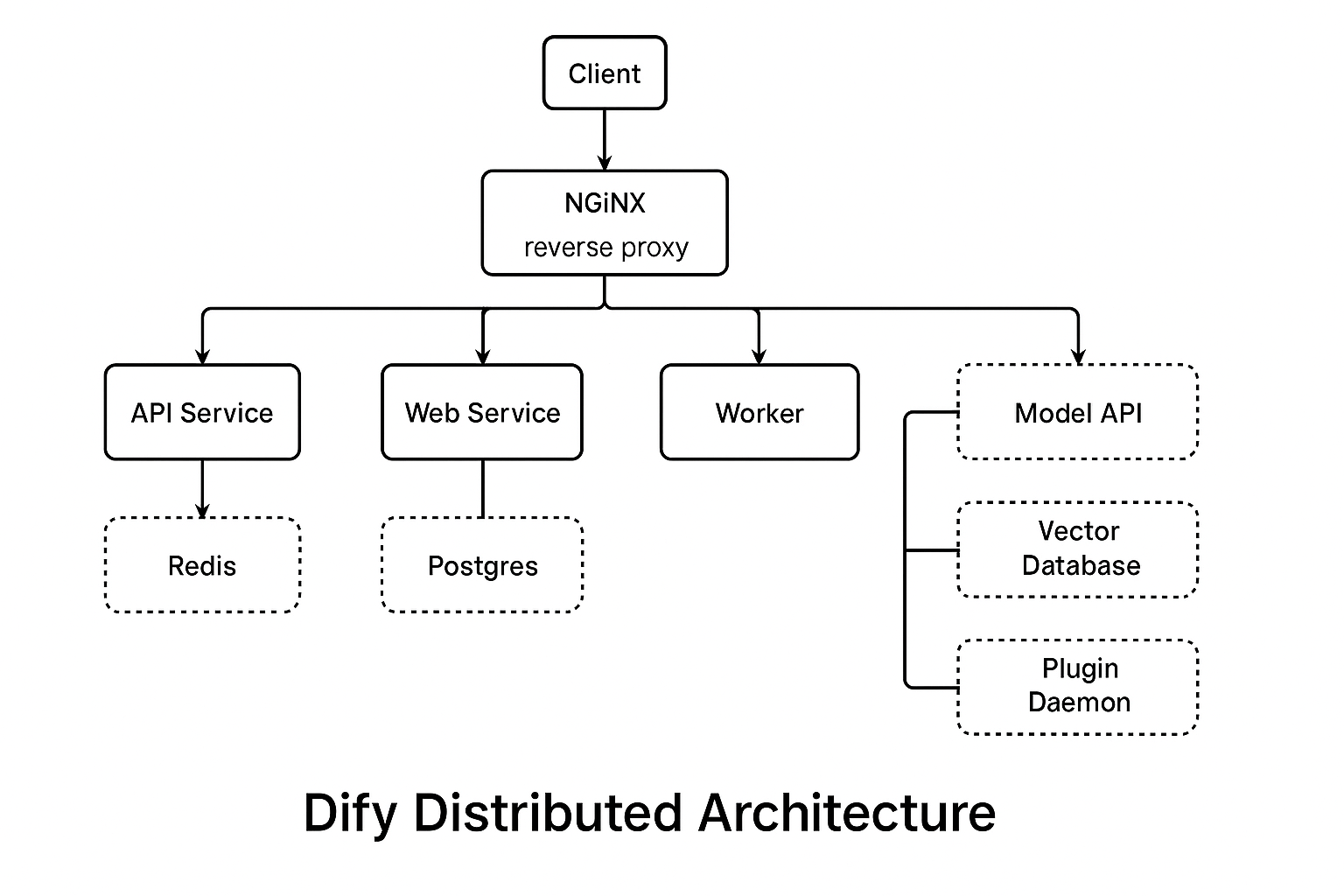

采用分布式架构:独立高负载模块(如RAG、索引、存储),结合云原生(K8s、Serverless)实现弹性扩展。

-

加强运维与监控:配备0.5-1人专业运维,建立独立测试环境、灰度发布和日志分析系统。

-

结合底层框架对接:通过API或SDK与Langchain、LlamaIndex集成,释放底层能力,构建企业专属的智能中台。

四、如何选择框架?

-

小团队/快速验证:Dify是理想选择,开发上手快,部署成本低,适合中小企业验证RAG/Agent应用。

-

大规模产线落地:Dify可作为中台,结合Langchain等底层框架扩展,但需要运维与架构设计投入。

-

底层能力需求强:若需全链路定制与高QPS支持,可考虑直接基于Langchain/LlamaIndex,自研控制。

五、结语:Dify的定位与未来

Dify的优势在于“快速开发与可落地”,但在大规模企业应用中,必须强化分布式部署与定制扩展能力。与Langchain、LlamaIndex等底层框架相比,Dify代表了一种“中台即服务(PaaS)”的发展趋势,有望在企业智能化转型中扮演重要角色。

企业在选择框架时,关键在于明确自身业务需求、技术能力和成本投入,避免“盲选”而导致后期成本增加。

欢迎在评论区分享你的观点:你认为Dify适合你的业务场景吗?如何看待Langchain和LlamaIndex?