摘要:多模态大语言模型(MLLM)的最新进展显著提高了2D视觉任务的性能。 然而,提高他们的空间智能仍然是一个挑战。 现有的3D MLLM总是依赖于额外的3D或2.5D数据来加入空间感知,限制了它们在只有2D输入(如图像或视频)的场景中的实用性。 在本文中,我们提出了Spatial-MLLM,这是一种基于视觉的纯二维观察空间推理的新框架。 与传统的视频MLLM不同,传统的视频MLLM依赖于基于CLIP的视觉编码器,这些编码器针对语义理解进行了优化,我们的关键见解是从前馈视觉几何基础模型中释放出强大的结构先验。 具体而言,我们提出了一种双编码器架构:一个预训练的2D视觉编码器用于提取语义特征,以及一个从视觉几何模型主干初始化的空间编码器,用于提取3D结构特征。 然后,连接器将这两个特征整合到统一的视觉标记中,以增强空间理解。 此外,我们提出了一个在推理时具有空间感知的帧采样策略,该策略选择视频序列中具有空间信息的帧,确保即使在有限的标记长度下,模型也能关注对空间推理至关重要的帧。 除了架构改进之外,我们还构建了Spatial-MLLM-120k数据集,并使用监督微调和GRPO对其进行模型训练。 在各种真实世界数据集上的广泛实验表明,我们的空间机器学习模型在广泛的基于视觉的空间理解和推理任务中达到了最先进的性能。 项目主页:Github。Huggingface链接:Paper page,论文链接:2505.23747

一、研究背景和目的

研究背景:

近年来,多模态大语言模型(Multimodal Large Language Models, MLLMs)在处理和理解多模态输入(如图像、视频和音频)方面取得了显著进展,极大地提升了2D视觉任务的性能。然而,这些模型在空间智能(spatial intelligence)方面的表现仍然有限。空间智能指的是模型对3D场景的理解和推理能力,这在许多实际应用中至关重要,如机器人导航、增强现实和虚拟现实等。

现有的3D MLLMs通常依赖于额外的3D或2.5D数据(如点云、相机参数或深度图)来增强空间感知能力。然而,这种依赖性限制了模型在只有2D输入(如图像或视频)的场景中的实用性。在许多现实世界的应用中,仅能获取到2D视频数据,而无法获得额外的3D或2.5D信息。因此,如何从纯2D观察中有效地进行基于视觉的空间推理,成为了一个亟待解决的问题。

研究目的:

本文旨在提出一种名为Spatial-MLLM的新框架,以增强MLLM在基于视觉的空间智能方面的能力。具体目标包括:

- 设计一种无需额外3D或2.5D数据的空间推理框架:通过利用前馈视觉几何基础模型提供的强大结构先验,从纯2D观察中提取空间信息。

- 提出一种双编码器架构:结合预训练的2D视觉编码器和空间编码器,分别提取语义特征和3D结构特征,并通过连接器将它们整合成统一的视觉标记。

- 开发一种空间感知的帧采样策略:在推理过程中选择具有空间信息的帧,确保模型在有限的标记长度下关注对空间推理至关重要的帧。

- 构建Spatial-MLLM-120k数据集:并使用监督微调和GRPO(Group Relative Policy Optimization)对模型进行训练,以在多种基于视觉的空间理解和推理任务中达到最先进的性能。

二、研究方法

1. 双编码器架构:

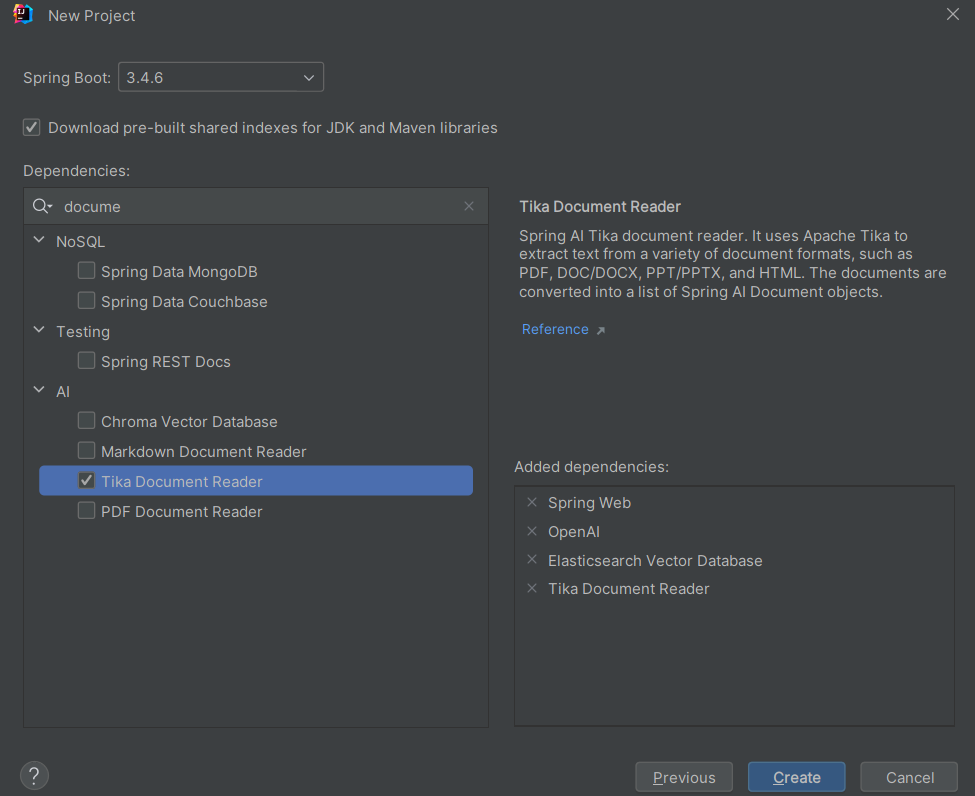

- 2D视觉编码器:采用预训练的2D视觉编码器(如Qwen2.5-VL中的视觉编码器)来提取输入帧的语义特征。

- 空间编码器:利用视觉几何基础模型(如VGGT)的主干初始化空间编码器,以提取3D结构特征。空间编码器通过交替的帧级自注意力和全局自注意力来聚合不同帧之间的空间信息。

- 连接器:将2D和3D特征在空间和时间维度上对齐,并通过两个轻量级的多层感知机(MLP)将它们融合成统一的视觉标记。

2. 空间感知的帧采样策略:

- 在推理过程中,由于GPU内存限制,只能处理视频序列中的有限子集帧。本文提出了一种空间感知的帧采样策略,通过最大化覆盖场景中的独特体素来选择最具空间信息的帧。

- 具体而言,首先均匀采样一定数量的候选帧,然后利用空间编码器提取它们的3D特征,并通过预训练的相机头和深度头解码出相机参数和深度图。

- 接着,将深度图重新投影到3D点云,并计算每个帧覆盖的体素。最后,使用贪心算法选择覆盖最多独特体素的帧。

3. 数据集构建与模型训练:

- Spatial-MLLM-120k数据集:从ScanQA、SQA3D以及自行创建的空间问答数据中收集而成,涵盖了各种空间理解和推理任务,如对象计数、对象大小、房间大小、绝对距离、出现顺序、相对距离和相对方向等。

- 监督微调(SFT):在Spatial-MLLM-120k数据集上对模型进行监督微调,冻结2D视觉编码器和空间编码器的参数,仅训练连接器和LLM主干。

- 强化学习(RL)训练:在SFT之后,使用GRPO算法对模型进行进一步训练,以增强其长链思考(long-CoT)空间推理能力。设计了一个任务依赖的奖励函数,以准确反映预测答案与真实答案之间的接近程度。

三、研究结果

1. 定量评估:

- 在VSI-Bench、ScanQA和SQA3D等多个基准数据集上进行了广泛实验,结果表明Spatial-MLLM在多种基于视觉的空间理解和推理任务中达到了最先进的性能。

- 特别是在VSI-Bench数据集上,尽管Spatial-MLLM仅使用了16个输入帧,但其平均准确率仍显著高于其他模型,包括参数规模更大的模型(如Gemini-1.5Pro)。

- 在ScanQA和SQA3D数据集上,Spatial-MLLM也显著优于所有仅使用视频输入的模型,并在某些指标上超过了使用额外3D或2.5D输入的模型。

2. 定性分析:

- 通过可视化空间感知的帧采样策略,展示了该策略如何选择更具空间信息的帧,从而提高了模型的空间推理能力。

- 提供了模型在VSI-Bench数据集上的定性示例,展示了模型如何进行视觉信息的推理,并产生相应的最终答案。这些示例表明,Spatial-MLLM能够有效地分解任务、进行自我验证,并在推理过程中展现出强大的能力。

3. 消融实验:

- 评估了RL训练的有效性,表明即使在小规模的GRPO训练下,Spatial-MLLM也能实现性能提升。

- 验证了Spatial-MLLM架构的有效性,表明双编码器设计和连接器的融合策略显著提高了模型的空间理解和推理能力。

- 分析了空间感知帧采样策略的有效性,表明该策略在相同数量的输入帧下始终优于均匀采样。

四、研究局限

尽管Spatial-MLLM在基于视觉的空间智能方面取得了显著进展,但仍存在一些局限性:

- 模型规模和训练数据的限制:目前Spatial-MLLM的模型规模和训练数据量仍有提升空间。未来可以探索更大规模的模型和更丰富的训练数据,以进一步提升性能。

- 一般视频理解和推理任务的探索不足:本文主要关注基于视觉的空间智能任务,对于一般视频理解和推理任务的探索相对较少。未来可以研究如何将空间结构信息集成到一般视频理解和推理任务中,以进一步提升模型的通用性。

- 实时性能的挑战:在实际应用中,实时性能是一个重要的考虑因素。尽管Spatial-MLLM在推理过程中采用了空间感知的帧采样策略来减少计算量,但仍需进一步优化以提高实时性能。

五、未来研究方向

基于Spatial-MLLM的研究成果和局限性,未来可以从以下几个方面进行深入研究:

- 扩大模型规模和训练数据:

- 探索更大规模的模型架构,如使用更多的参数和更深的网络结构,以提升模型的空间理解和推理能力。

- 收集更多样化和丰富的训练数据,特别是包含复杂3D场景和多样化空间关系的数据,以进一步提高模型的泛化能力。

- 优化空间感知的帧采样策略:

- 研究更高效的帧采样算法,以在保持空间信息完整性的同时进一步减少计算量。

- 探索动态帧采样策略,根据视频内容的变化自适应地调整采样帧的数量和位置。

- 集成空间结构信息到一般视频理解和推理任务:

- 研究如何将Spatial-MLLM中的空间结构信息集成到一般视频理解和推理任务中,如视频分类、动作识别和视频问答等。

- 开发新的模型架构和训练方法,以同时利用空间和时间信息来提升视频理解和推理的性能。

- 提升实时性能:

- 优化模型的推理过程,减少不必要的计算和内存访问,以提高实时性能。

- 探索硬件加速技术,如使用GPU或TPU等专用硬件来加速模型的推理过程。

- 探索跨模态学习和应用:

- 研究如何将Spatial-MLLM与其他模态(如音频、文本等)的信息进行有效融合,以实现更全面的多模态理解和推理。

- 探索Spatial-MLLM在跨模态应用中的潜力,如语音导航、视频描述生成和智能监控等。

- 加强可解释性和可信度研究:

- 研究如何提高Spatial-MLLM的可解释性,使模型的决策过程更加透明和可信。

- 开发新的评估指标和方法,以全面评估模型在空间智能任务中的性能和可信度。

综上所述,Spatial-MLLM为增强MLLM在基于视觉的空间智能方面的能力提供了一种新的框架和方法。未来的研究可以围绕扩大模型规模和训练数据、优化空间感知的帧采样策略、集成空间结构信息到一般视频理解和推理任务、提升实时性能、探索跨模态学习和应用以及加强可解释性和可信度研究等方面展开,以进一步推动该领域的发展。